文章伪原创工具(搜索引擎来说怎么去发现重复内容要怎么做呢?(图))

优采云 发布时间: 2022-02-14 13:26文章伪原创工具(搜索引擎来说怎么去发现重复内容要怎么做呢?(图))

如果我们复制一篇文章文章,但是我们使用了不同的标题,那么对于搜索引擎来说,他在下层找不到它是重复的,一个克隆的网站,因为标题不同

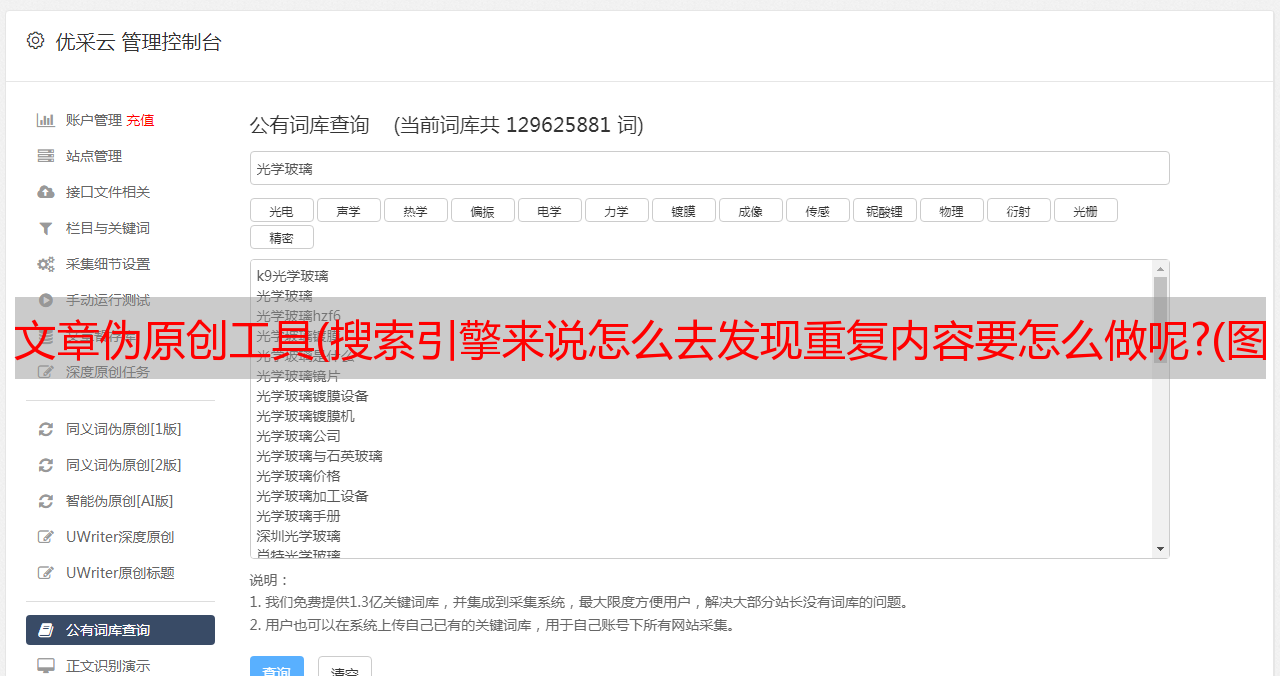

图 26695-1:

他对重复数据删除算法进行了开发和升级。简单来说就是最初的Shingle算法,然后SuperShinge算法升级为I-Match算法,再升级为SimHash算法。现在各个搜索引擎的算法都是建立在这些基础之上的。算法升级改进,大体原理我们可以理解。

简单来说,搜索引擎给每个页面一个指纹,每个页面由许多小模块分层,一个页面由许多小模块组成,就像一个指纹是由许多行组成的。

如果我们知道这个原理,我们就会知道现在大家都在做的伪原创是没用的。打乱段落顺序,更改部分单词不会影响页面指纹。

确实可以复制别人的内容,但是如果不被判断为重复内容怎么办?

首先,了解一个机制。搜索引擎存储的页面数据是分层的。简单来说,当你输入一个搜索词时,它会优先考虑高质量层的数据,其次是普通层和劣质层。我平时看到的很多高权重平台的内页排名也能超过很多网站首页。这是有原因的。

当两个 网站 程序几乎相同的代码和几乎相同的内容时,搜索引擎如何发现它们是重复的?

由于搜索引擎存储的数据量非常大,不可能每次存储一个新页面时都比较之前存储的所有页面。那么他只能通过算法判断与新页面的标题描述相关的高质量层的页面。将重复性与新页面进行比较。如果重复程度达到一定值,则判断为重复内容,通过去重算法将其去除,不再为收录。如果不被判断为重复内容,则会收录到下层。当你想优化这个新页面以提高它的排名,进入优质层时,它的相应要求也会增加,它会检索更多的页面数据与它进行比较,不仅仅是通过检索相关标题所描述的数据。这种情况下,会被搜索引擎发现,不是原创,综合评价不给优质层。

这也是我们看到的一个现象,为什么很多复制的内容都可以收录,却没有办法获得好的排名。

如果我们复制了一篇文章文章,但是我们使用了不同的标题,那么对于搜索引擎来说,他没有办法在劣质层发现它是重复的。这也解释了很多奇怪的现象,比如图片:

图 26695-2:

一个克隆的网站,因为标题不同,在爬取去重的过程中搜索引擎没有找到,但是如果页面要进入premium tier数据库,就会发现是重复的,否 它将给出一个很好的排名显示。

总结:市面上的伪原创工具没用,对你要的页面指纹没有影响。如果你必须复制别人的修改标题,你将不会得到一个好的排名。在新站点的早期,您可以通过更改标题添加 收录 和 网站 蜘蛛。在中期,您必须创建自己的内容来为良好的排名铺平道路。