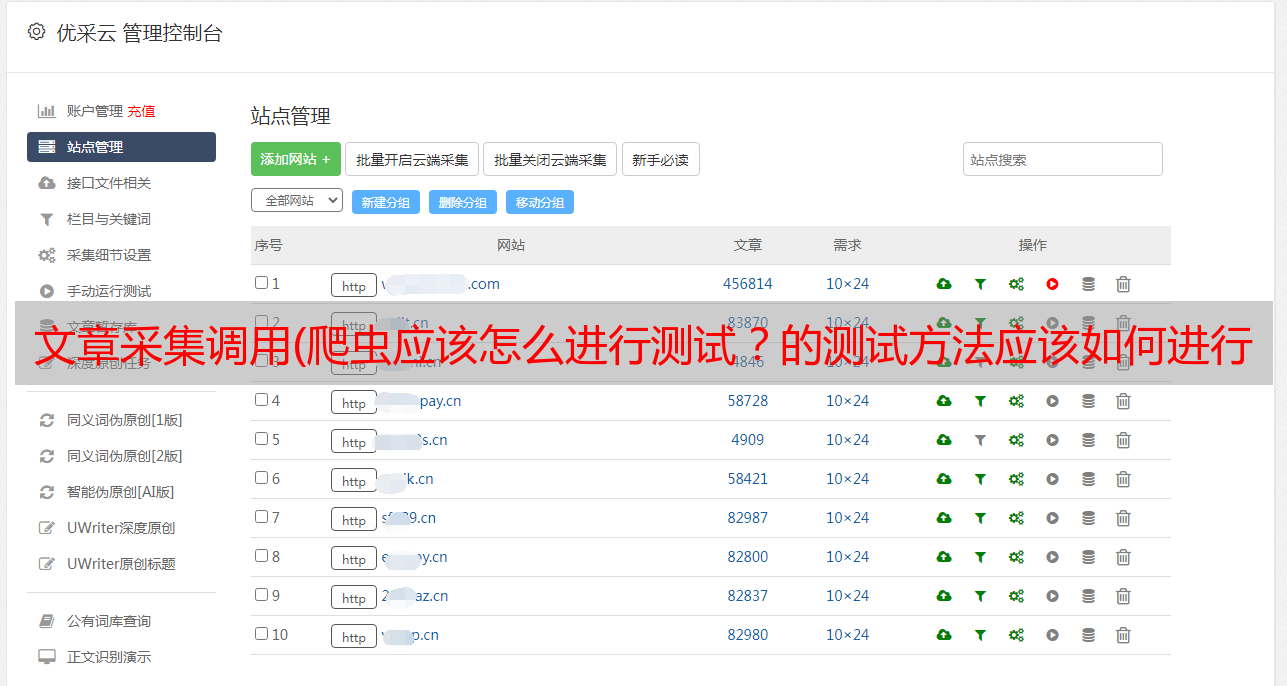

文章采集调用(爬虫应该怎么进行测试?的测试方法应该如何进行?)

优采云 发布时间: 2022-02-10 13:18文章采集调用(爬虫应该怎么进行测试?的测试方法应该如何进行?)

很多同学不知道应该如何测试爬虫。我也是刚接触一点爬虫测试的新手。通过对爬虫的分析,总结了爬虫的测试方法。其他建议欢迎补充。

一、测试阶段

对于data采集调用第三方平台(比如scorpion)的流程大家可能比较熟悉。在第三方页面授权后,第三方会帮我们完成data采集的任务。我们只需要等待结果被回调。但是如果要自己做爬虫,又是一个什么样的过程呢?

其实爬虫和其他业务一样,也是有流程的。一般是先触发创建任务,爬虫模块对数据采集进行处理,采集完成后,对数据进行解析和存储。对于授权爬虫来说,有SDK页面的也可以直接通过页面进行请求,其他的只能通过请求接口实现。还有一种爬虫,在后台配置好任务后,会定期去网站爬取数据,更新数据库。当然还有很多其他的交互逻辑,每一步都需要分析评估。

因此,我们可以从创建任务的界面入手,连接整个流程,在界面的响应中加入简单的验证。比如创建任务后有任务编号,通过查询接口可以得到任务的结果数据。然后检查数据是否存储,存储是否准确,是否会出现乱码等。从界面入手的好处是我们可以自动化检查爬虫任务,检查数据是否可以创建,是否爬虫能否正常爬取,爬取结果是否入库。解析的逻辑和存储的准确性需要注意。爬虫结果数据的存储与数据分析和应用有关。对于数据分析,如果源数据有误,那么无论分析结果如何,都是没有意义的。.

总结

1.接口测试,调用数据接口采集,测试爬虫进程;接口基础测试和弱网、接口安全、接口性能等。

2.可以通过接口或者SDK测试场景,包括爬取成功的场景和失败的场景,比如无数据和无效数据。

3.完成采集后的分析和存储测试,数据分析和存储逻辑检查。

4.异常测试,主要针对系统间交互的处理逻辑,如失败重试机制、服务间容错机制等。

5.爬虫质量和效率,主要从整体设计和代码实现来分析爬虫的处理方式是否高可用。

二、在线阶段

一旦爬虫上线供其他业务方使用,就需要保证可用性和可靠性。对于爬虫来说,在线监控非常重要!不仅要保证提供的爬虫能够正常运行,还要保证出现异常时,能够在最短的时间内解决。因此,监测应从以下三个方面入手:

1.在线运行接口脚本监控提供的接口可以正常使用,而不是等业务方调整好基础接口,再反馈修复,成本比较大。主动调整界面,判断程序是否正常。您只能验证该接口是否可以运行。如果条件允许,在线运行真实数据并验证结果。

2.监控线上发生的异常情况,如创建任务失败、登录失败、数据采集失败、数据解析失败、回调失败、数据存储失败等。发展应尽快查明原因,尽快找到解决。

3.监控目标网站的状态,可以通过web自动监控目标网站是否可用,是否发生变化等。

对于爬虫来说,稳定性很重要,但是很多不可控的因素会导致爬虫的成功率下降。通过采取良好的监控和预防措施,我们可以将事故发生时的风险降到最低。