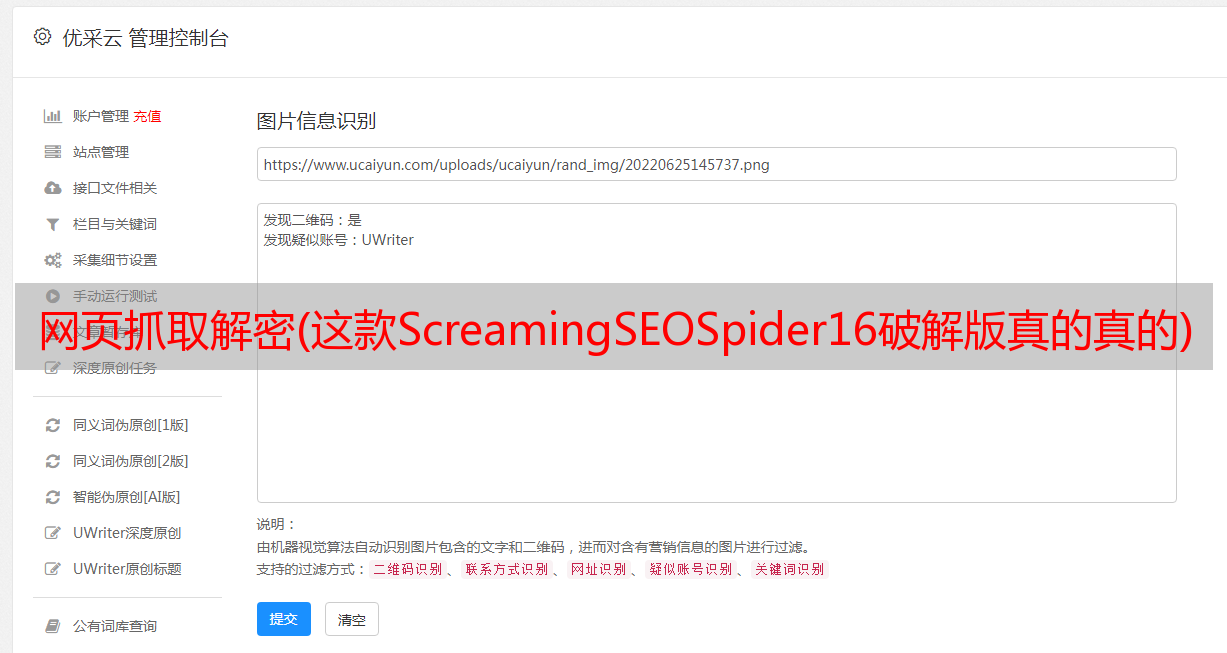

网页抓取解密(这款ScreamingSEOSpider16破解版真的真的)

优采云 发布时间: 2022-02-05 09:07网页抓取解密(这款ScreamingSEOSpider16破解版真的真的)

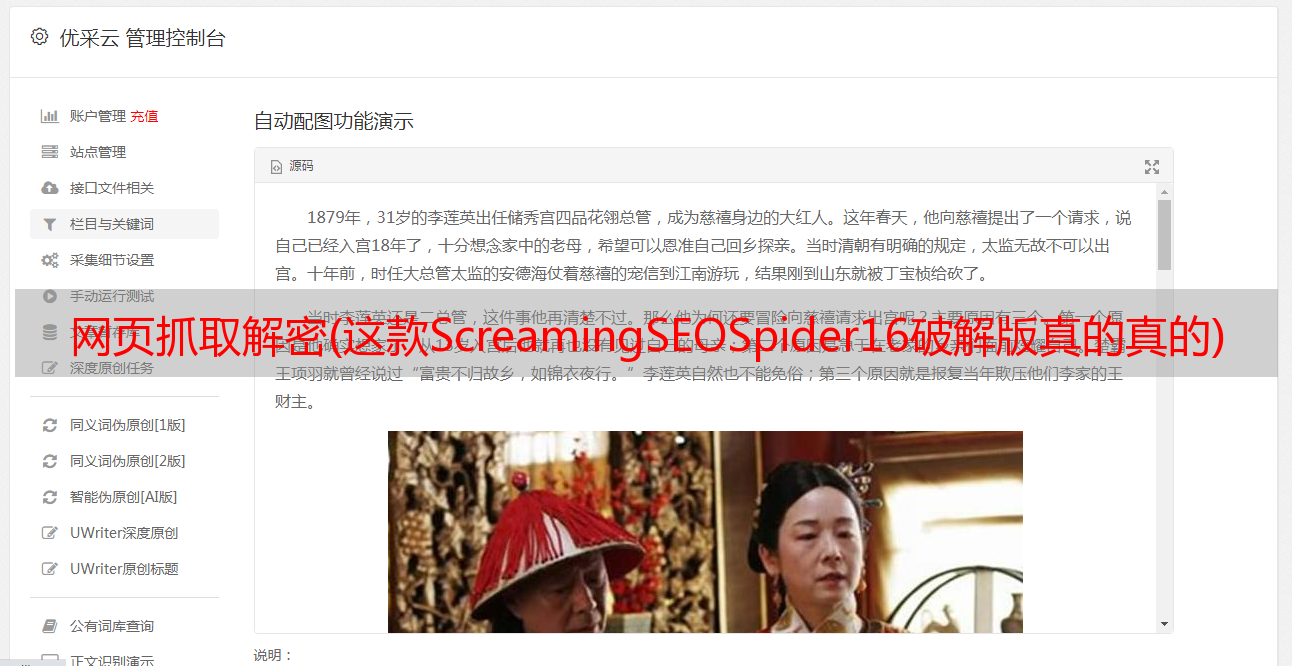

Screaming Frog SEO Spider 是一款功能强大的网络爬虫工具,专门用于爬取 Internet URL 并对其进行分析。通过这个软件,用户可以很方便的抓取可能存在或者出现在断连接或者服务器错误信息等的URL,也可以用来识别网站中临时或者永久的重新定义循环到链接也可以直接查URL、网页标题、内容重复的相关信息。抓取到这些信息后,软件会自动将获取到的详细信息反馈给开发者进行修复,非常方便好用。因此,这款软件非常适合从事网站网页行业的用户,通过它可以节省大量的时间和精力,高效地完成工作。所以,无论是大的网站还是自己制作的小网站,你都可以用它来分析,你可以很方便的得到你想分析的结果和你需要的各种数据。有了所需的数据和分析结果,seo可以对这些软件进行一些改进和选择,非常实用。同时,软件的界面非常直观,用户使用起来相当舒服,使用起来也没有那么复杂。总的来说,小编带来的Screaming Frog SEO Spider 16破解版功能确实全面,操作也比较简单。如果需要,可以在本站下载。利用。并且您可以轻松获得您想要分析的结果和您需要的各种数据。有了所需的数据和分析结果,seo可以对这些软件进行一些改进和选择,非常实用。同时,软件的界面非常直观,用户使用起来相当舒服,使用起来也没有那么复杂。总的来说,小编带来的Screaming Frog SEO Spider 16破解版功能确实全面,操作也比较简单。如果需要,可以在本站下载。利用。并且您可以轻松获得您想要分析的结果和您需要的各种数据。有了所需的数据和分析结果,seo可以对这些软件进行一些改进和选择,非常实用。同时,软件的界面非常直观,用户使用起来相当舒服,使用起来也没有那么复杂。总的来说,小编带来的Screaming Frog SEO Spider 16破解版功能确实全面,操作也比较简单。如果需要,可以在本站下载。利用。而且使用起来也没有那么复杂。总的来说,小编带来的Screaming Frog SEO Spider 16破解版功能确实全面,操作也比较简单。如果需要,可以在本站下载。利用。而且使用起来也没有那么复杂。总的来说,小编带来的Screaming Frog SEO Spider 16破解版功能确实全面,操作也比较简单。如果需要,可以在本站下载。利用。

破解教程1、在本站下载解压,得到ScreamingFrogSEOSpider-11.0.exe安装程序和Keygen.exe注册机

2、双击ScreamingFrogSEOSpider-11.0.exe运行,选择安装路径,点击next

3、正在安装,请稍等

4、安装完成,点击close关闭向导

5、运行软件和keygen注册机,将注册机中的注册信息相应复制到软件中

6、注册成功,重启软件

软件功能1、审计重定向

Screaming Frog SEO Spiderke 16 发现临时和永久重定向,识别重定向链和循环,或上传 URL 列表以供在站点迁移中查看。

2、生成 XML 站点地图

通过 URL 进行高级配置,包括上次修改、优先级和更改频率,快速创建 XML 站点地图和图像 XML 站点地图。

3、查看机器人和说明

查看被 robots.txt、meta-robots 或 X-Robots-Tag 指令(例如“noindex”或“nofollow”)以及规范和 rel="next" 和 rel="prev" 阻止的 URL。

4、发现重复

使用 md5 算法检查完全重复的 URL、部分重复的元素(例如页面标题、描述或标题)并查找内容低的页面。

5、抓取 JavaScript网站

使用集成的 ChromiumWRS 渲染网页,以抓取动态的、富含 JavaScript 的 网站 以及 Angular、React 和 Vue.js 等框架。

6、与谷歌分析集成

连接到 Google Analytics API 并获取用于抓取功能的用户数据,例如会话或跳出率以及着陆页的转化、目标、交易和收入。

7、使用 XPath 提取数据

使用 CSSPath、XPath 或正则表达式从网页的 HTML 中采集任何数据。这可能包括社交元标签、其他标题、价格、SKU 或更多。

8、分析页面标题和元数据

在抓取过程中分析页面标题和元描述,并识别 网站 中过长、过短、缺失或重复的内容。

9、可视化网站架构

使用交互式爬网和目录强制导向和树状图站点可视化评估内部链接和 URL 结构。

10、查找断开的链接

现在抓取 网站 并查找断开的链接 (404s) 和服务器错误。批量导出错误和源 URL 以修复或发送给开发人员。

软件功能 1、查找损坏的链接、错误和重定向

2、分析页面标题和元数据

3、查看元机器人和说明

4、审核 hreflang 属性

5、发现重复页面

6、生成 XML 站点地图

7、网站可视化

8、爬取限制(无限制)

9、调度

10、爬取配置

11、保存抓取并重新上传

12、自定义源代码搜索

13、自定义提取

14、谷歌分析集成

15、搜索控制台集成

16、链接指标集成

17、渲染 (JavaScript)

18、自定义robots.txt

19、AMP爬取和验证

20、结构化数据和验证

21、存储和查看原创和渲染的 HTML