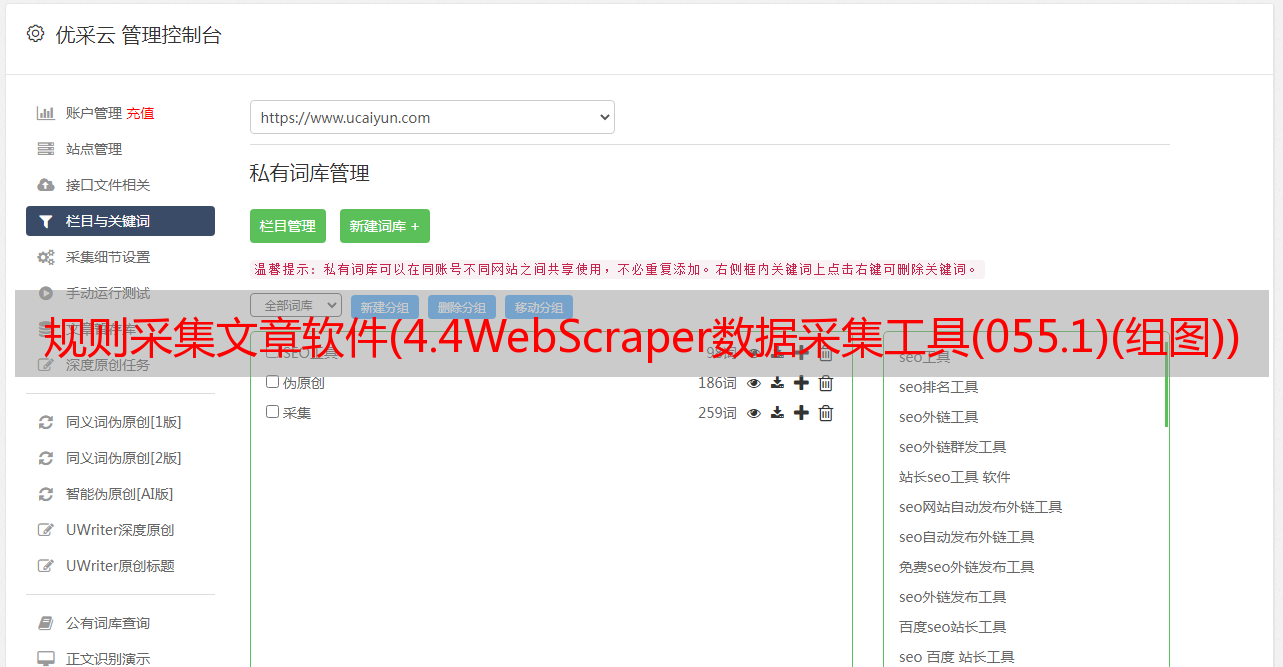

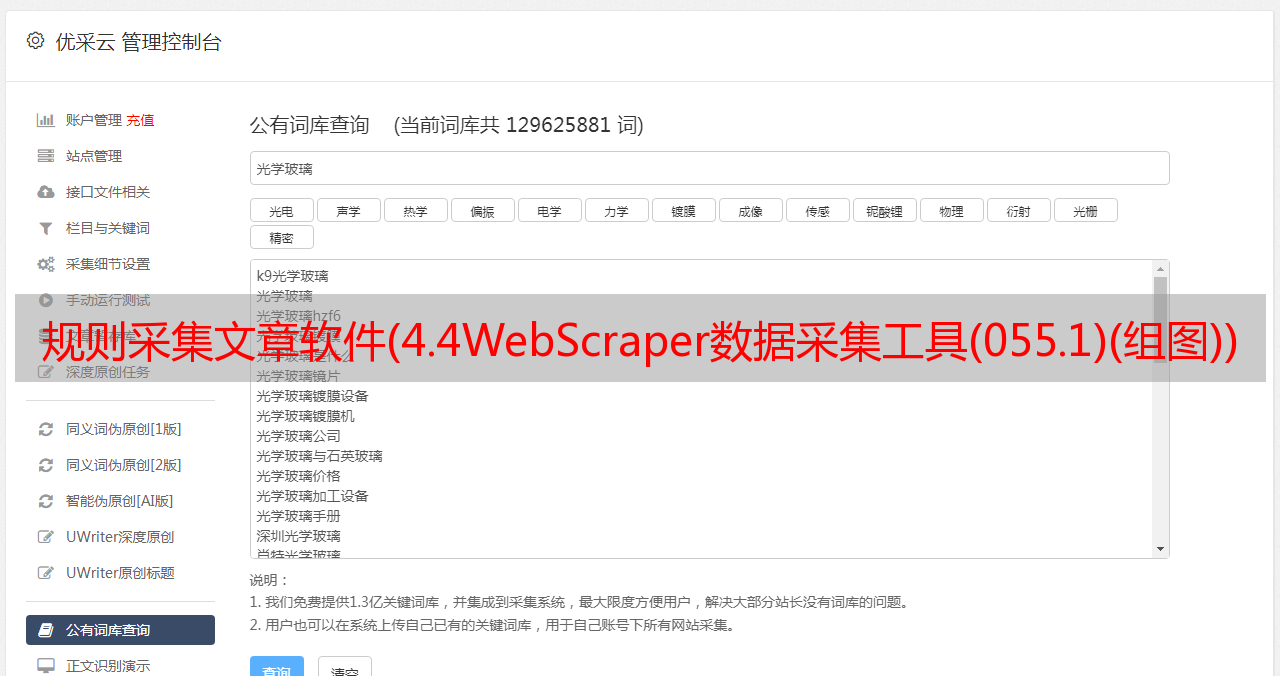

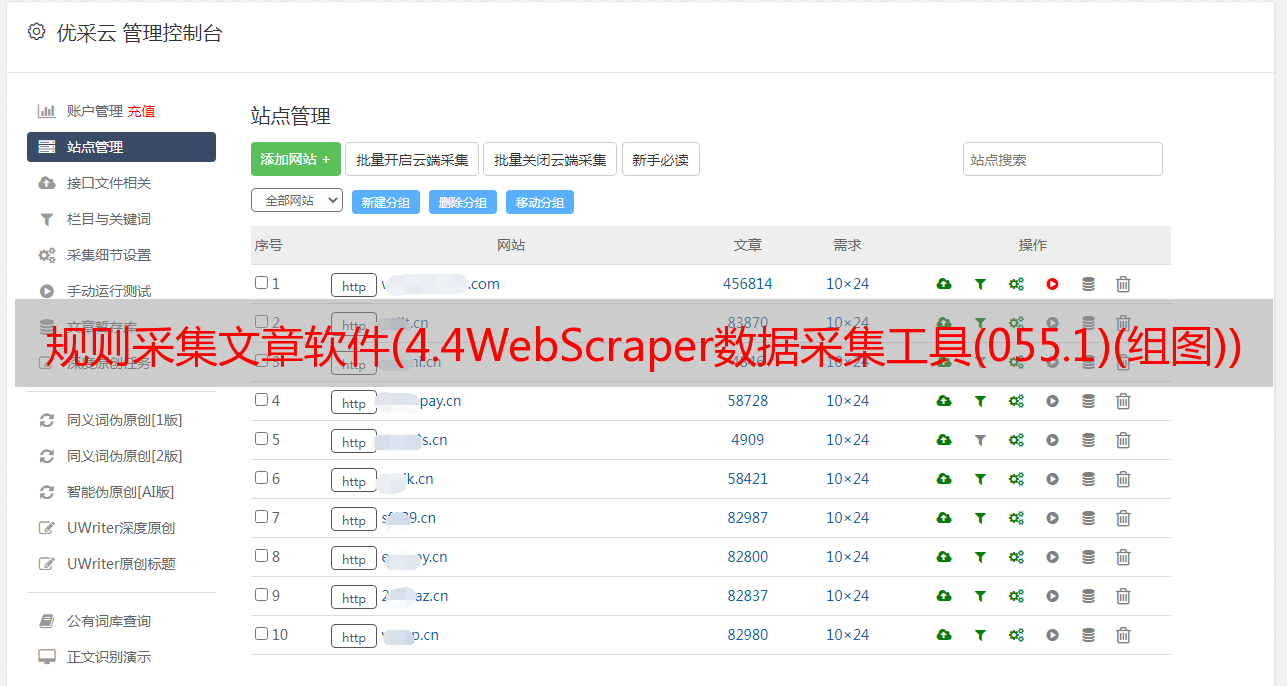

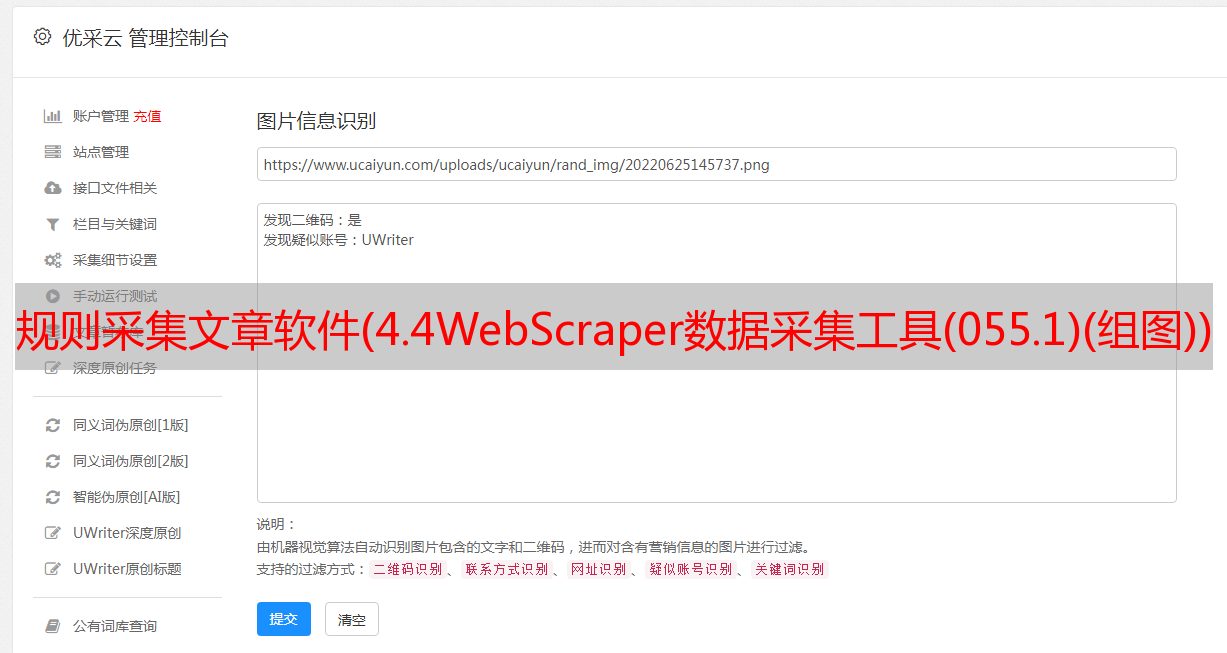

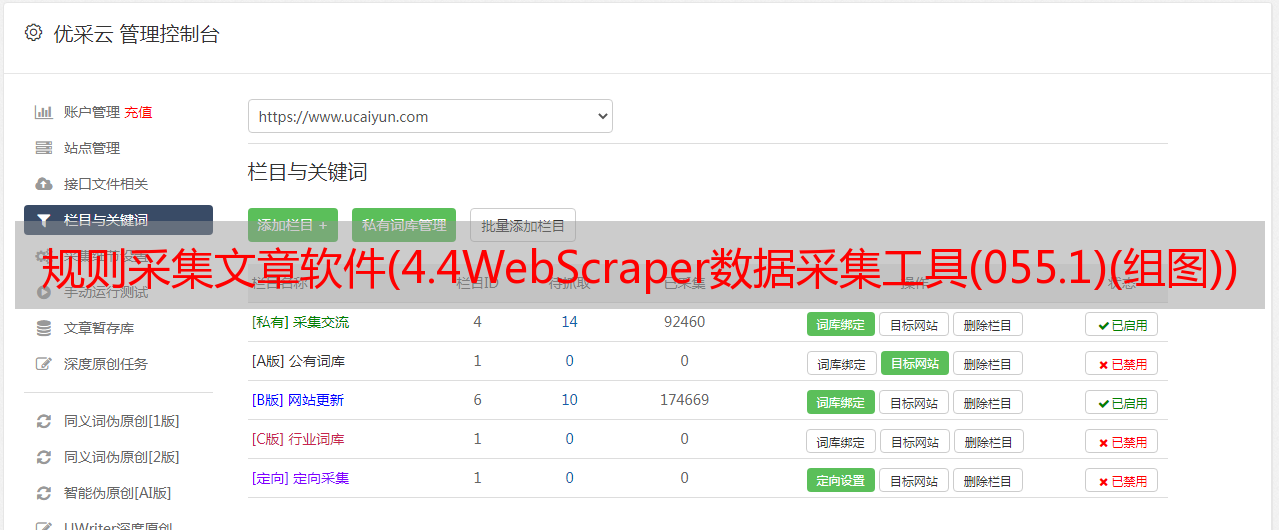

规则采集文章软件(4.4WebScraper数据采集工具(055.1)(组图))

优采云 发布时间: 2022-02-03 09:04规则采集文章软件(4.4WebScraper数据采集工具(055.1)(组图))

01实景解说

我是一名计算机视觉*敏*感*词*,我的研究方向是“物体检测”。在详细阅读相关文献之前,需要先了解一下这个领域的发展历史和各个时期的代表性文献。

02

手头的问题

如何找到这些相关文件?

03

明确的目标

我希望找到尽可能多的与当前研究领域相关的文献。

04

工具准备

4.1 个字段相关的 关键词 表:对象检测、对象检测等。

4.2 搜索引擎:谷歌、百度、必应等。

4.3 目标页面列表(数据来源):Google Scholar、Baidu Scholar、CNKI等。

4.4 网络爬虫数据采集工具。

05

5.1 确定使用哪个搜索引擎

谷歌浏览器(PS:需要合理使用),从“谷歌学术”中搜索我们想要的学术文献。如图1所示。

图1

5.2 确定用于搜索的关键词

我们希望目标页面收录词 Object Detection,总共有 484,000 个匹配项。如图2所示。

图 2

5.3 识别采集的数据项

我们的目的是什么?

我们想知道某个研究领域的发展历史,那么有3个参考指标(文献名、论文引用、相关文献)(当然还有其他的判别指标)。

因此,这次的数据有“论文标题”、“论文引用次数”、“相关文献”三项。如图 3 所示。

图 3

5.4 打开 Web Scraper 并创建一个新项目

点击右侧的三个点 -> 更多工具 -> 开发者工具。如图 4 所示。

图 4

单击工具栏上的三个点,将工具栏调整到浏览器底部。如图 5 所示。

图 5

单击网络抓取工具。如图 6 所示。

图 6

单击创建新站点地图以通过创建站点地图创建新项目。如图 7 所示。

图 7

填写 Sitemap 名称和 Start URL,填写完成后点击 Create Sitemap。如图 8 所示。

图 8

对于本文,我们在搜索结果的第 1 页上采集数据。如图 9 所示。

图 9

我们为采集的每个数据项命名:title(论文名称)、cited_num(论文引用次数)、related_articles(相关文献)。

5.5 设置数据抓取规则

单击您刚刚创建的项目。如图 10 所示。

图 10

进入项目后,点击添加新选择器。如图 11 所示。

图 11

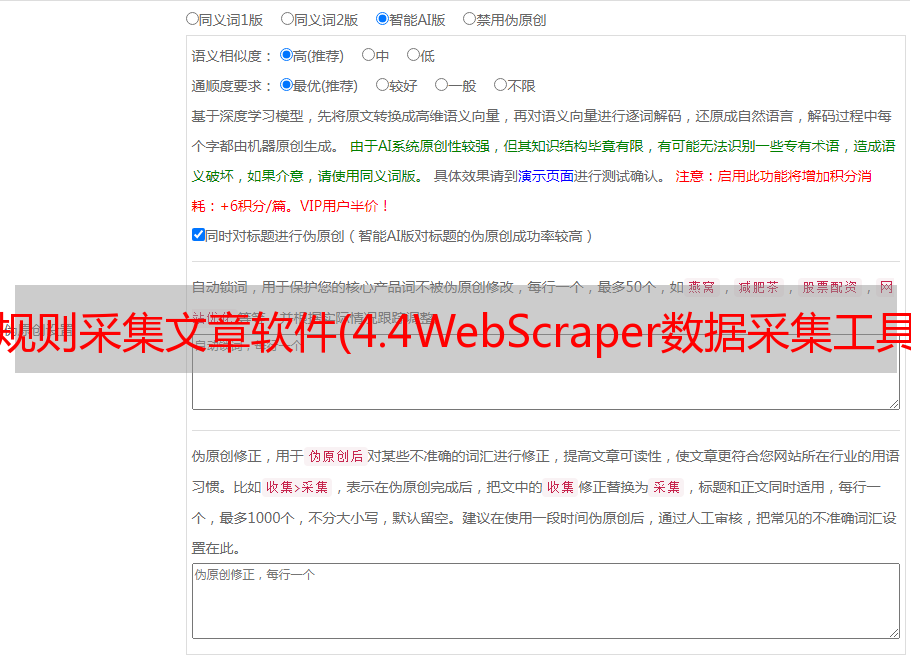

进入具体规则设置界面,需要填写id、Type、Selector、Parent Selecto、是否勾选Multiple这五项。设置好后点击保存选择器。如图 12 所示。

图 12

首先,让我们从数据项 采集 标题(文档名称)开始。单击您刚刚命名的 id。如图 13 所示。

图 13

输入“新节点”并再次单击添加新选择器。如图 14 所示。

图 14

与上述类似,分别设置以下规则。如图 15 所示。

图 15

单击元素预览以查看数据 采集 是否在正确的位置。如图 16 所示。

图 16

点击数据预览,目的是预览数据,确保采集的数据是我们想要的。如图 17 所示。

图 17

点击Data preview后我们看到的数据内容,也就是我们采集得到的最终数据是这样的。如图 18 所示。

图 18

接下来,我们采集第二个数据项--cited_num(文档被引用的次数)

单击“当前节点”中的添加新选择器以创建新的 采集 规则。如图 19 所示。

图 19

和上面类似,设置对应的采集规则。如图 20 所示。

图 20

单击元素预览。如图 21 所示。

图 21

单击数据预览。如图 22 所示。

图 22

验证我们的预览数据和网页数据是一一对应的。如图 23 所示。

图 23

最后,采集related_articles(与本文关联的文章)数据项设置了相应的规则。如图 24 所示。

图 24

单击元素预览。如图 25 所示。

图 25

单击数据预览。如图 26 所示。

图 26

5.6 开始采集数据

点击项目名称后,选择Scrape。如图 27 所示。

图 27

请求间隔和页面加载延迟是默认的,单击开始抓取。如图 28 所示。

图 28

单击开始抓取后,将重新打开一个网页。此时程序正在处理采集数据。采集结束后,窗口会自动关闭。

采集完成后会弹出提示,如图29。

图 29

5.7 导出数据

单击项目名称并选择将数据导出为 CSV。如图 30 所示。

图 30

然后会出现如下界面,点击立即下载!如图 31 所示。

图 31

点击下载后,可以使用“双击打开”或“在文件夹中显示”。如图 32 所示。

图 32

我们可以看到这个文件就是我们采集收到的数据。如图 33 所示。

图 33

导出文件的名称是 object_detection_project.csv,与我们构建项目时的名称相同。如图 34 所示。

图 34

5.8 简单的数据清洗

由于 Web Scraper 不会按照指定的顺序获取数据,因此顺序会有偏差。我们可以根据 web-scraper-order 对其进行排序。如图 35 所示。

图 35

至此,我们已经成功(一半)爬取了Google Scholar搜索结果首页上Object Detection关键词的相关信息。

但是在验证我们的采集数据和页面上的数据一致的时候,我们发现了一个问题:

问题 1

quoted_num 部分获取人的姓名,而不是相应的引用次数。如图 36 所示。

问题2

related_articles 部分还获取人名,而不是相应的文本和链接。如图 36 所示。

图 36

另外,我也想抓取文献的具体下载地址,然后直接访问地址就可以下载文献了。

以上“两题+抢文献下载地址”将在下一篇文章文章中进行分析。

文章具体操作请看下方视频:

如果文章对你帮助不大,就像是对我最大的支持,下期见,