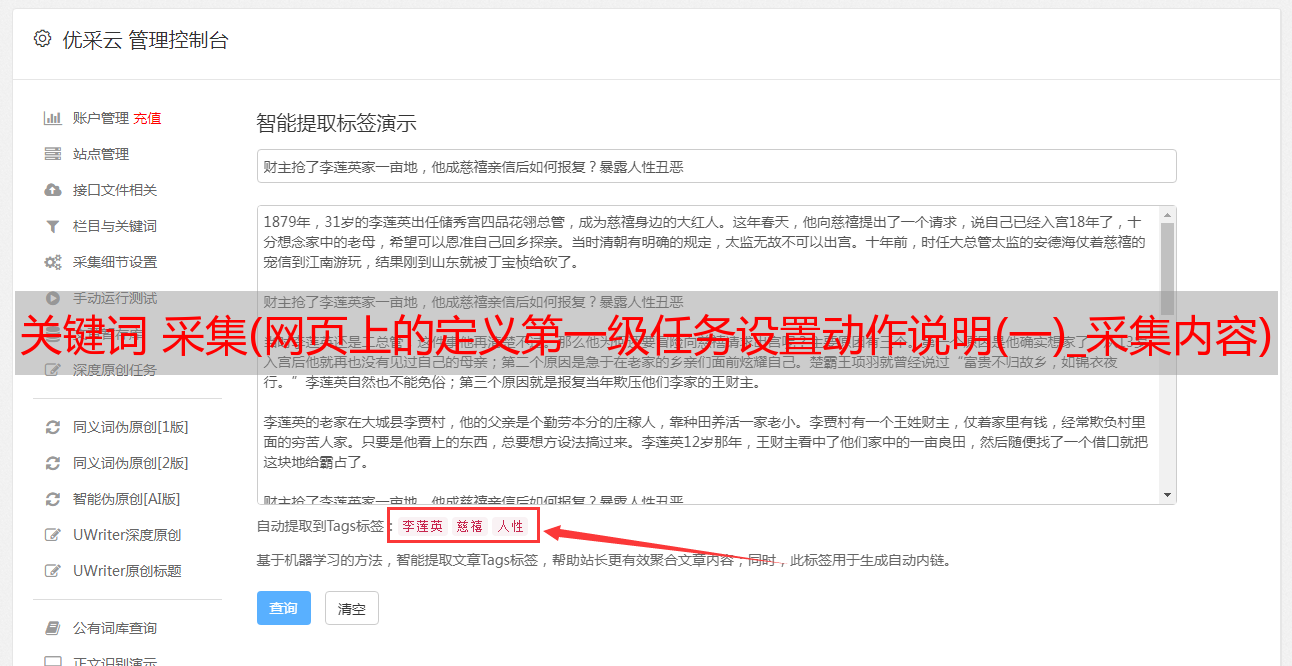

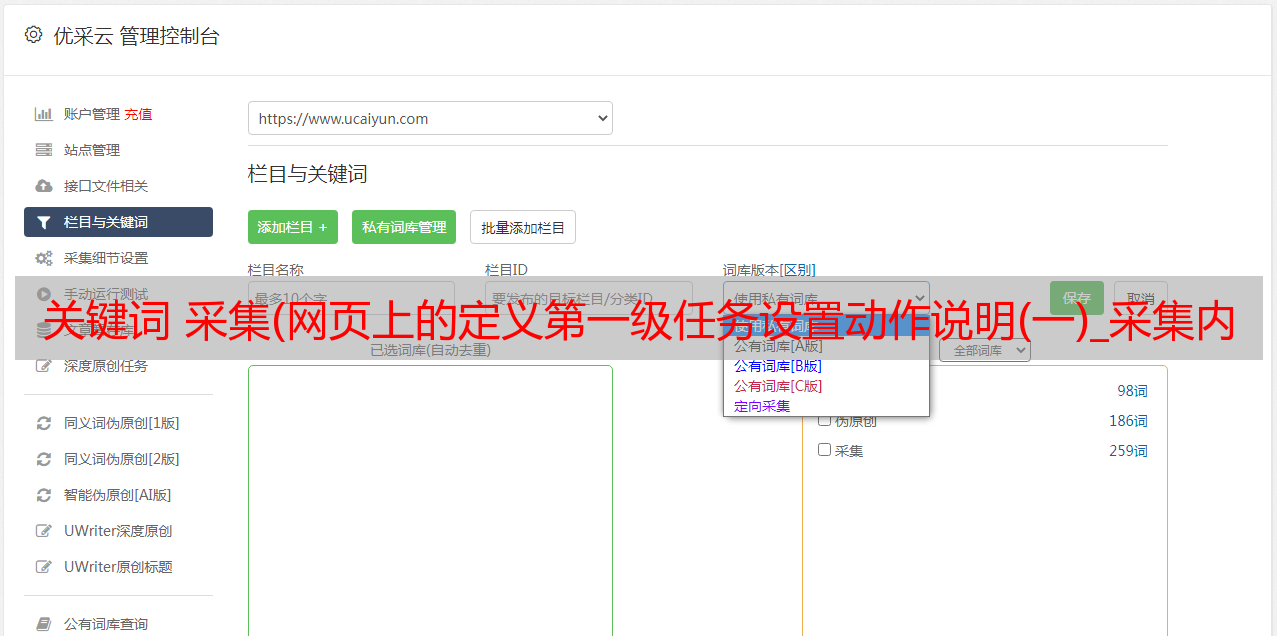

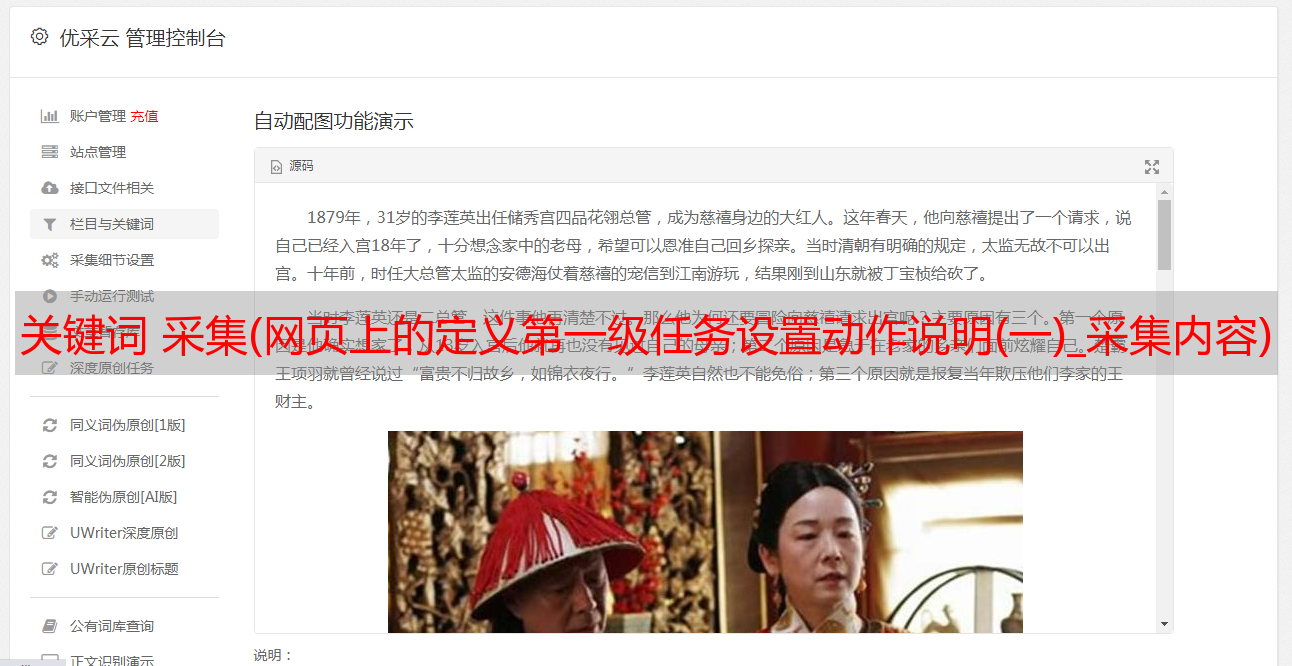

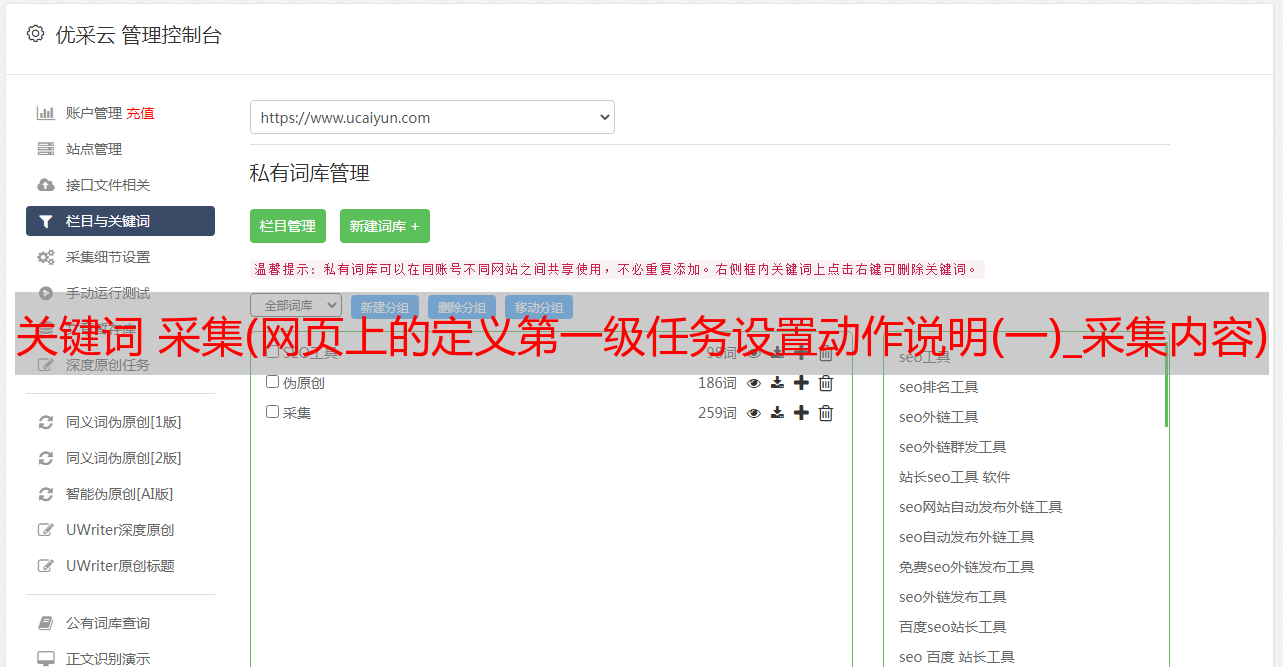

关键词 采集(网页上的定义第一级任务设置动作说明(一)_采集内容)

优采云 发布时间: 2022-02-01 05:03关键词 采集(网页上的定义第一级任务设置动作说明(一)_采集内容)

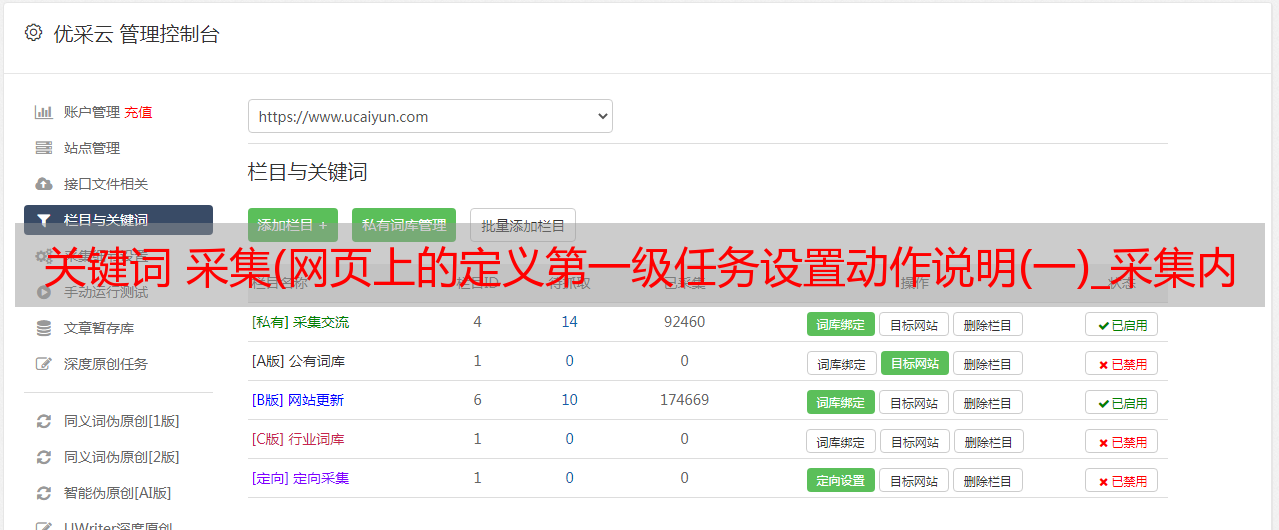

•采集内容:新闻链接、标题、摘要、时间

在下面输入详细的分步说明。

1. 定义一级任务:设置动作

1.1 打开网页

打开即搜客数据管理器,输入人民网搜索网址,加载网页。点击浏览器左上角的“+”,进入任务定义状态。

1.2 只需标记您想要的任何内容采集

一级任务虽然没有做实际的爬取工作,但是为了让爬虫正常工作,任务中至少需要有一个爬取内容,我们用网页上的“新闻”二字作为爬取内容。

双击“新闻”,输入字段名和表名,如下图。(直观标注的详细操作请参考《采集网页资料》)

1.3 设置动作

这里我们重点关注第一个“输入”动作,以及第二个动作“点击”。

1.3.1 第一个动作:输入动作

在工作台上点击“4”进入“设置动作”,点击“新建”按钮创建新动作。

动作后执行:目标任务为二级任务。本例中二级任务的名称为:Tutorial_People's Network Search_Crawl

动作类型:第一个动作是输入,所以选择输入

动作名称:为动作命名以供稍后检查,例如:输入

交互位置:这是操作的难点。找到动作位置的xpath,复制到这里。这样爬虫就知道去哪里了。如何找到动作的xpath?

我们现在要做的就是输入action,交互位置是搜索输入框,在网页上点击,下面的DOM窗口对应一个节点。

如下图操作,点击“Generate xpath”,因为这个节点有一个很特殊的id属性,所以选择partial id。

生成xpath后,点击xpath后面的搜索按钮,查看这个xpath对应多少个节点,本例为1/1,表示只对应一个节点,唯一,可以用来判断位置的动作。(如果是1/2,表示对应两个节点,当前节点是其中之一,但是在这个例子中,我们需要做输入动作的位置只有一个,也就是说这个xpath不适合,需要单独选择)。确定xpath后,将副本复制到action设置中。

输入单词:输入要搜索的关键词,例如输入:virus;;race,即首先是采集病毒的消息,然后是采集种族的消息。

延迟:考虑到加载网页需要时间,最好设置一点延迟时间。这个网页的加载速度比较快,可以设置为5s。

第一个动作,设置好输入动作后,工作台是这样的:

1.3.2 设置第二个动作:点击动作

点击新建设置第二个动作:点击动作

如何找到搜索点击动作的 xpath?

设置点击动作后,工作台如下所示:

这样,我们就完成了两个动作的设置,完成了第一级任务。

1.3.3 1级任务测试,保存

下图不是此示例的图像,但按钮的位置是相同的。

点击“保存”按钮保存完成的一级任务

暂时先保存一级任务,不要开始采集,因为我们还没有完成二级任务。

2. 退出一级任务定义状态

在定义二级任务之前,首先退出一级任务定义状态。

3. 定义二级任务

3.1 加载网页,进入定义任务状态

在网页输入关键词,搜索结果出来后,再次点击“+”进入任务定义模式。

输入任务名称,即填写一级任务的动作设置的动作后要执行的任务: Search_Crawl。

3.2 对网页执行 采集 任务

该页面上的每条新闻都是一个样本,在每个样本中,采集的信息是:标题、执行摘要、链接、时间。由于篇幅所限,我在此不再赘述。可以参考教程“采集List Data”。在本教程中,每条新闻都相当于一种商品。如果要翻页,请参考教程“翻页设置”。如果想更进一步,采集新闻详情,请看教程《深入采集》。

二级任务完成后,测试,保存。

4.开始采集

对于连续动作任务采集,只需要启动一级任务,爬虫会自动调用二级任务。

首先,进入任务管理页面。

在任务管理页面,选择一级任务,点击开始,线索数为1(因为本例一级任务只有1条线索),以完成采集为尽快,得到 采集 的结果,有限的翻页,只有 采集5 页。

点击上图中的OK后,爬虫弹出采集窗口,启动采集数据。可以观察到,在采集窗口中,搜索词自动加载,点击搜索,搜索结果页面自动加载,该页面的数据为采集。

采集完成后按提示点击导出excel数据,然后进入二级任务的数据管理下载数据。

所以流程是启动一级任务,去二级任务下载数据。

下图是来自采集的数据截图。搜索到的关键词默认记录在二级任务结果数据的actionvalue字段中。

Part 1 文章:《极搜客爬虫核心术语》 Part 2 文章:“自动点击京东商品规格价格数据采集”