搜狗搜索引擎优化(搜索引擎的蜘蛛,是不是爬得越多越好?当然是不是!)

优采云 发布时间: 2022-01-31 11:19搜狗搜索引擎优化(搜索引擎的蜘蛛,是不是爬得越多越好?当然是不是!)

一、搜索引擎蜘蛛,爬得越多越好?

当然不是!不管用什么搜索引擎爬虫来爬取你的网站页面,肯定会消耗你的网站资源,比如网站的连接数、网络带宽资源(空间流量)、服务器负载。

另外,搜索引擎的爬虫爬取你的页面数据后,不一定会收到数据。仅表示它“到过这里”并留下了痕迹。所以你的 网站 为它“服务和托管”。

对于一个内容丰富、URL结构合理、易于爬取的原创网站,简直就是各类爬虫的盛宴。在众多网站的流量构成中,爬虫带来的传入流量远超真实用户访问流量,甚至爬虫流量也比真实流量高出一个数量级。和提高网站的有效利用率一样,虽然设置了相当严格的反爬策略,但网站处理的动态请求数仍然是真实用户访问流量的两倍。可以肯定地说,当今互联网上至少 2/3 的流量是由爬虫带来的。因此,反爬虫是一个值得网站长期探索和解决的问题。

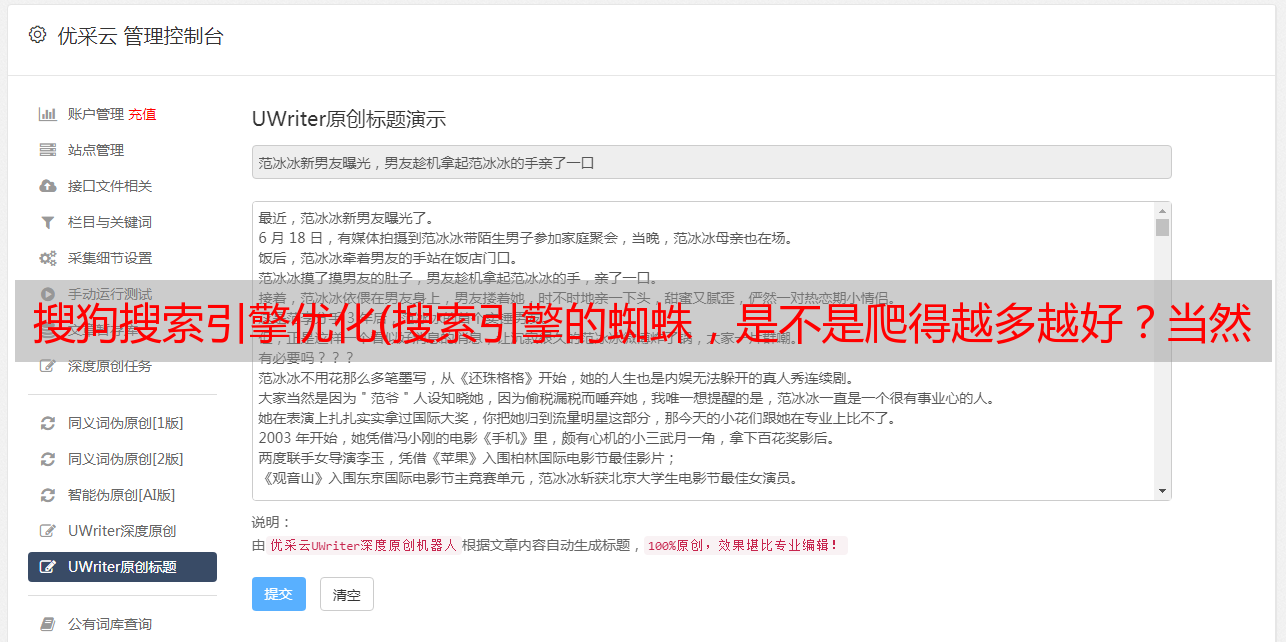

搜索引擎的主要工作流程(图)

搜索引擎爬虫对网站的负面影响。

1.网站带宽资源有限,爬虫太多导致普通用户访问速度慢。

比如原虚拟主机的连接数是有限的,带宽资源也是有限的。在这种情况下,搜索引擎爬虫的影响更为明显。

2.搜索引擎爬虫过于频繁,爬取扫描了很多无效页面。甚至抓取页面,抓到服务器报502、500、504等内部服务器错误,蜘蛛爬虫还在努力爬。

无论是实际生产监控还是网友反馈,一些搜索引擎爬虫可以用几个词来形容“坏蜘蛛”和“邪恶爬虫”。很多关于搜索引擎的 文章 讨论,它们已经被列在排行榜上。有兴趣可以详细了解一下。

百度蜘蛛工作图

3.与网站主题无关的搜索引擎爬虫消耗资源。

例如,典型的搜索引擎示例“EtaoSpider 是 Etao 的爬虫”。被各大电商购物网站屏蔽。拒绝一淘网抓取其产品信息和用户评论。封禁的原因首先应该是它们之间没有合作互利的关系,而EtaoSpider爬虫是最疯狂的蜘蛛之一。统计数据显示,EtaoSpider的每日爬取量是“百度蜘蛛:Baiduspider”、“360蜘蛛:360Spider”、“SOSO蜘蛛:Sosospider”等主流蜘蛛的数倍,而且远不止这些。关键是被爬取的EtaoSpider只会消耗你的网站资源,不会给你带来流量,或者其他对你有用的东西。

4.一些搜索引擎开发程序员编写爬虫程序来测试爬取。你懂...

5.robots.txt 文件不是万能的!

想必有很多人认为在robots.txt中屏蔽搜索引擎爬虫就够了,或者让一些特定的搜索引擎爬虫达到你期望的效果。

是的,正规搜索引擎会遵守规则,不会及时生效。在实践中,有些蜘蛛往往不是这样,先扫描并爬取你的页面,忽略你的 robots.txt。也有可能被捕获后不一定保留;或者只是统计信息,采集互联网行业趋势分析统计。

6.还有一个不是蜘蛛,但是有蜘蛛的特性。如采集软件、采集程序、网上扫描邮件地址的工具、各种SEO分析统计工具、各种奇怪的网站漏洞扫描工具等,只有你 意想不到的工具,没有它不能做什么......

二、有效指导搜索引擎的相应措施和解决方案:

1.根据空间流量的实际情况,预留几个常用的,用来挡住其他蜘蛛,节省流量。临时空间流量还是够用的,先保证普通浏览器优先。

2.从服务器防火墙iptable直接屏蔽蜘蛛IP段和详细IP。这是最直接有效的屏蔽方法。

3.WWW 服务器级别受限。例如,Nginx、Squid、Lighttpd 直接通过“http_user_agent”拦截搜索引擎爬虫。

4.最后一个 robots.txt 文件是有限的。搜索引擎的国际规则还是要遵守规则,让robots.txt明确公开发布。

后续文章会详细介绍这个方法,包括如果发现蜘蛛,从网站的日志中统计蜘蛛,发现未知蜘蛛。对于不同的蜘蛛,如何拦截蜘蛛,禁止爬虫,效率更高,速度更快。并举例介绍。

象形蜘蛛、履带式机器人(图)

三、采集各大搜索引擎蜘蛛最新最准确的名字

网上资料来源:最新最准确

常见的爬虫名字是根据网上空间的访问日志整理出来的,不是最全的,而是最新最准确的爬虫信息。以下搜索引擎蜘蛛名称是从在线空间日志中提取的。

各种搜索引擎的蜘蛛爬虫会不断的访问和爬取我们网站的内容,也会消耗一定的网站流量。有时有必要阻止某些蜘蛛访问我们的网站。

其实有效和常用的搜索引擎只有几个,只要在robots.txt文件中允许放出常用的搜索引擎蜘蛛,其他爬虫都用通配符(*)来屏蔽一些蜘蛛。

情况:

从网上得到的搜索引擎蜘蛛的名字几乎都是从原文复制粘贴再转载的文章,而且很多资料已经过时了,而且这些旧资料根本没有修改更新(实际使用用处不大。),而且对于蜘蛛名和大小写众说纷纭,根本不可能得到准确的信息。

各大搜索引擎蜘蛛最新最准确的名称:

1、百度蜘蛛:百度蜘蛛

网上百度蜘蛛的名字有BaiduSpider、baiduspider等,我们洗洗睡吧,就是老黄历了。百度蜘蛛的最新名称是百度蜘蛛。在日志中,我还找到了Baiduspider-image,百度下的蜘蛛。查了资料(其实就是看名字……),是抓图的蜘蛛。

常见的百度同类型蜘蛛有:Baiduspider-mobile(抓wap)、Baiduspider-image(抓图)、Baiduspider-video(抓视频)、Baiduspider-news(抓新闻)。

注:以上百度蜘蛛目前为Baiduspider和Baiduspider-image。

2、谷歌蜘蛛:谷歌机器人

这个争议较小,但据说也是 GoogleBot 的。Google 蜘蛛的最新名称是“compatible; Googlebot/2.1;”。还找到了Googlebot-Mobile,看名字就是爬wap内容。

3、360蜘蛛:360Spider,它是一只非常“勤奋”的蜘蛛。

4、SOSO蜘蛛:Sosospider,它也可以被授予“勤奋”的蜘蛛。

5、雅虎蜘蛛:“雅虎!啜饮中国”或雅虎!

这个名字有“Slurp”和一个空格,名字有一个空格。机器人可以使用“Slurp”或“Yahoo”来描述它。我不知道它是否有效。

6、有道蜘蛛:有道机器人,有道机器人(都是名字,中文拼音少了一个U字母,读音很不一样,会不会少一些?)

7、搜狗蜘蛛:搜狗新闻蜘蛛

搜狗蜘蛛还包括:搜狗网络蜘蛛、搜狗inst蜘蛛、搜狗蜘蛛2、搜狗博客、搜狗新闻蜘蛛、搜狗猎户蜘蛛、

(参考网站的一些robots文件,搜狗蜘蛛的名字搜狗可以总结出来的,我无法验证是否有效)

看看百度最权威的robots.txt,搜狗蜘蛛的字节数很多,占用的面积也很大。

“搜狗网络蜘蛛;搜狗inst蜘蛛;搜狗蜘蛛2;搜狗博客;搜狗新闻蜘蛛;搜狗猎户蜘蛛”目前有6个带空格的名字。

网上常见“搜狗网蜘蛛/4.0”;"搜狗新闻蜘蛛/4.0"; “搜狗inst蜘蛛/4.0”可获“占之王”奖。

8、MSN蜘蛛:msnbot、msnbot-media(只见msnbot-media疯狂爬行……)

9、必应蜘蛛:bingbot

在线(兼容;bingbot/2.0;)

10、搜索蜘蛛:YisouSpider

11、Alexa 蜘蛛:ia_archiver

12、EasouSpider:EasouSpider

13、即时蜘蛛:JikeSpider

14、网络蜘蛛:EtaoSpider

“Mozilla/5.0(兼容;EtaoSpider/1.0;省略/EtaoSpider)”

根据上面的爬虫,选择几个常用的允许爬取,其余的都可以被机器人拦截。如果你暂时有足够的空间流量,在流量紧张的时候,保留一些常用的,并阻止其他蜘蛛以节省流量。至于那些蜘蛛爬到网站的有用价值,网站的管理人员是很有眼光的。

此外,还发现了 YandexBot、AhrefsBot 和 ezooms.bot 等蜘蛛。据说这些蜘蛛是外国的,对中文网站用处不大。最好是节省资源。

概括:

这一次,我分析了搜索引擎爬虫的危害以及蜘蛛对网站的负面影响;如何有效引导搜索引擎的相应措施和解决方案;采集源码线上各大搜索引擎蜘蛛最新最准确的名字。

网站搭建完成,当然希望网页能被搜索引擎搜索到的越多越好收录,不过有时候我们也遇到网站不需要被搜索引擎搜索到收录案例。

比如要启用一个新域名作为镜像网站,主要用于PPC推广。这时候就需要想办法防止搜索引擎蜘蛛爬取我们镜像网站的所有网页并对其进行索引。因为如果镜像网站也被搜索引擎收录使用,很可能会影响官网在搜索引擎中的权重,这绝对是我们不希望看到的结果。

下面列出了几种阻止主流搜索引擎爬虫(蜘蛛)爬取/索引/收录网页的思路。注:全站屏蔽,尽可能屏蔽所有主流搜索引擎的爬虫(蜘蛛)。

1、通过 robots.txt 文件阻止

可以说 robots.txt 文件是最重要的渠道(与搜索引擎建立直接对话)。通过分析自己博客的服务器日志文件,我给出以下建议(同时欢迎网友补充):

用户代理:百度蜘蛛

不允许: /

用户代理:Googlebot

不允许: /

用户代理:Googlebot-Mobile

不允许: /

用户代理:Googlebot-Image

不允许:/

用户代理:Mediapartners-Google

不允许: /

用户代理:Adsbot-Google

不允许: /

用户代理:Feedfetcher-Google

不允许: /

用户代理:Yahoo!啜饮

不允许: /

用户代理:Yahoo!啜饮中国

不允许: /

用户代理:Yahoo!-AdCrawler

不允许: /

用户代理:有道机器人

不允许: /

用户代理:Sosospider

不允许: /

用户代理:搜狗蜘蛛

不允许: /

用户代理:搜狗网络蜘蛛

不允许: /

用户代理:MSNBot

不允许: /

用户代理:ia_archiver

不允许: /

用户代理:番茄机器人

不允许: /

用户代理: *

不允许: /

2、按元标记阻止

在所有网页头文件中,添加以下语句:

3、通过服务器设置(例如:Linux/nginx)配置文件

直接过滤蜘蛛/机器人的IP段。

注意:一二招只对“君子”有效,防止“小人”使用三招(“君子”、“小人”指遵守和不遵守robots.txt的人)协议分别为spider/robots),所以网站上线后,需要不断的跟踪分析日志,过滤掉这些badbots的IP,然后进行屏蔽。

这是一个badbot ips的数据库:

4、通过搜索引擎提供的站长工具删除网页快照

例如,有时百度不严格遵守 robots.txt 协议,您可以通过百度提供的“网页投诉”门户删除网页快照。百度网络投诉中心: