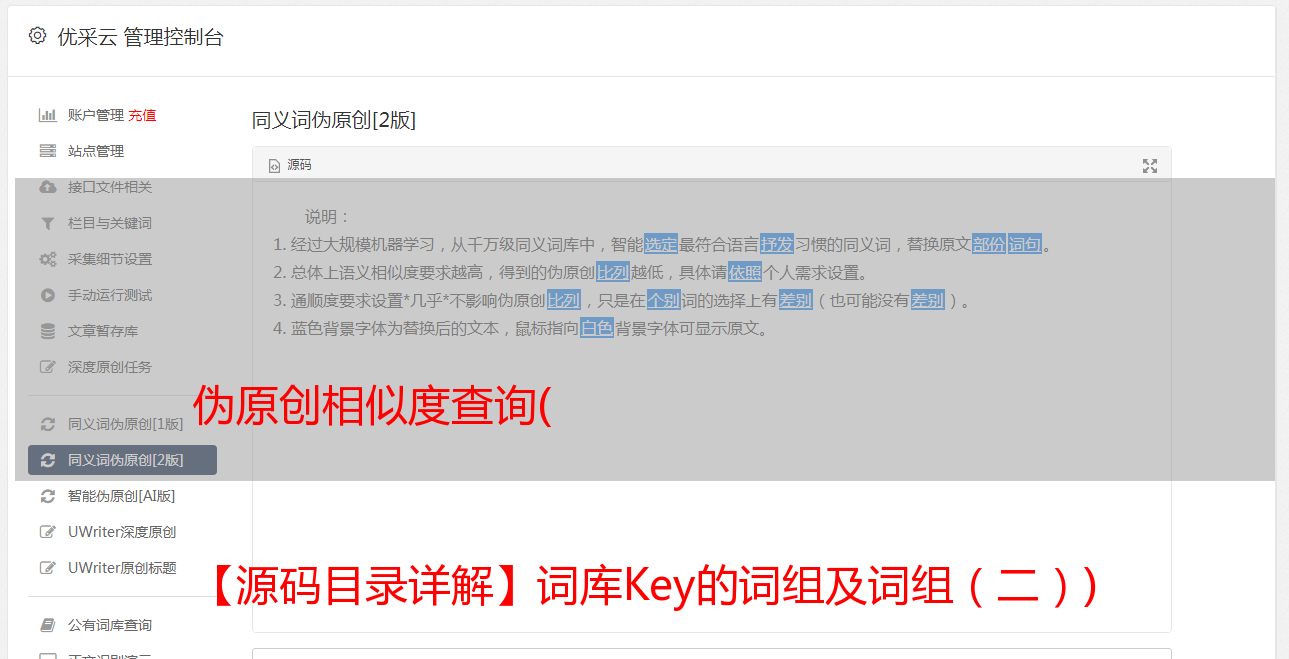

伪原创相似度查询( 【源码目录详解】词库Key的词组及词组(二))

优采云 发布时间: 2022-01-30 02:15伪原创相似度查询(

【源码目录详解】词库Key的词组及词组(二))

详细源码目录

language-ai

|- src/main

| |- java java源码所在目录

| |- com.chenxin

| |- auth 百度AI授权认证模块

| |- base 基础公共抽象模块

| |- config 项目所有自定义配置模块

| |- controller 这个不用多说

| |- exception 全局异常与自定义一次模块

| |- model 项目所有使用的数据模型, dto,vo,bo等

| |- service 业务模块

| |- util 工具模块

| |- auth 授权认证模块

| |- consts 常量类

| |- http http相关

| |- nlp NLP同义词库加载工具

| |- system 系统相关

| |- CommonEnum.java 统一信息处理枚举类

|

| |- AiApplication.java 主启动类

|

|- src/test/java

|- com.chenxin 相关测试代码, 经验证, 若idea版本太低将会导致该单元测试无法使用

其他自行查看源码, 不一一概述

关于词库 扩展词库

如果你想更准确地计算和替换,你需要一个非常准确和庞大的词库。你可以自己慢慢填写这个词库。只需将词库添加到文件resource/res/word.txt中,按照格式添加即可。就是这样,然后调用初始化redis接口。初始化redis接口 /ai/command/initRedis

论词库中的单词重复问题

这个不用你担心,作者在这方面做了很多优化。具有相同键值 Key 的词组会全部存储在 redis 中,以 Key0 和 Key1 的形式存储。查询时会找到所有具有相同key的词组,并进行去重,然后再进行其他操作计算词义。相似度等。对于同一个Key,为了提高查询效率,默认取同一个Key的前20组!

技术地图

本项目整合了多个优秀的NLP项目,一起使用。分词使用百度AI自然语言处理技术中的词义分析技术,词义相似度使用HanLP项目计算同义词距离!

自然语言处理技术(百度AI提供技术支持)自然语言处理(hanLP提供技术支持)

HanLP是由一系列模型和算法组成的NLP工具包,旨在普及自然语言处理在生产环境中的应用。

词库 技术架构 后端 前端

本项目的页面只是作为测试用,以后会做一个完整的产品网站。

关于作者的问题和优化

对人工智能、分布式微服务、Web应用、大数据等领域充满热情。工作室:1024 Code Studio,有需要可以联系作者,也可以交流。邮件:

其他

之所以会用到多个NLP项目,是因为整个项目本来就是打算用百度AI来完成的。但由于百度的自然语言处理API对普通用户的调用次数有限制,因此会收取超额费用。因此,相对大量数据的处理将由 HanLP 项目处理。数据量少的分词交给百度AI处理。