搜索引擎优化原理( 搜索引擎工作过程非常复杂接下来的几节我们简单介绍(组图))

优采云 发布时间: 2022-01-26 11:17搜索引擎优化原理(

搜索引擎工作过程非常复杂接下来的几节我们简单介绍(组图))

搜索引擎的工作原理 搜索引擎的工作过程非常复杂。在接下来的几节中,我们将简要介绍搜索引擎是如何实现网页排名的。这里介绍的内容只是相对于真正的搜索引擎技术的一些小插曲,但是对于SEO人员来说已经足够搜索引擎的工作过程大致可以分为三个阶段: 1.爬取和爬取。搜索引擎蜘蛛通过以下链接访问网页以获取页面 HTML 代码并将其存储在数据库中。处理准备好排名程序调用 3 排名用户输入 关键词 排名程序调用索引数据库数据计算相关性然后按照一定格式公文格式标准格式个人贷款标准格式个人贷款格式生成搜索结果页面爬取爬取爬取是搜索引擎工作的第一步完成数据采集任务 1.蜘蛛搜索引擎用来爬取和访问页面的程序叫做spider spider,也叫robot bot,搜索引擎蜘蛛类似于普通用户访问网站页面时使用的浏览器蜘蛛程序,服务器端在发出页面访问请求后返回 HTML。代码蜘蛛程序将接收到的代码存储在原创页面的数据库中。为了提高爬行和爬行速度,多个蜘蛛用于同时分发爬虫。当蜘蛛访问任何一个网站时,会先访问网站根目录下的robotstxt文件,如果robotstxt文件禁止搜索引擎抓取某些文件或目录,蜘蛛会遵守协议. 新版离婚协议劳务协议合同。URL 与浏览器相同。搜索引擎蜘蛛也有标识自己的代理名称。站长可以在日志文件中查看搜索引擎的具体代理名称,以识别搜索引擎蜘蛛。下面列出了常见的搜索引擎蜘蛛名称。Baiduspiderhttpwwwbaiducomsearchspiderhtm百度蜘蛛Mozilla50compatibleYahooSlurpChinahttpmiscyahoocomcnhelphtml雅虎中国蜘蛛Mozilla50compatibleYahooSlurp30httphelpyahoocomhelpusysearchslurpEnglish雅虎蜘蛛Mozilla50compatibleGooglebot21httpwwwgooglecombothtmlGoogle蜘蛛msnbot11httpsearchmsncommsnbothtmMicrosoft兵SpiderSogouwebrobothttpwwwsogoucomdocshelpwebmastershtm07Sogou蜘蛛跟踪联系,以抓取尽可能多的网页尽可能在网络上,搜索引擎蜘蛛会跟着从一个网页检索网页上的链接进入下一页,就像蜘蛛在蜘蛛网上爬行一样。这就是名称搜索引擎蜘蛛的由来。链接网站和页面理论上是由蜘蛛组成的,从任何页面开始,跟随链接可以爬到互联网上的所有页面,当然,由于网站 并且页面链接结构非常复杂。蜘蛛需要采用一定的爬取策略来遍历互联网上的所有页面。最简单的爬行遍历策略分为两种:一种是深度优先,另一种是广度优先。所谓深度,首先是指蜘蛛沿着找到的链接向前爬行,直到前面没有其他链接,然后返回第一页,跟随另一个链接,向前爬行。如图 2-20 所示,蜘蛛跟随从页面 A 到页面 A1A2A3A4 到页面 A4 的链接。返回页面 A,没有其他链接可循。按照页面上的另一个链接并爬网到 B1B2B3B4。在深度优先策略中,蜘蛛爬行直到它不能再向前移动,然后返回爬行另一条线。广度优先意味着蜘蛛在创建链接时会发现更多,它不会一路跟随一个链接,而是爬取页面上的所有一级链接,然后沿着二级页面上找到的链接爬到三级页面。如图 2-21 所示,爬虫从 A 页面到 A1B1C1 页面的链接,直到 A 页面上的所有链接都被爬完,然后从 A1 页面找到的下一层链接爬到 A2A3A4 页面 图 2-20 深度-first traversal strategy 图2-21 广度优先遍历 从理论上讲,无论是深度优先还是广度优先,只要给蜘蛛足够的时间,它就可以爬取整个互联网。在实践中,蜘蛛的带宽资源时间不是无限的,不可能爬取所有页面。其实最大的搜索引擎也只是爬取和收录 互联网的一小部分深度优先和广度优先通常是混用的,这样尽量网站广度优先可以兼顾网站内页深度优先3可以看出,虽然蜘蛛理论上可以爬取,爬取所有页面,但在实践中却不能也不会这样做。如果 SEO 想要更多的页面是 收录,他们必须想办法吸引蜘蛛爬取,因为不能爬取所有页面,所有蜘蛛要做的就是尝试爬取重要的页面。哪些页面被认为更重要?有几个因素会影响 1网站 和高品质的页面权重和旧的 网站 被认为是权重比较高 网站 上的页面将被爬取更高的深度,所以会有更多的内页将被 收录2 页更新。蜘蛛每次爬取时都会存储页面数据。如果第二次抓取第一个 收录 的页面

更频繁地访问这类页面 页面上出*敏*感*词*流量表编制法七种顺序求和的方法将分为两个词:减肥法和方法。中文分词基本上有两种方法。一种是基于字典匹配。另一种方法是基于统计和字典匹配,即将一段待分析的汉字与预制字典中的条目进行匹配,从待分析的字符串中扫描字典中已有的条目,匹配成功。换句话说,一个词是根据扫描方向进行分割的。基于字典的匹配方法可以分为正向匹配和反向匹配。根据匹配长度优先级的不同,可以分为最大匹配和最小匹配。扫描方向和长度优先级可以混合使用。生成前向最大匹配和反向最大匹配等不同方法。字典匹配方法计算简单,其准确性在很大程度上取决于字典的完整性和更新。基于统计的分词方法是指分析大量的文本样本,计算出单词和单词相邻出现的统计概率,多个单词相邻出现的次数越多,形成一个单词的可能性就越大。基于统计的方法的优点是对新出现的词反应更快,也有利于消歧。基于字典匹配和基于统计的分词方法各有优缺点,实际使用中的分词系统是两种方法的结合,快速高效,可以识别新词和新词消除歧义。中文分词的准确性往往会影响搜索引擎排名的相关性。例如,

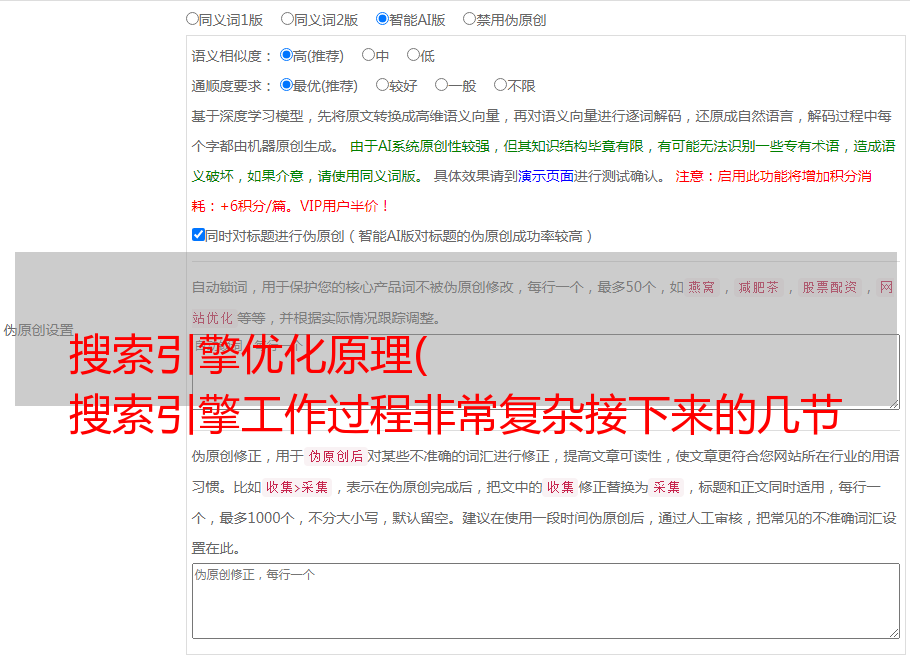

如果页面是关于和服的内容,可以用粗体标出和服两个字。如果页面是关于化妆和服装的,你可以将这两个词标记为粗体,这样搜索引擎在分析页面时就会知道应该用粗体标记什么。是一个词 3. 去停用词,无论是英文还是中文,都会有一些出现频率很高但对内容没有影响的词,如副词如dide,感叹词如ah ah,副词如yi,或介词 这些词被称为停用词,因为它们对页面的主要含义几乎没有影响。英语中常见的停用词是 theaantoof,其他搜索引擎会在索引页面之前删除这些停用词,使索引数据更加突出,减少不必要的计算量4.消除噪音大多数页面上仍有部分内容对页面主题没有贡献,如版权声明、文本导航栏、广告等以常见的博客导航为例,几乎每个博客页面都会出现文章分类历史档案等导航内容,但页面本身与分类历史中的文字无关,返回博客毫无意义post 只是因为这些词在用户搜索历史类别时出现在页面上,这些 关键词 是完全不相关的,所以这些块它们都属于噪音,只能对页面的主题起到分散作用。搜索引擎需要识别和消除这些噪音。内容去噪的基本方法是根据 HTML 标签来划分页面。网站 上的大量重复块通常属于噪声。页面去噪后,剩下的就是页面的主要内容 5. 去重 搜索引擎也需要对页面进行去重。相同的 文章 经常在不同的 网站 和同一 网站 的不同 URL 上重复。搜索引擎不喜欢这种重复。用户在搜索*敏*感*词*内容时,如果在前两页看到来自不同网站的同一篇文章文章,用户体验太差了,虽然两个内容相关的搜索引擎都希望只返回同文章@文章之一,所以需要在索引前识别和删除重复的内容。这个过程称为去重和去重。基本方法是计算页面特征关键词的指纹,也就是说,从页面的主要内容中选择最有代表性的部分关键词往往是最频繁出现的关键词,然后计算这些关键词@关键词的数字指纹,这里选择关键词是分词后停止词降噪。实验表明,通常选择10个特征关键词,可以达到比较高的计算准确率,然后再选择更多的词,对去重准确率的提升贡献不大。典型的指纹计算方法如MD5算法信息摘要算法第五版的特点是输入特征的任何微小变化< @关键词 会导致搜索引擎的指纹计算有很大差距。了解了搜索引擎的去重算法后,SEO人员应该知道,只要加上所谓的伪原创就得改变段落的顺序,逃不过搜索引擎的去重算法,因为这样的操作是不可能改变文章关键词的特性,而且搜索引擎的去重算法很可能不仅在页面层面,而且在段落层面,混合不同的文章段落顺序交叉交换不会防止转载和抄袭变成原创6。前向索引也可以称为索引。经过文本提取、分词、去噪和去重后,搜索引擎获得能够反映页面主要内容的独特的基于词的内容。然后搜索引擎索引程序可以提取关键词根据分词程序划分的单词将页面转换成由关键词组成的集合,并记录每个关键词的出现频率在页面上。格式如出现在title标签加粗H标签anchor文本的位置,如页面第一段等,每页可记录为一串关键词集合,权重每个关键词的词频格式位置等信息也记录在搜索引擎索引程序中的页面和关键词形成词汇结构,存储在索引库中。简化的索引词汇表如表2-1所示。任何细微的变化都会导致计算出来的指纹出现很大的差距。了解了搜索引擎的去重算法,SEO人员应该知道,单纯的加地必须改变段落的顺序。这个所谓的伪原创逃不过搜索。引擎的去重算法不能因为这个操作而改变文章关键词的特性,而且搜索引擎的去重算法很可能不止是在页面级别,而是在段落级别,混合不同的文章@ >intersections 互换段落顺序不会让转载和抄袭变成原创6。前向索引也可以称为索引。经过文本提取、分词、去噪和去重后,搜索引擎获得能够反映页面主要内容的独特的基于词的内容。然后搜索引擎索引程序可以提取关键词根据分词程序划分的单词将页面转换成由关键词组成的集合,并记录每个关键词的出现频率在页面上。格式如出现在title标签加粗H标签anchor文本的位置,如页面第一段等,每页可记录为一串关键词集合,权重每个关键词的词频格式位置等信息也记录在搜索引擎索引程序中的页面和关键词形成词汇结构,存储在索引库中。简化的索引词汇表如表2-1所示。任何细微的变化都会导致计算出来的指纹出现很大的差距。了解了搜索引擎的去重算法,SEO人员应该知道,单纯的加地必须改变段落的顺序。这个所谓的伪原创逃不过搜索。引擎的去重算法不能因为这个操作而改变文章关键词的特性,而且搜索引擎的去重算法很可能不止是在页面级别,而是在段落级别,混合不同的文章@ >intersections 互换段落顺序不会让转载和抄袭变成原创6。前向索引也可以称为索引。经过文本提取、分词、去噪和去重后,搜索引擎获得能够反映页面主要内容的独特的基于词的内容。然后搜索引擎索引程序可以提取关键词根据分词程序划分的单词将页面转换成由关键词组成的集合,并记录每个关键词的出现频率在页面上。格式如出现在title标签加粗H标签anchor文本的位置,如页面第一段等,每页可记录为一串关键词集合,权重每个关键词的词频格式位置等信息也记录在搜索引擎索引程序中的页面和关键词形成词汇结构,存储在索引库中。简化的索引词汇表如表2-1所示。

<p>简化的索引词表结构如表 2-1 所示,每个文件对应一个文件 ID。文件的内容表示为一组关键词其实在搜索引擎索引库中关键词也已经转换成关键词ID这样的数据结构,称为前向索引7。倒排索引 前排索引不能直接用于排名。假设用户搜索 关键词2。如果只有前向索引,排序程序需要扫描索引库中的所有文件,找到收录关键词2的文件才能继续进行相关计算等计算量不能满足返回排序结果的要求是实时的,所以搜索引擎会将正向索引数据库重建为倒排索引,并将文件对应的映射转换为< @关键词 到 关键词 到文件的映射如表 2-2 所示。在倒排索引中,关键词 是主键。每个 关键词 对应一系列文件。这个关键词出现在这些文件中,这样当用户搜索某个关键词排序程序在倒排索引中定位到这个关键词时,它可以立即找出所有收录这个