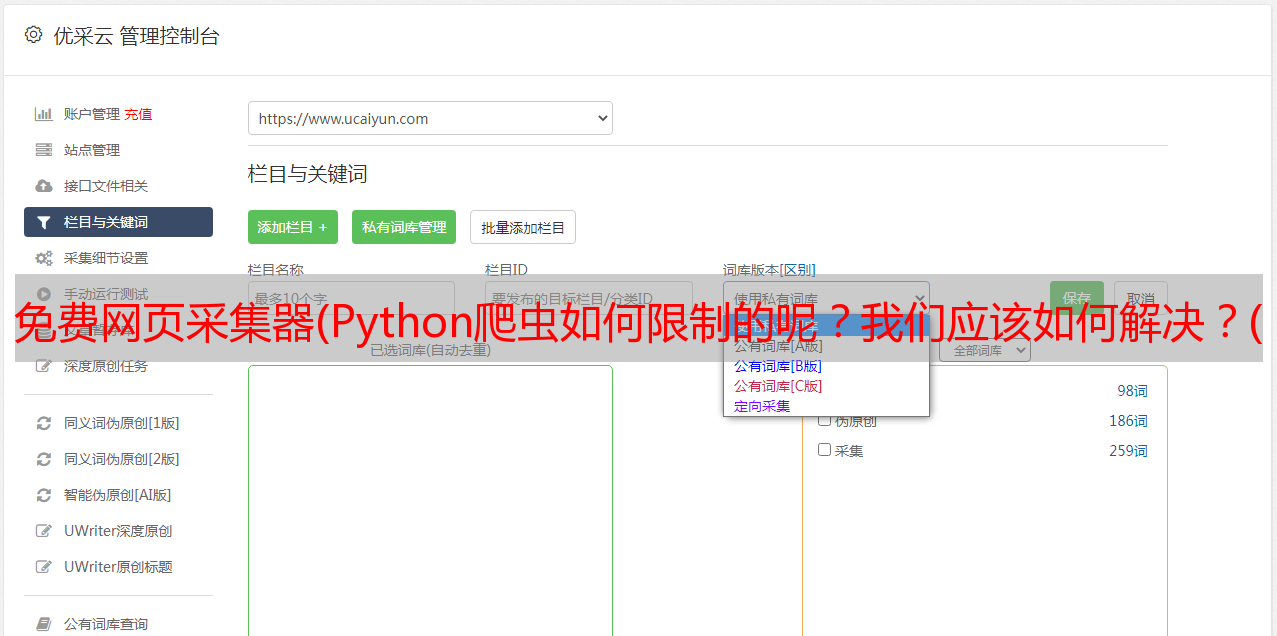

免费网页采集器(Python爬虫如何限制的呢?我们应该如何解决?(一))

优采云 发布时间: 2022-01-23 13:18免费网页采集器(Python爬虫如何限制的呢?我们应该如何解决?(一))

很多人会使用网页采集器,其实这也是通过程序采集来完成的,如果不使用代理IP,采集速度很快,而且会还是被屏蔽了。另外,这些网站等反爬策略也会影响我们采集网页的数据。这是怎么限制的?我们应该如何解决?

Python爬虫是根据一定的规则自动爬取网络数据的程序或脚本。可以快速完成爬取和分拣任务,大大节省时间和成本。由于Python爬虫的频繁爬取,会对服务器造成巨大的负载。服务器为了保护自己,自然要做出一定的限制,也就是我们常说的反爬虫策略,防止Python爬虫续作采集。反爬虫策略包括:

1.限制请求头

这应该是最常用也是最基本的反爬方法了,主要是初步判断你是不是用真实的浏览器操作的。

这一般是一个很好的解决方案,只需在浏览器中复制标题信息就可以了。

值得注意的是,很多网站只需要userAgent信息才能通过,但是有些网站还需要验证一些其他信息,比如知乎,有些页面还需要授权信息。那么需要添加哪些header,还需要尝试,可能还需要Referer和Accept-encoding等信息。

2.限制请求IP

有时我们的爬虫在爬取,突然页面打不开,出现403访问禁止错误。IP 地址很可能被 网站 阻止,不再接受您的任何请求。

3.限制请求cookies

当爬虫无法登录且无法保持登录状态时,请检查您的cookie。您的爬虫的 cookie 很可能已被发现。

以上是关于反爬虫策略的。对于这些方面,爬虫需要做好应对工作。不同的网站有不同的防御。建议先了解它们。