原创智能优化,原创度检查,一键采集,文章组合( 1.足球场景:开源FootballAction精彩片段智能剪辑(组图))

优采云 发布时间: 2022-01-20 06:01原创智能优化,原创度检查,一键采集,文章组合(

1.足球场景:开源FootballAction精彩片段智能剪辑(组图))

全文5352字,预计阅读时间14分钟

随着短视频的快速发展和安全管理需求的不断增加,视频领域的相关技术应用包括视频智能标注、智能辅导、智能编辑、智能安全管理、文本视频检索、视频精彩片段提取、视频智能封面等。成为人们生活的重要组成部分。

以视频相关业务为例,短视频网站希望快速标记每一个新作品并推送给合适的用户,编辑希望轻松从比赛视频中提取精彩片段,教练希望系统分析动作运动员并进行技术统计和分析。安全管理部门也希望能够准确进行视频内容审核,例如实时识别违规行为。编辑希望通过文字检索相关视频片段作为新闻资料、广告或推荐网站 希望为视频生成更漂亮的封面,提高转化率。这些业务对传统的人工处理方式是一个很大的挑战。

视频理解就是通过人工智能技术让机器理解视频内容。现在在短视频、推荐、搜索、广告、安全管理等领域具有广泛的应用和研究价值,如动作定位与识别、视频标注、文本视频检索、视频内容分析等任务通过视频理解技术处理。

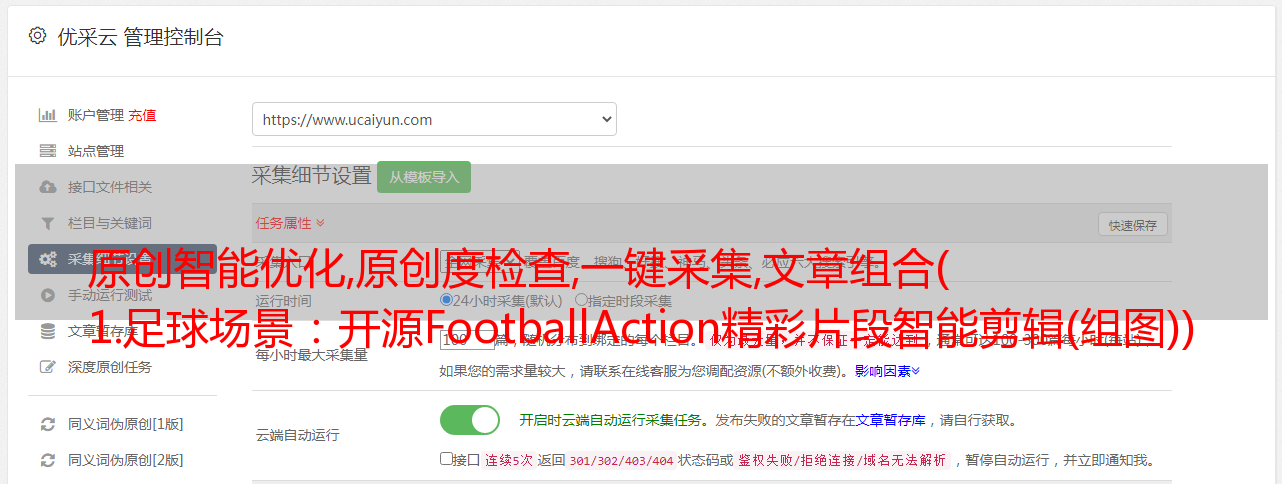

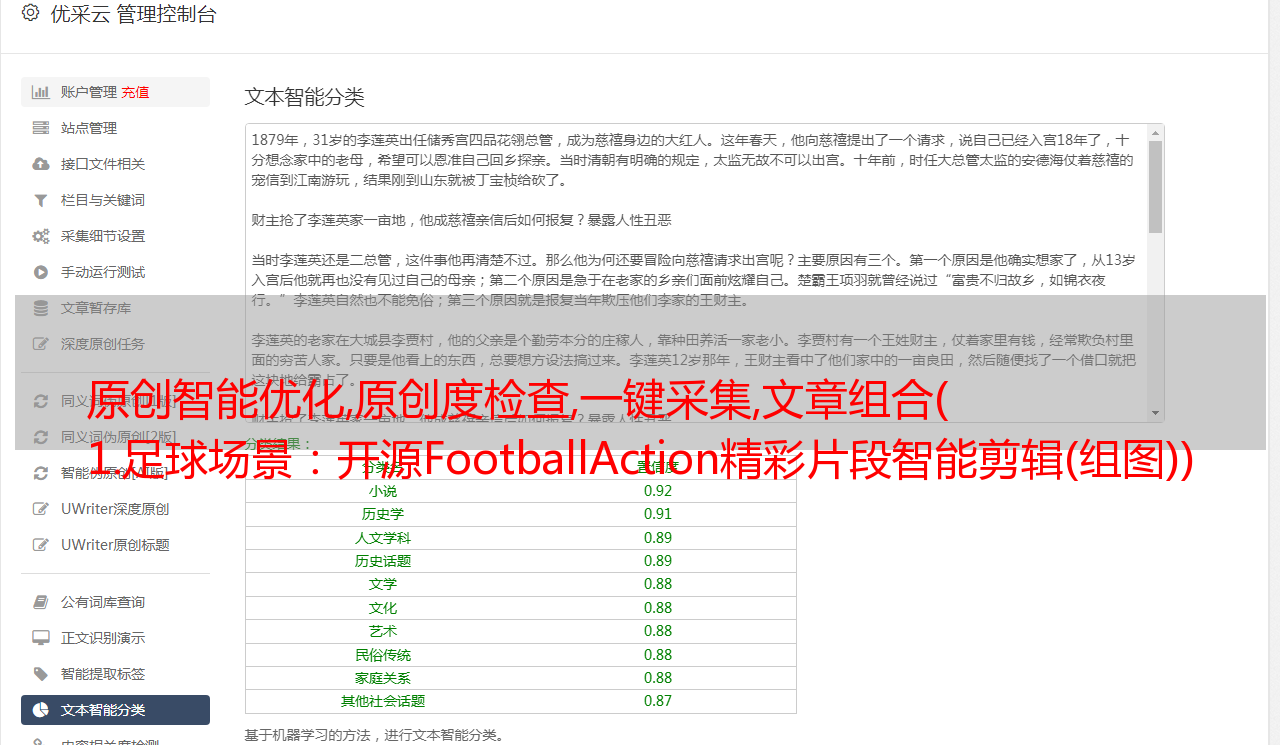

PaddleVideo是百度自主研发的工业级深度学习开源开源平台Paddle Video开发包。包括视频领域的众多模型算法和行业案例。本次开源主要升级点如下:

一、十大视频场景应用-工具详解

PaddleVideo基于足球/篮球/乒乓球/花样滑冰等体育行业场景,开源了一套通用的体育动作识别框架;开源面向互联网和媒体场景的知识增强型*敏*感*词*多模态分类标注、智能剪辑和视频剥离等解决方案;针对安防、教育、医疗等场景开源多种检测识别案例。百度智能云结合飞桨深度学习技术,也形成了一系列深度打磨的工业级多场景动作识别、视频智能分析制作、医学分析解决方案。

1. 足球场景:开源 FootballAction 亮点智能编辑解决方案

FootballAction是基于行为识别PP-TSM模型、视频动作定位BMN模型和序列模型AttentionLSTM的组合得到的,不仅可以准确识别动作类型,还可以准确定位动作的开始和结束时间。目前可以识别的动作类别有8种,包括:背景、进球、角球、任意球、黄牌、红牌、换人、掷界外球。准确率超过90%。

2. 篮球场景:开源BasketballAction亮点智能编辑解决方案

篮球案例BasketballAction的整体框架类似于FootballAction,共包括7个动作类别,分别是:背景、球门-三分球、球门-两分球、球门-扣篮、罚球、跳球。准确率超过90%。

3. 乒乓球场景:基于开源*敏*感*词*数据训练的动作分类模型

在Baidu Create 2021(百度AI开发者大会)上,PaddleVideo与北京大学联合发布了乒乓球动作识别模型,并基于500G多游戏视频构建了标准训练数据集,标签涵盖发球、拉球、挥杆等. 8类动作。其中,起止回合的准确率达到了97%以上,动作识别也达到了80%以上。

4. 花样滑冰动作识别

采用姿态估计算法提取关节点数据,最后将关节点数据输入时空图卷积网络ST-GCN模型进行动作分类,可实现30种动作的分类。飞桨与CCF(中国计算机联合会)举办了花样滑冰动作识别大赛,吸引了来自300所高校、200家企业的3800余名参赛者。冠军方案将baseline方案的准确率提高了12分,大赛前3名方案已开源。

5. 用于*敏*感*词*/多模态分类的知识增强视频标记

在视频内容分析方向,飞跑开源了基础VideoTag和多模态MultimodalVideoTag。VideoTag支持3000个来源于工业实践的实用标签,泛化能力好,非常适合国内*敏*感*词*短视频分类场景的应用,标签准确率达到89%。

MultimodalVideoTag模型基于真实的短视频服务数据,融合了文本、视频图像、音频三种模态,对视频多模态标签进行分类。与纯视频图像特征相比,可以显着提高高级语义标注的效果。该模型提供25个主标签,200+个二级标签,标签准确率超过85%。

6. 视频内容智能制作

在智能视频*敏*感*词*向,主要目标是协助内容创作者对视频进行二次剪辑。Flying Paddle开源了基于PP-TSM的视频质量分析模型,可实现新闻视频剥离和视频智能封面两种制作应用解决方案。新闻剥离是广电传媒行业编辑的重要素材来源;智能封面在直播、互娱等泛互联网行业的点击率和推荐效果中发挥着重要作用。

7. 视频交互标注工具开源

Flying Paddle开源了一款基于MA-Net的交互式视频分割(interactive VOS)工具,提供少量人工监督信号,以达到更好的分割效果。只需标注几帧就可以完成完整的视频标注,然后可以多次使用。与视频交互,不断提升视频分割质量,直到满足分割质量。

8.基于单一模型的时空动作检测实现87类一般行为识别

Flying Paddle 基于时空运动检测模型,实现了一种识别各种人类行为的方案。它利用视频多帧定时信息来解决传统单帧检测性能差的问题。从数据处理、模型训练、模型测试到模型推理,都可以实现AVA数据。重点识别80个动作和7种自发异常行为(摆动、打架、踢、追、吵、跑快、摔倒)。该模型的效果远远超过了目标检测方案。

9.无人机检测

禁飞区无人机检测面临以下挑战:

(1)无人机的目标很小,很难观察。

(2)无人机以可变速度移动。

(3)无人机飞行环境复杂,可能会被建筑物和树木遮挡。

针对上述挑战,飞炮开源了无人机检测模型,实现了无人机在多种复杂环境下的检测。

10.医学图像的分类与识别

浙江大学医学院附属第二医院和百度研究院基于公开的3D-MRI脑图像数据库,开源了帕金森3D-MRI脑图像分类识别项目。数据集包括neurocon、taowu、PPMI和OASIS-1。该数据集包括总共 378 例帕金森病患者 (PD) 和正常 (Con) 患者。提供 2D 和 3D 基线模型和 4 个分类模型以及用于 3D-MRI 大脑图像的预训练模型。其中,PP-TSN和PP-TSM达到了91%以上的准确率和97.5%以上的AUC,而TimeSformer的最高准确率达到了92.3%以上

二、五个冠军和顶级*敏*感*词*算法是开源的

百度研究院首个开源自研冠军和顶级算法

1. CVPR 2020 顶级会议论文:多模态预训练模型 ActBERT 首次开源

ActBERT 是一个融合视频、图像和文本的多模态预训练模型,它使用一种新颖的纠缠编码模块从三个来源进行多模态特征学习,以增强两个视觉输入和语言之间的交互功能。纠缠编码模块以全局动作信息为导向,将视觉信息注入语言模型,并将语言信息整合到视觉模型中。纠缠编码器动态选择适当的上下文以促进对象预测。简而言之,纠缠编码器使用动作信息来催化局部区域与单词的相关性。ActBERT 在包括文本视频检索、视频描述和视频问答在内的 5 个下游任务上明显优于其他方法。

2. CVPR 2021 顶级会议论文:文本视频检索模型 T2VLAD 首次开源

随着各种网络视频特别是短视频的普及,文本视频检索近来受到了学术界和工业界的广泛关注。特别是在引入多模态视频信息后,如何精细配准本地视频特征和自然语言特征成为一大难点。T2VLAD采用高效的全局-局部对齐方法,自动学习文本和视频信息共享的语义中心,并在聚类后匹配局部特征,避免了复杂的计算,使模型对语言有更精细的理解。和视频本地信息能力。

此外,T2VLAD直接将多模态视频信息(声音、动作、场景、语音、OCR、人脸等)映射到同一个空间,使用同一套语义中心进行聚类融合,计算出视频和文本的特征同中心在一定程度上解决了多模态信息难以综合利用的问题。T2VLAD 在所有三个标准文本视频检索数据集上都取得了出色的性能。

3.CVPR2020视频分割模型MA-Net首次开源

视频对象分割(VOS)是计算机视觉领域的一项基础性任务,在视频编辑、场景理解、自动驾驶等方面有着许多重要的应用场景。在交互式视频目标分割中,用户只需在视频的某一帧中对目标物体进行标注(比如在目标物体上画几条简单的线条),就可以得到整个视频中目标物体的分割结果算法。通过与视频多次交互,可以不断提高视频分割质量,直到用户对分割质量满意为止。

由于交互式视频分割需要用户与视频进行多次交互,因此需要考虑算法的时效性和准确性。MA-Net采用统一的交互和传播框架生成分割结果,保证了算法的时效性。此外,MA-Net通过内存存储来存储和更新多轮用户交互的信息,提高了视频分割的准确性。下表显示了模型在 DAVIS2017 数据集上的性能。

4.在首届开源ECCV 2020 Spotlight视频分割模型CFBI、CVPR2021视频对象分割国际大赛中,基于CFBI设计的解决方案在两项任务中获得冠军

在视频对象分割领域,半监督领域在今年备受关注。给定视频中第一帧或多个参考帧中的对象校准,半监督方法需要在整个视频中准确地跟踪和分割目标对象的掩码。以前的视频对象分割方法侧重于为给定的前景对象提取鲁棒特征,但这在复杂场景中非常困难,例如遮挡、尺度变化以及背景中存在相似对象。基于此,我们重新考虑背景特征的重要性,提出了一种前景与背景相结合的视频对象分割方法(CFBI)。

CFBI以对偶形式同时提取目标的前景和背景特征,通过隐式学习的方法提高前背景特征的对比度,提高分割精度。在CFBI的基础上,我们进一步将多尺度匹配和空洞匹配策略引入到视频对象中,并设计了一个更加健壮和高效的框架CFBI+。

CFBI 系列方法保持了视频对象分割领域单个模型的最高准确率记录。尤其是百度研究院在CVPR2020视频对象分割国际比赛中,单模型表现优于旷视-清华团队融合三个强大模型的结果。在今年刚刚结束的 CVPR2021 视频对象分割国际大赛中,基于 CFBI 设计的解决方案在两项任务中获得冠军。下表显示了 CFBI 模型在 DAVIS-2017 数据集上的性能。

5.ICCV 2021 无监督单目深度估计模型 ADDS 首次开源

ADDS是一种基于白天和夜间图像的自监督单目深度估计模型,它利用白天和夜间图像数据的互补性来减轻白天和夜间图像的大域偏移以及光照变化对精度的影响的深度估计。,在具有挑战性的 Oxford RobotCar 数据集上为全天图像实现了最先进的深度估计结果。下表显示了 ADDS 模型在白天和夜间数据集上的测试性能。

如果干货满满,不如行动起来。可以直接去Github地址获取完整的开源项目代码。记得支持星星采集:

- - - - - 结尾 - - - - -

百度极客说

百度官方技术公众号上线!

技术干货·行业资讯·在线沙龙·行业会议

招聘信息·内推信息·技术书籍·百度周边