武汉网站搜索引擎优化(一段时间后发现网站的收录率不高的这是原因分析)

优采云 发布时间: 2022-01-15 17:06武汉网站搜索引擎优化(一段时间后发现网站的收录率不高的这是原因分析)

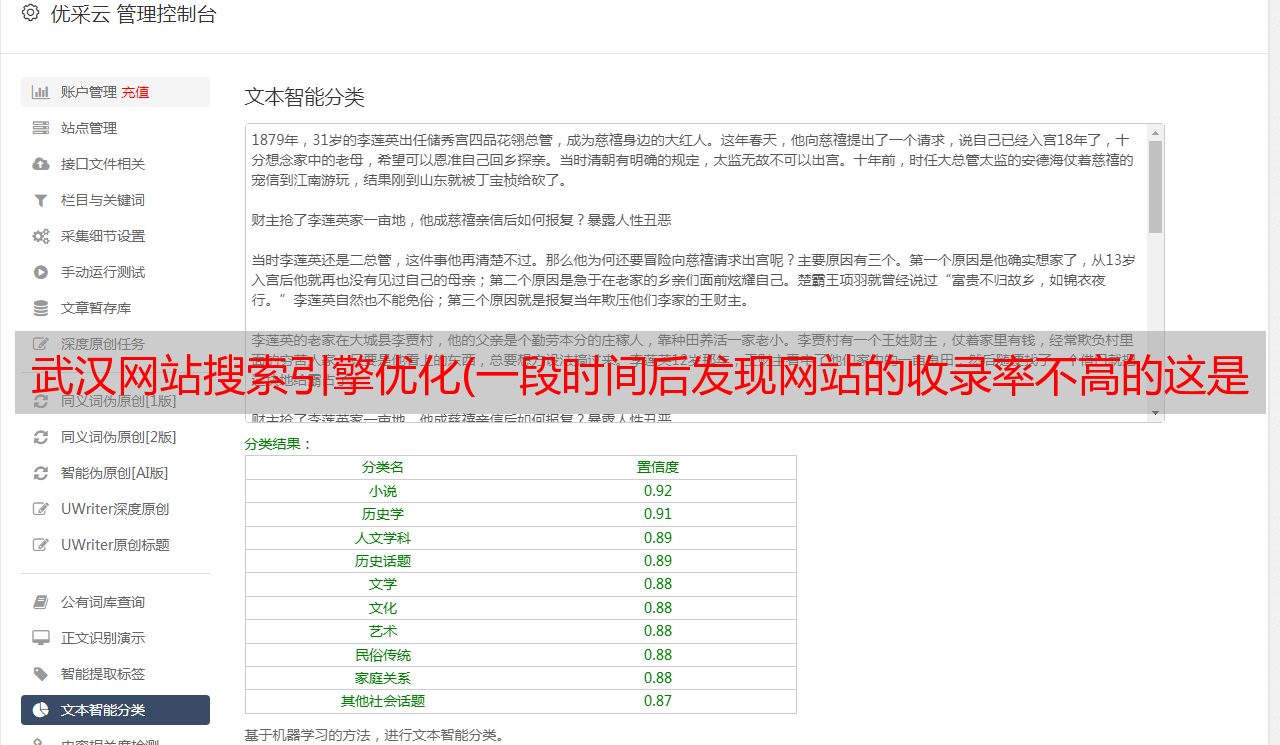

新的网站上线后,大部分站长都会向搜索引擎提交网站,但一段时间后发现网站的收录率不高高的。是什么原因?? 让我们一起分析并找到解决方案。

第一:robots meta标签被禁止,网站在诊断过程中发现网站的实际收录率很低,网站的部分栏目页面@> 可以被收录Complete 使用,但是有些栏目页面更新了原创 的文章,不会是收录。后来查看网站的代码,发现页面使用了noindex。该标签告诉蜘蛛这个页面不允许被索引。显然,保护这段代码的栏目页面不会是收录,更新的内容即使质量高也不会被爬取。同时,nofollow 标签告诉蜘蛛这个页面上的链接没有传递权重。如果网站上的页面链接都带有nofollow,那么这显然是在告诉搜索引擎这个页面没有价值。如果您的网站不能完全是 收录,请检查元标记是否有错误标记。

可以检测你的文件是否写入正确,或者可以直接为你生成文件,需要填写屏蔽文件路径。比如下面的例子:

Disallow:/news/不允许所有搜索引擎抓取news路径下的内容

如果将上面的文件添加到一个网站中,蜘蛛不会抓取网站上的新闻路径下的内容,而新闻目录下更新的文章永远是网站不会被收录更新,网站更文章,访问日志里的蜘蛛每天都会爬,但是还是不会给收录这些内容. 但是对于网站来说,news下面的内容很重要,所以错误的robots文件并不是网站不完整收录背后的主谋。

第三:被蜘蛛视为作弊内容。黑帽SEO在网站中被广泛使用,并使用作弊的方法来优化页面。此类页面蜘蛛不会提供给 收录。网站 长期使用隐藏文字在页面上叠加 关键词。如果在 网站 上检索到的蜘蛛有隐藏的文本和链接,那么您的 网站 很可能有隐藏的文本和链接。被蜘蛛从索引中删除,不会重新出现在搜索页面中。网站管理员可能会问什么是作弊内容。像往常一样,作弊方法使用相同的文字作为背景颜色,并积累了大量的关键词。这种作弊方法很容易被发现;使用noscript标签告诉浏览器当页面上有JS时,当浏览器关闭时,页面上应该显示什么内容,其实,noscript标签里堆积了很多关键词。这种做法相关且危险,很容易导致内容被删除。

第四:页面没有被访问过,特别是对于一些大型内容类型网站,网站上有很多内容页面,如果网站之间的内部内容不能很好的建立链,很多页面可能会面临下沉收录的现象,这些页面大部分离网站首页很远,蜘蛛无法爬取页面,导致无法被爬取蜘蛛收录。或者这个页面的链接都被标记为 nofollow 并且不传递任何权重。因此,网站 不完全是收录 是不公平的。对于网站的构建,最好不要在网站上使用nofollow标签、JS代码、蜘蛛无法识别转向等。对于深度较深的网站页面,

第五:内容质量低劣的垃圾网站,除了上面提到的4点优化方法的原因外,还有一个不可忽视的重要问题就是页面本身的问题。搜索引擎的识别能力逐渐加强。蜘蛛对原创的内容有一定的识别能力,无论是自身网站的重复内容还是从外部获取的重复内容网站,蜘蛛都能识别到一定程度上。蜘蛛的内容页面不会继续放在自己的数据库中,甚至会删除一些低权重网站的索引。在互联网垃圾泡沫时代,为了真正做到收录丰满度和网站高权重,

以上就是网站收录率低的五种情况及解决方法。提高网站的收录率的根本在于尊重搜索引擎收录的规则,努力提高网站的收录率。发布 原创文章。这肯定会提高搜索率。