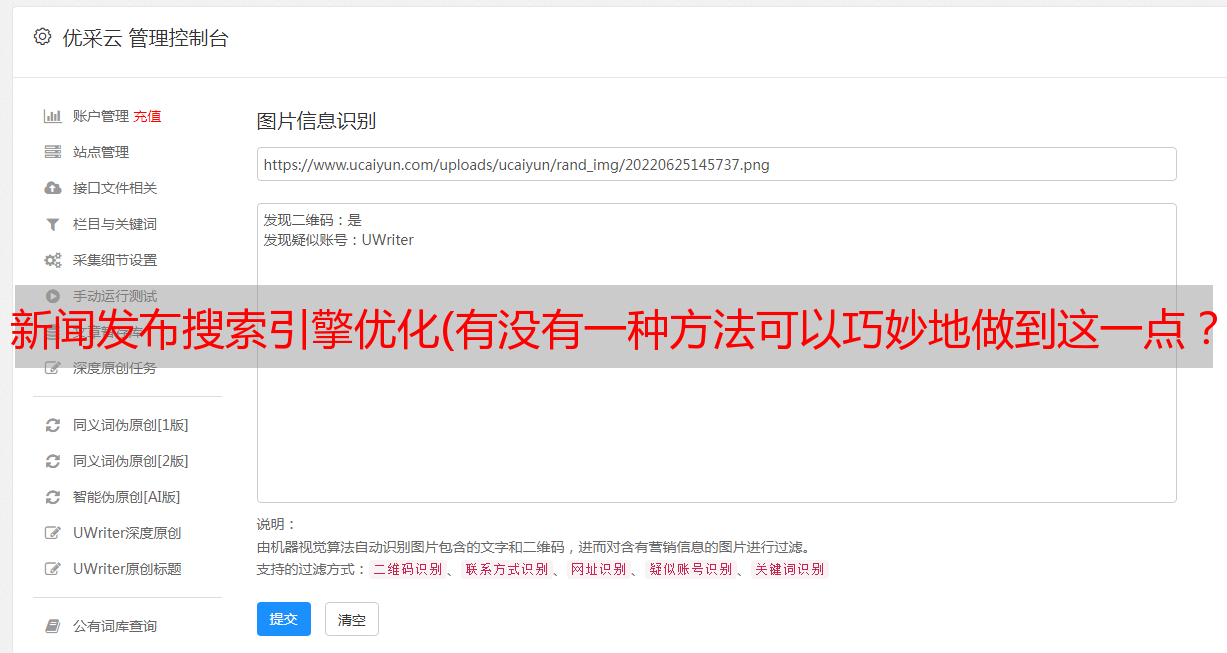

新闻发布搜索引擎优化(有没有一种方法可以巧妙地做到这一点?(图))

优采云 发布时间: 2022-01-14 19:08新闻发布搜索引擎优化(有没有一种方法可以巧妙地做到这一点?(图))

在 Google 办公时间聊天中,穆勒参与了关于旧新闻连接的 SEO 权重的讨论。

问这个问题的人说他们有大量的新闻稿,积累了来自高层网站的入站链接,可能来自新闻网站和其他可能重要的网站@给他们>。

问题围绕着如何重组 网站 使整个新闻稿部分不受谷歌限制,但仍然受益于入站链接

这就是问题

有一个带有大型新闻稿页面的 网站。

但是 文章 比较老...他们积累了很多反向链接,但他们没有任何流量。

但它们都是指向它们的高权限域

“我在想……我们可以把它移到档案中。但我仍然想从这些页面建立的 SEO 权重中受益。

那么,有没有办法巧妙地做到这一点?将它们移动到存档中,但仍然受益于这些页面随着时间的推移而增加的 SEO 权重?

在这个问题上有很多问题需要解决,特别是关于网站链接到某个细分的积累以及这些页面必须传播的“SEO权重”的部分。

有很多关于链接的 SEO 理论,因为尚不清楚 Google 如何使用它们。

“不透明”一词的意思是不透明的东西,很难看到。

不仅谷歌对他们如何使用链接不透明,而且他们使用链接的方式也在不断发展,就像他们的其他算法一样。这使得形成关于链接如何实际工作的想法变得复杂。

谷歌已经就其中一些想法发表了声明,例如授予所谓的跨域链接权限的概念。

因此,有时最好对链接保持开放的态度,以便接收可能与普遍接受的事实相矛盾的信息,尤其是当多个 Google 声明与这些观点相矛盾时。

穆勒在回答问题之前停下来思考。

然后他说:

“我的意思是,你可以将它们重定向到 网站 的不同部分。

如果您有此类旧内容的存档部分,这很常见,则将内容移到那里并将 URL 重定向到那里,这实际上告诉我们将链接转发到那里

问这个问题的人说,出于法律原因,某些内容需要存在,而谷歌不必一直访问这些页面。

他说他正在考虑禁止使用收录网页的文件夹。

阻止意味着阻止搜索引擎使用搜索引擎必须遵守的 Robots.txt 协议来抓取某些页面。

Robots.txt 是一种告诉搜索引擎不应抓取哪些页面的方法。

他的后续问题是:

这是否也意味着内置的 SEO Power 从此将被忽略?

谷歌的穆勒闭上眼睛,抬起头,停顿了片刻,才回答了这个问题。

约翰·穆勒在回答关于链接的 SEO 力量的问题之前停顿了一下

约翰说:

“因此,如果我们意识到它们与您的网站不太相关,我们可能会减少自动抓取的频率。

并不是说您需要完全停止它。

如果您使用 robots.txt 完全阻止它,我们不知道这些页面上的内容。

所以当有很多外部链接指向被 robots.txt 屏蔽的页面时,有时我们仍然可以在搜索结果中显示该页面,但我们会根据链接显示标题和文本说,哦,我们不知道到底发生了什么。

如果链接的页面只是引用了您的更多 网站,我们不知道。

我们无法将这些链接直接转发到您的主要内容。

因此,如果您看到这些页面非常重要并且人们正在链接到它们,那么我会尽量避免被 robots.txt 阻止。

要记住的另一件事是,这些新闻发布页面,随着时间的推移采集的东西,通常它们吸引的链接类型是一个非常有时间限制的东西,一个新的 网站 会链接到它一次。

当您查看链接数量时,您会看到这里有很多链接。但实际上,这些新闻网站s 档案中的这些都是旧新闻文章。

这也是他们有链接的标志,但这些链接不是很有用,因为同时它们是无关紧要的。

SEO链接权限?

值得注意的是,穆勒没有讨论链接的“搜索引擎优化权重”。相反,他专注于链接的时间相关质量和旧新闻相关链接的(缺乏)有用性。

SEO 社区倾向于发现与新闻相关的链接很有用。但穆勒说档案中存在“真正的旧新闻文章”,同时也表明这些链接由于相关性问题而无用。

一般来说,新闻是与时间相关的。五年前相关的内容现在可能不再有用或相关。

因此,在某种程度上,穆勒似乎间接淡化了链接的“搜索引擎优化权重”的概念,因为这些链接来自哪里(存档新闻)的问题,随着时间的推移,这些链接变得不那么有用,因为它们指的是一个主题可能不是常青树,而是现在的时刻,已经过去的时光。

原视频地址: