一键采集上传常见的细节问题(刚接触大数据一个月,把一些基本知识,总体架构记录一下)

优采云 发布时间: 2022-01-10 20:42一键采集上传常见的细节问题(刚接触大数据一个月,把一些基本知识,总体架构记录一下)

刚接触大数据一个月。记录了一些基础知识和整体结构。我觉得有很多陷阱和很多东西要学习。

什么是大数据:大数据是指在一定时间范围内不能被常规软件工具捕获、管理和处理的数据的集合。海量、高增长率和多样化信息资产的流程优化能力。

大数据的5V特性:Volume(很多),Velocity(高速),Variety(多样性),Value(低价值密度),Veracity(真实性),百度到处都能找到。

大数据处理流程:

1.是数据采集,建一个数据仓库,data采集是通过前端埋数据,接口日志调用流数据,数据库抓取,客户上传数据,而信息是根据数据保存各种维度的,感觉有些数据没用。

2.数据清洗/预处理:对接收到的数据进行简单的处理,比如将ip转换为地址,过滤掉脏数据等。

3.有了数据后,就可以处理数据了。数据处理的方式有很多种,一般分为离线处理和实时处理。离线处理是每天的常规处理。离线处理主要使用storm、spark、hadoop。通过一些数据处理框架,可以将数据计算成各种KPI。这里需要注意,不要只考虑功能,主要是搭建各种数据维度,做基础数据一定要可复用,后期各种KPI可以随意组合展示。

4.数据展示,做数据没用,要可视化,实现MVP,就是快速做出效果,不适合及时调整,这个有点像Scrum敏捷开发,数据可以使用datav、God Policy等展示,前端不错,可以忽略,自己画页面。

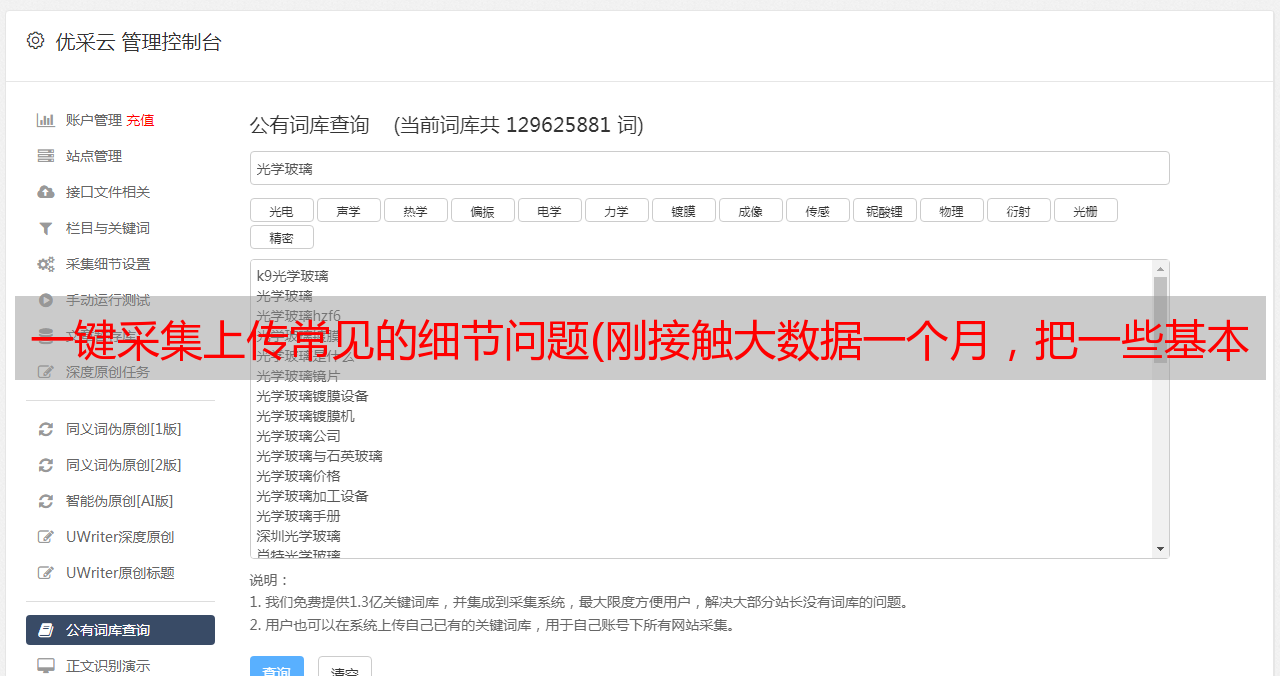

数据采集:

1.批量数据采集就是每天定时去数据库抓数据快照。我们使用maxComputer,可以根据需要设置每天对数据库进行快照,如何备份,如何设置数据源,如何设置如果出现错误,maxComputer中有文档。要使用maxComputer,您需要注册阿里云服务。该链接是 maxComputer 文档。

2.实时接口调用数据采集,可以使用logHub、dataHub、流式数据处理技术,DataHub具有高可用、低延迟、高扩展性、高吞吐等特点。

高吞吐:最多支持单个主题(Topic)日T级数据写入量,每个分片(Shard)最大支持8000万条Record级别的日写入量。

实时性:通过DataHub,可以实时采集各种方式产生的数据并实时处理,

设计思路:先写一个sdk记录公司所有后台服务调用接口的调用状态,开辟一个线程池,将记录的数据连续存储在dataHub和logHub中。前提是设置了接收数据的dataHub表结构。它是 dataHub 文档。下图是数据监控。您会看到数据将继续流入。

3.前端数据是埋的,要根据业务需要来设置,也是通过流式数据传输到数据仓库的,和上面第二步一样。

数据处理:

数据采集完成后,即可对数据进行处理处理,分为离线批处理和实时处理。

1.离线批处理maxComputer,这是阿里提供的大数据处理服务,是一个快速、全托管的TB/PB级数据仓库解决方案,编写数据处理脚本,设置任务执行时间,任务执行条件,您可以根据自己的需求生成每天需要的数据,并将数据作品链接为文档。下图为检测任务实例的运行状态

2.实时处理:使用storm/spark,目前我只能访问storm。网上有很多关于strom的基本概念。这里我就讲一下一般的处理过程。首先,设置要读取的数据源。只要风暴开始,它就不会停止。读取的数据源。Spout,用于读取数据。Tuple:消息传递的基本单位,理解为一组消息就是一个Tuple。stream,用于传输流,Tuples 的集合。Bolt:接受数据然后执行处理的组件,用户可以在其中做他想做的事。您可以在其中编写业务逻辑。Storm 不会保存结果。您需要编写自己的代码来保存它。结合这些是一个拓扑。一般来说,拓扑提交到服务器后,会一直读取数据源,然后通过 Stream 流数据,通过自己编写的 Bolt 代码对数据进行处理,然后保存到任何地方。有关于如何安装和部署 Storm 以及如何设置数据源的教程。我不会在这里多说。

数据展示:做完以上,我终于可以直观的展示出来了。由于前端技术不好,就借用了第三方展示平台datav。Datav 支持两种数据读取模式。第一个是直接读取数据库并计算您的数据。好的数据可以通过sql找到。您需要配置数据源。读取数据后,按照给定的格式格式化并显示出来。该链接是一个 datav 文档。可以设置图标的样式,也可以设置参数,

二是界面形式。可以直接使用api,在数据区配置为api,填写接口地址,以及需要的参数,这里不再赘述。

这次就记录这么多,以后再补充。内容是 原创。如有不妥之处,请评论并更正。