c#抓取网页数据(学习一下如何快速让搜索引擎收录网站收录的方法?)

优采云 发布时间: 2022-01-04 16:09c#抓取网页数据(学习一下如何快速让搜索引擎收录网站收录的方法?)

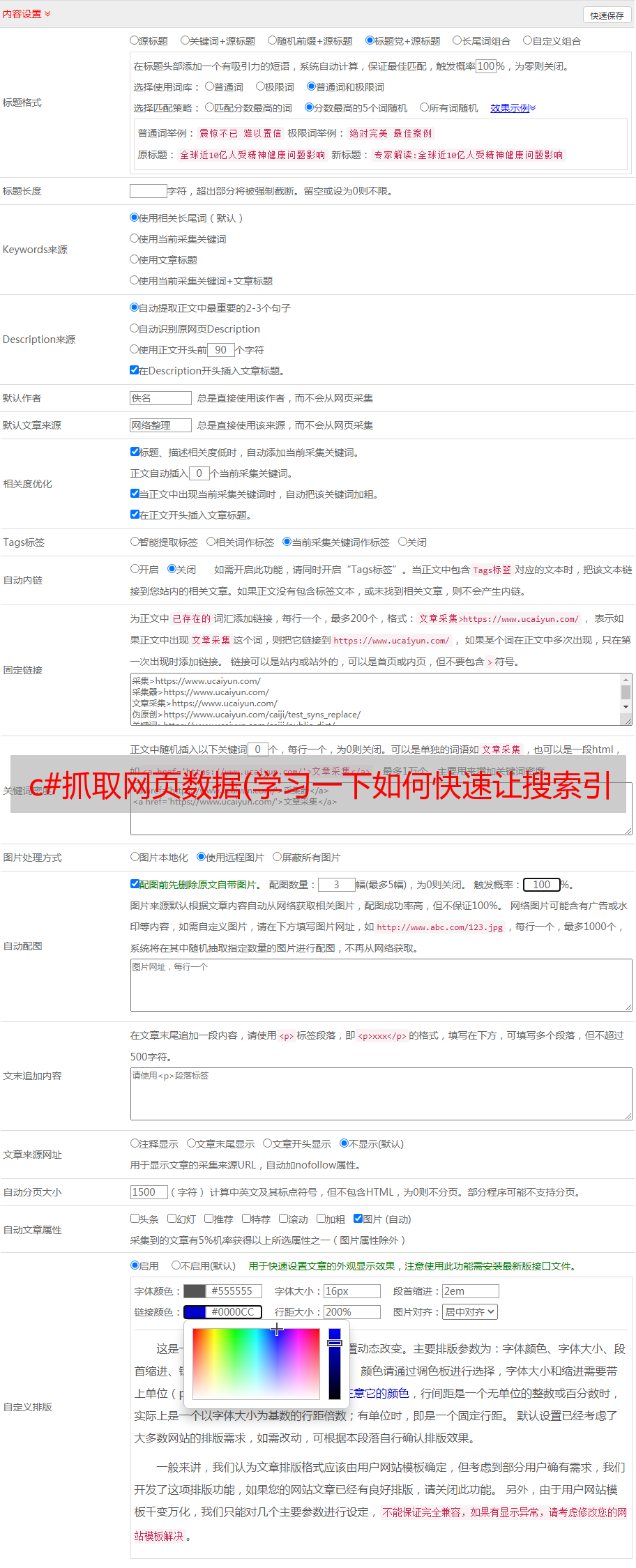

很多客户经常问我,网站没有被搜索引擎收录搜索到,而网站经常更新,但是在搜索引擎上搜索不到。本期,勇哥带你学习。如何快速获取搜索引擎收录网站。

在学习之前,先熟悉一个协议。robots 协议也称为 robots.txt(统一小写)。它是一个ASCII编码的文本文件,存放在网站的根目录下。它通常告诉互联网搜索引擎的机器人(也称为网络蜘蛛),这个网站中哪些内容不应该被搜索引擎的机器人获取,哪些内容可以被机器人获取。由于某些系统中的URL 区分大小写,因此robots.txt 的文件名应统一小写。robots.txt应该放在网站的根目录下。如果你想单独定义搜索引擎robots访问子目录时的行为,你可以将你自定义的设置合并到根目录下的robots.txt中,或者使用robots metadata(Metadata,也称为metadata)。robots协议不是规范,而是约定,所以不保证网站的隐私。以上是某某百科的解释。怎么生成,后面再说。既然告诉搜索引擎可搜索的和不可搜索的,自然要先生成网站的sitemap(网站地图)文件。目的是告诉搜索引擎爬取范围,我们看看如何生成网站的地图文件,我们继续。必须先生成网站的@网站 map)文件。目的是告诉搜索引擎爬取范围,我们看看如何生成网站的地图文件,我们继续。必须先生成网站的@网站 map)文件。目的是告诉搜索引擎爬取范围,我们看看如何生成网站的地图文件,我们继续。

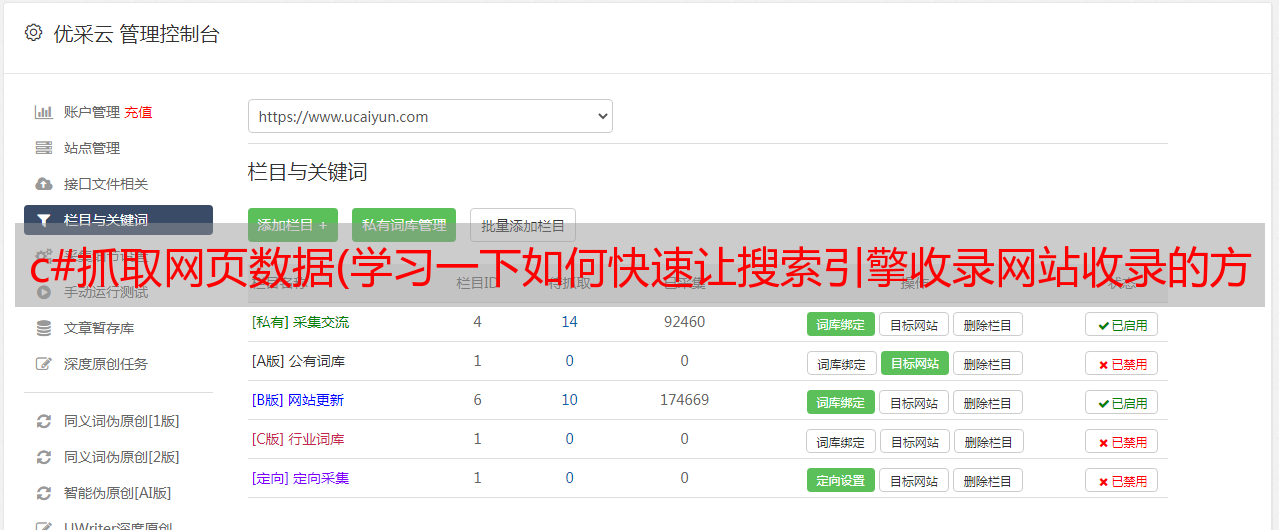

首先打开在线URL生成,输入你要收录的域名,点击Crawl,系统会自动开始蜘蛛爬行,爬行时间以网站的内容为准,下载完成后对应格式的文件。我们选择xml格式。

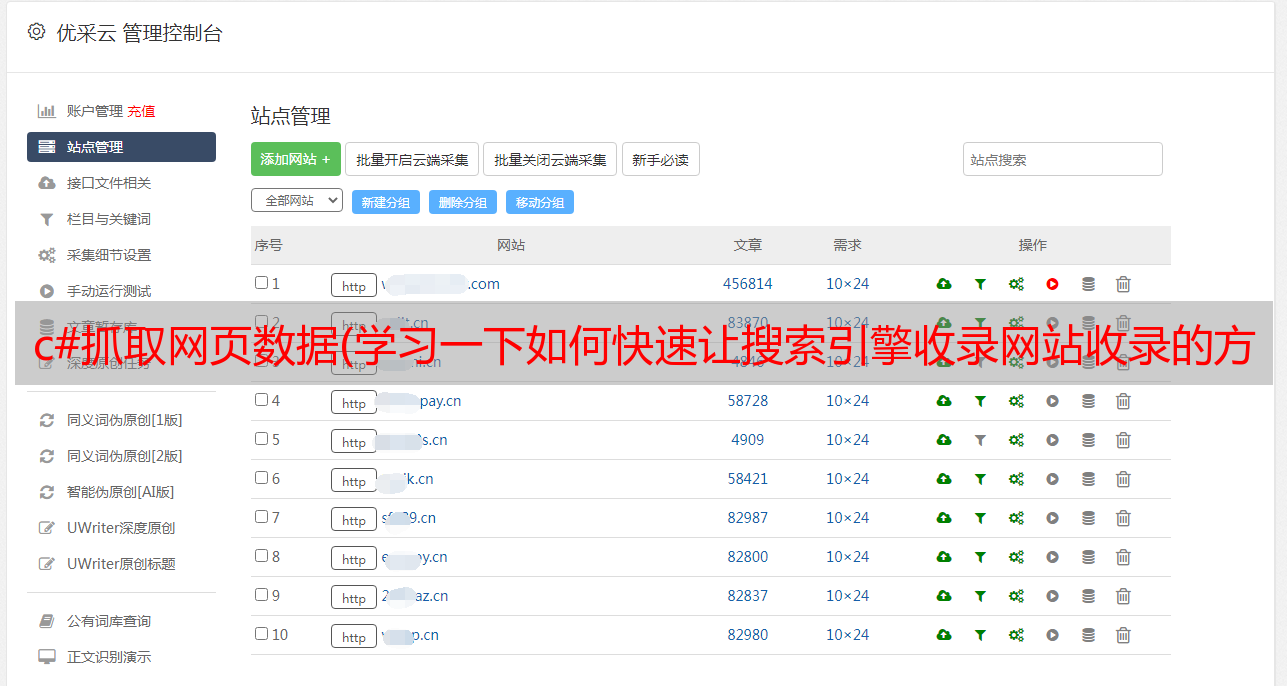

文件下载并上传到网站的根目录。打开搜索引擎网站的资源,登录账号,进入站点管理,添加网站,根据网站的协议头类型选择http/https,输入网站@要爬取的>域名。继续选择站点的域。

第三步,验证网站的所有权。一共有三种验证方式,您可以根据自己的实际情况进行选择。

验证完成后,即可将搜索引擎提交至网站。

提交完成后,搜索引擎会自动抓取网站地图文件中的网址,推送给搜索引擎进行抓取。

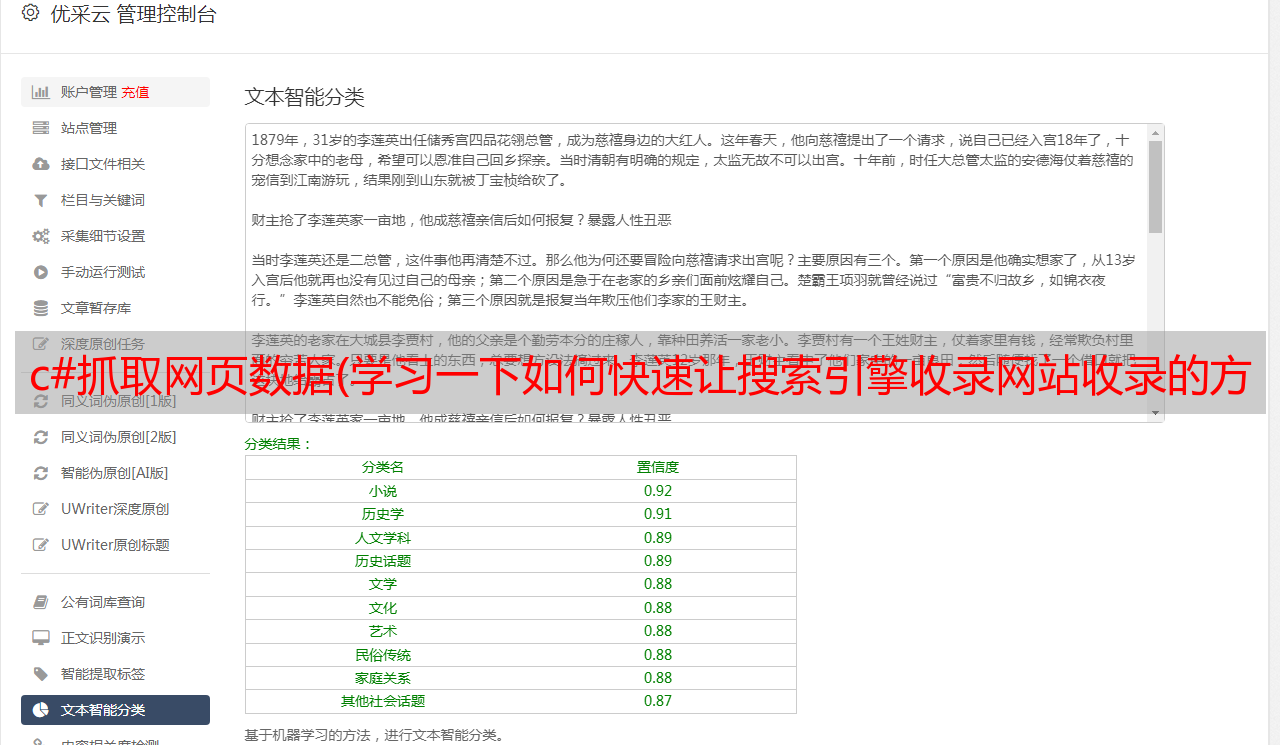

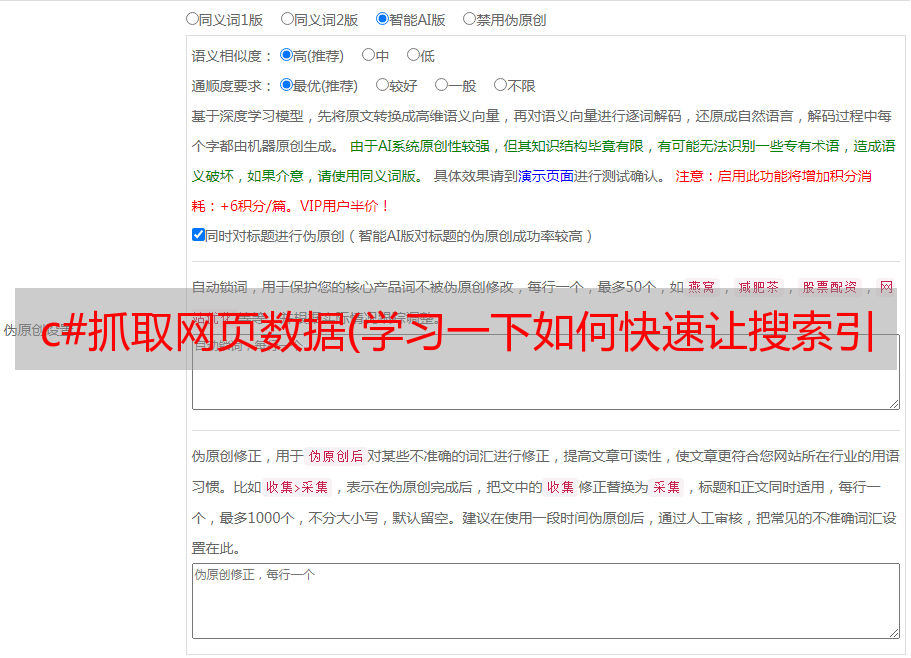

搜索引擎如何自动实现爬取?现在让我们谈谈robot.txt文件。其内容格式为:

图中1表示允许所有搜索引擎爬取,2表示不允许搜索引擎爬取这些目录,3表示读取xml文件。如果您了解文件的格式,您可以根据自己的实际情况修改文件的内容。修改完成后,还必须上传到网站的根目录下才能获取。

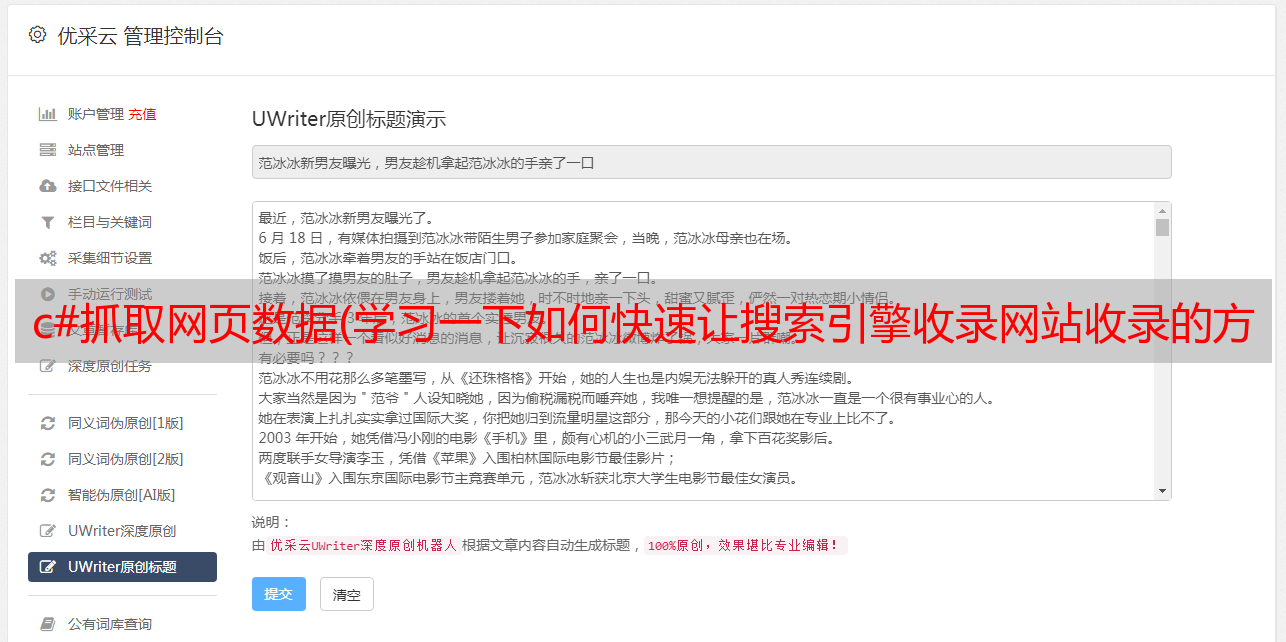

点击下图中的检测和更新。

以上操作完成后,选择爬虫诊断工具,让站长从蜘蛛的角度查看爬取的内容,自我诊断爬虫看到的内容是否与预期的内容一致。

一段时间后,将显示获取的结果。

全部设置完成后,第二天就会看到特定搜索引擎的爬取数据。

资源工具还提供了爬行异常的诊断。站长可根据系统提示的具体内容及时修复网站,达到爬行异常0的效果。

从上面可以发现,如果想让蜘蛛爬虫有稳定良性的访问,就必须保持更新网站的好习惯。更新内容后,及时重新生成sitemap文件上传到网站的根目录,这样网站进入良性期,无法阻止搜索引擎抓取。本次学习结束,我们下期再见!