网站文章一键采集( 700多个运营分析报告,全部爬虫到一个了Excel表格里)

优采云 发布时间: 2022-01-03 23:02网站文章一键采集(

700多个运营分析报告,全部爬虫到一个了Excel表格里)

今天的目标:了解数据爬取的过程

程序员最难学的不是java或c++,而是社交,俗称“嫂子”。

在社交方面,我被认为是程序员中最好的程序员。

比如之前,我做了一个“让我从叔叔变成小弟弟的海报生成表格”,就捡到了运营社区的*敏*感*词*姐。

上个月了,这个月又潜入爬虫的技术研究了。

技术满足的反面是孤独和空虚。

于是,我决定再次用爬虫来逗妹子。 . .

结果。 . .

我成功了! ! !

我将所有微博营销案例抓取到一张 Excel 表格中。

700多份运营分析报告,一键下载。

网站中的案例需要一一下载↑

对于表中的案例,喜欢和下载较多的↑

管理社区的女孩们快疯了!

秋叶Excel抖音女主:小梅↑

微博手绘大V博主姜江↑

社区运营老司机:颜敏姐姐↑

让我告诉你,如果我早两年爬行,我现在的室友会是谁? !

1- 什么是爬虫

爬虫,即网络爬虫。就是按照一定的规则自动抓取网络上的数据。

比如上一节自动抓取了“社交营销案例库”的案例。

想象一下,如果手动浏览页面下载这些案例,流程是这样的:

1-打开案例库页面 2-点击案例进入详情页面 3-点击下载案例pdf4-返回案例库页面,点击下一个案例,重复前面3步。

如果要下载所有的pdf案例,需要安排专人反复机械地下载。显然,这个人的价值很低。

爬虫取代了这种机械重复、低价值的数据采集动作,使用程序或代码自动批量采集数据。

爬虫的好处

简单总结一下,爬虫的好处主要有两个方面:

1- 自动爬取,解放人力,提高效率

机器,低价值的工作,用机器来完成工作是最好的解决方案。

2- 数据分析,跳线获取优质内容

与手动浏览数据不同,爬虫可以将数据汇总整合成数据表,方便我们以后做数据统计和数据分析。

例如,在“社交营销案例库”中,每个案例都有查看次数和下载次数。如果要按查看次数排序,则会优先查看查看次数最多的案例。将数据抓取到Excel表格中,并使用排序功能,方便浏览。

爬虫案例

可以抓取任何数据。

掌握了爬虫的技巧,可以做的事情很多。

Excelhome 的帖子抓取

我教Excel,Excelhome论坛是个大宝。

一篇一篇阅读太难了,爬了1.40,000个帖子,挑一个浏览量最多的。

窗帘选择文章爬行

窗帘是梳理轮廓的好工具。很多大咖用窗帘写读书笔记,不用看全书也能学会要点。

我没时间一一浏览选定的画面文章,爬取所有选定的文章,整理出自己的知识大纲。

姜曹的公众号文章爬取

我很喜欢曹将军。我有我这个年龄所缺乏的逻辑、归纳和表达能力,文章文章的精华。

公众号太多,手机看书容易分心?爬入 Excel,然后开始查看最高的行读数。

另外还有抖音播报数据、公众号阅读、评论数据、B站弹幕数据、网易云评论数据。

爬虫+数据分析给网络带来更多乐趣。

2- 简单的爬虫,锋利的工具

一说到爬虫,大多会想到编程技术,python,数据库,漂亮,html结构等等,让人望而生畏。

其实基础爬虫很简单,借助一些采集软件,一键即可轻松完成。

常用爬虫软件

我抓取数据时用到了以下软件,推荐给大家:

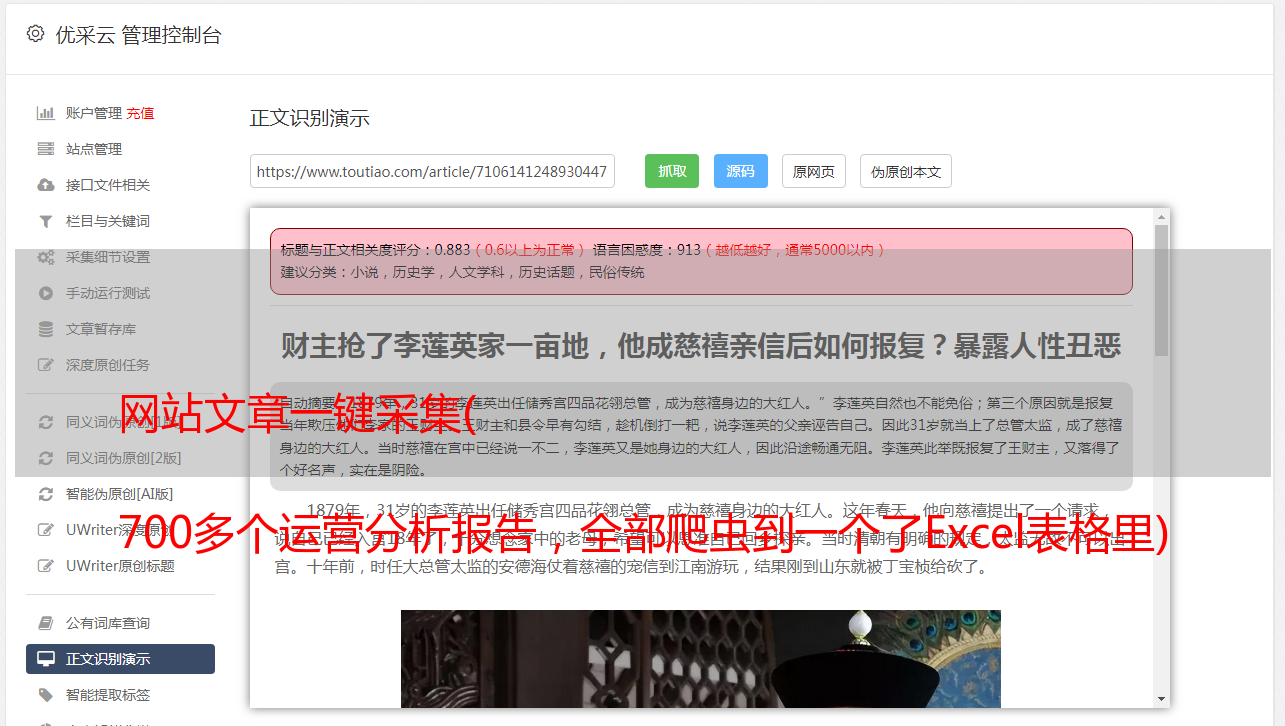

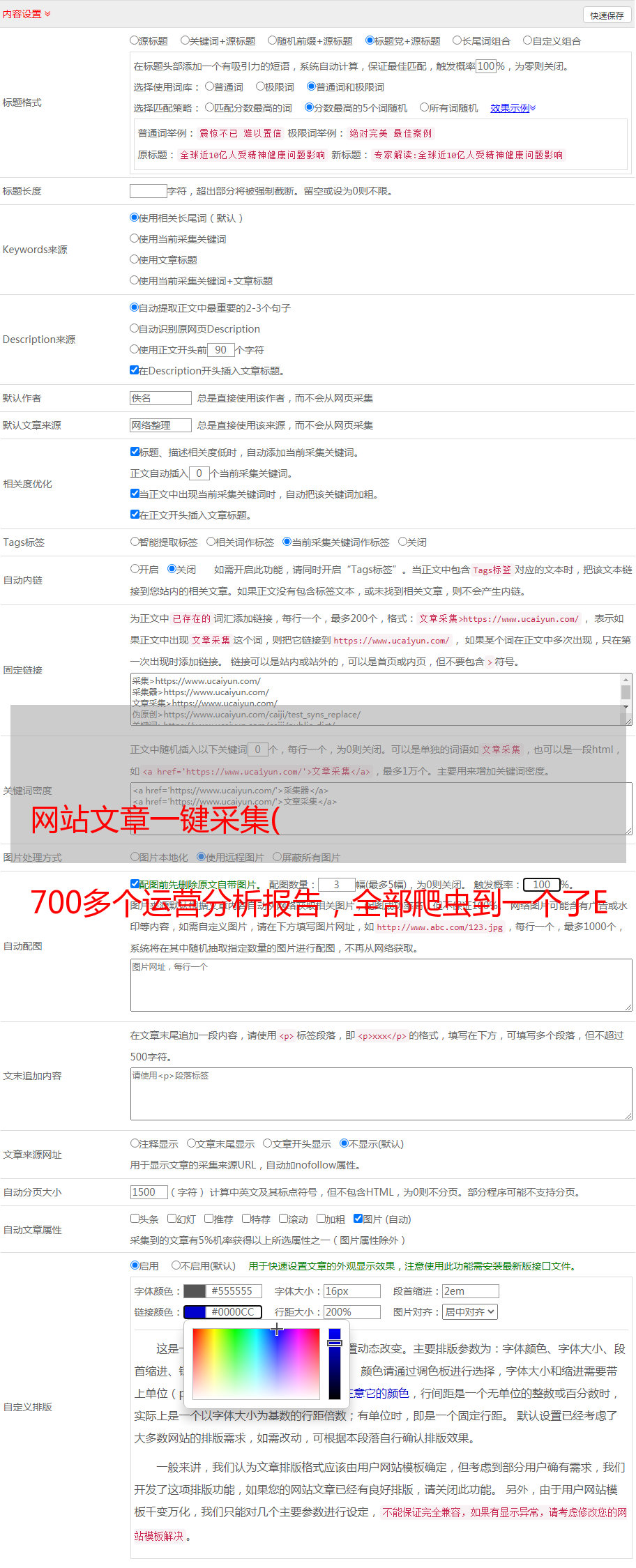

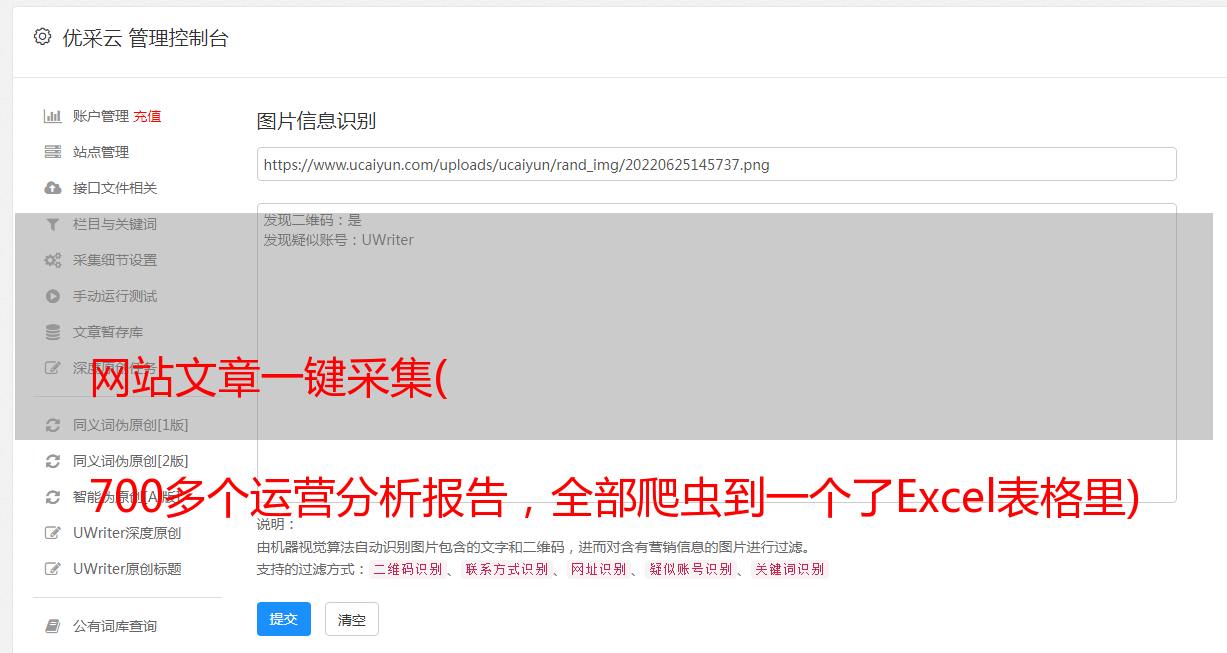

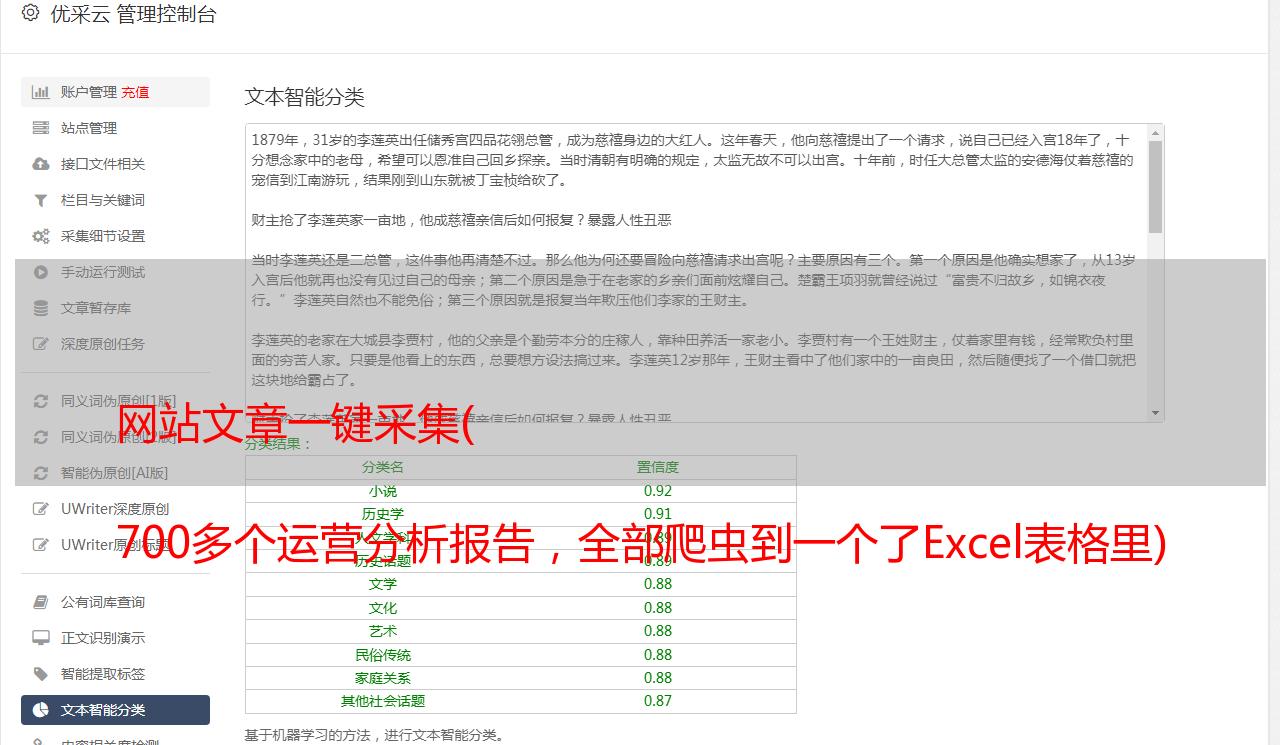

1- 优采云采集器

简单易学,采集数据和向导模式可通过可视化界面和鼠标点击获得。用户无需任何技术基础,输入网址,一键提取数据。

这是我接触的第一个爬虫软件,

优点:

1-使用过程简单,上手特别好。

缺点:

1- *敏*感*词*数量限制。 采集,非会员只能导出数据,限制为1000。2- 导出格式限制。非会员只能以txt格式导出。

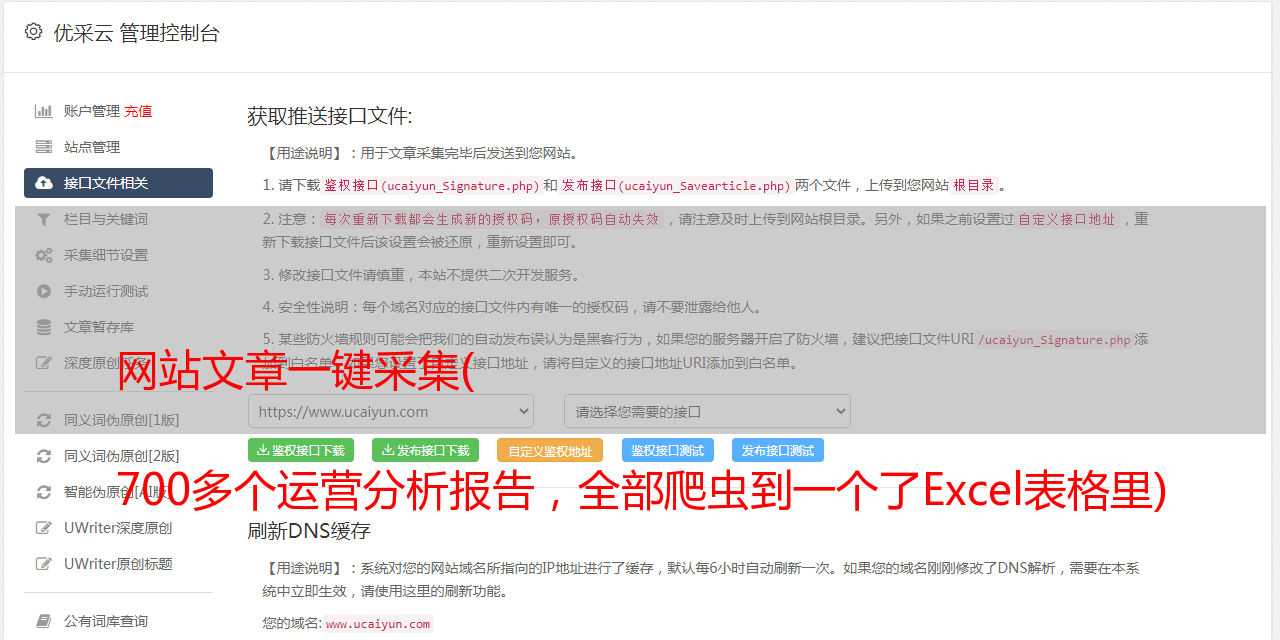

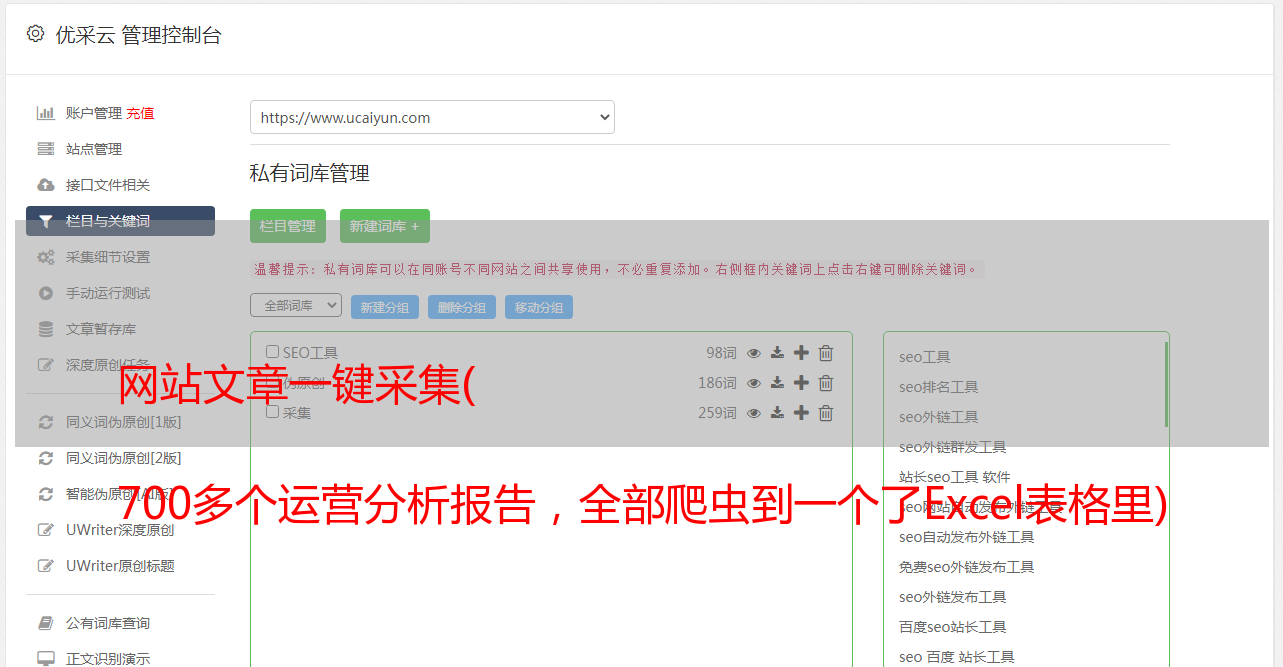

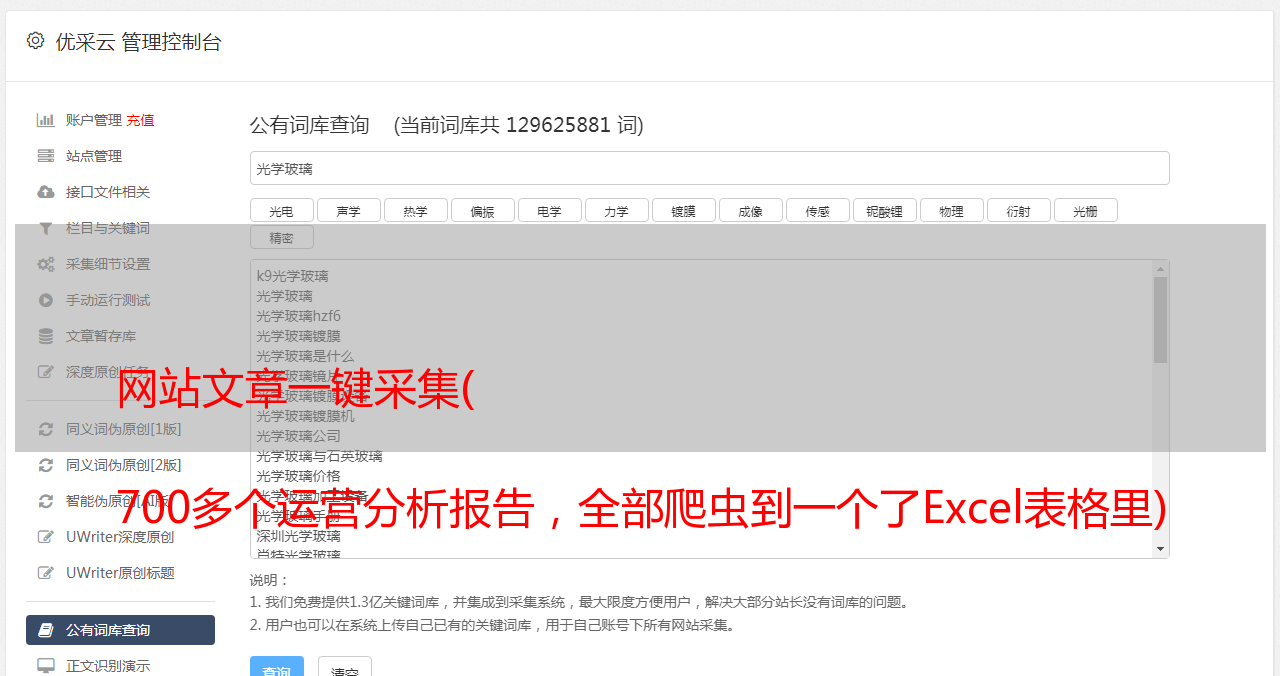

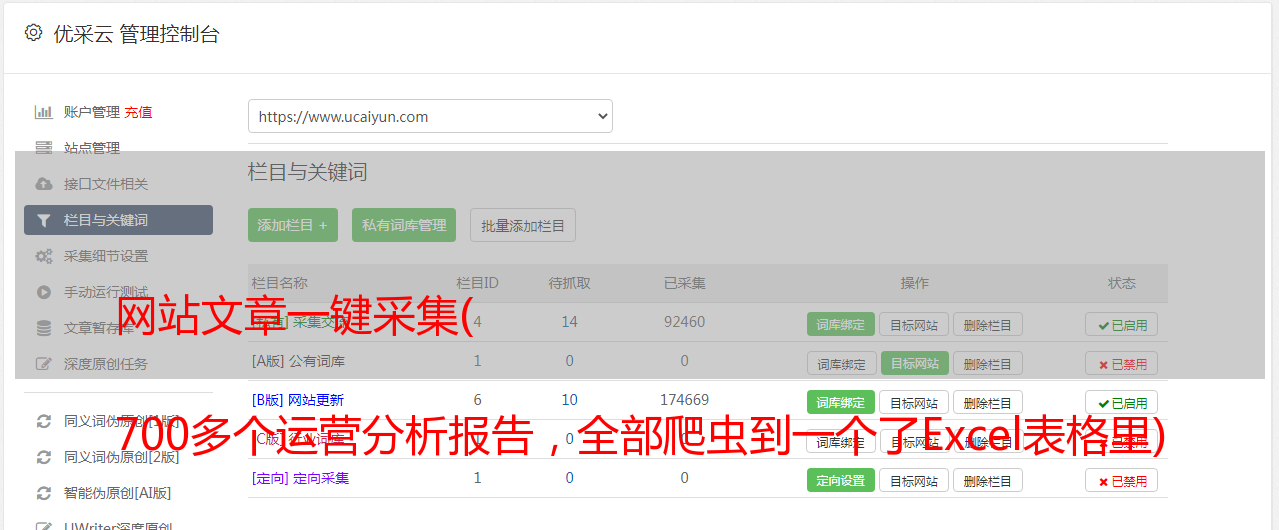

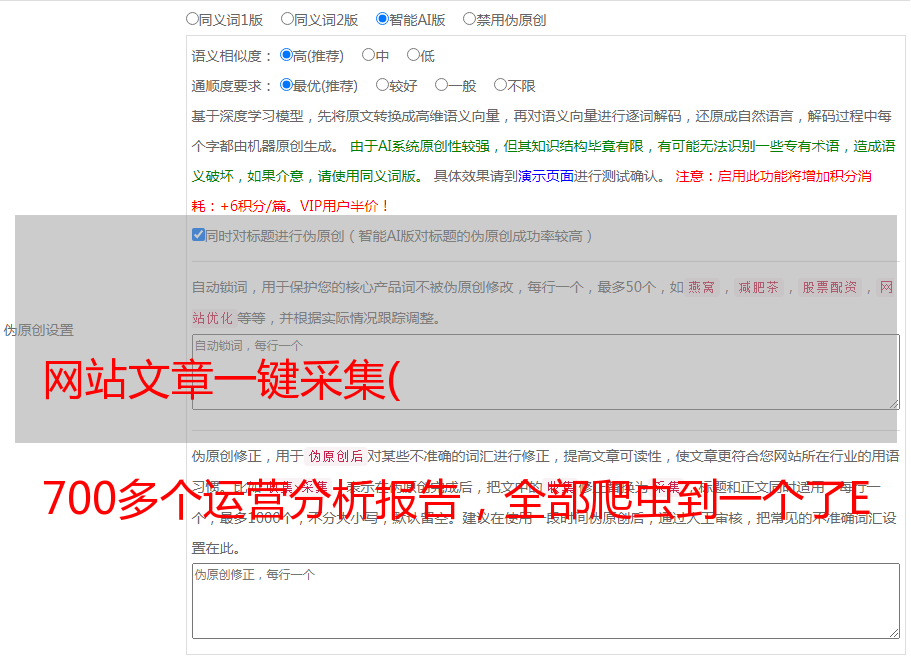

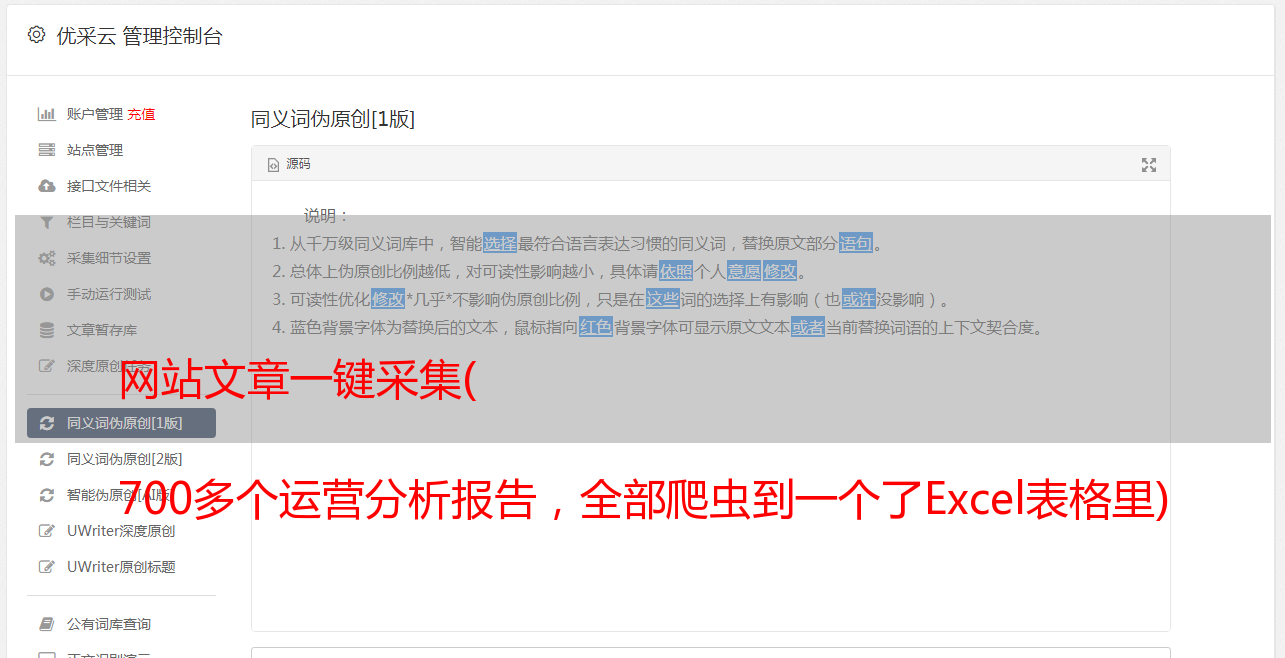

2- 优采云

无需学习爬虫编程技术,简单三步即可轻松抓取网页数据,支持多种格式一键导出,快速导入数据库

在优采云不能满足我的需求后,我开始尝试更专业的采集软件,找到了优采云。

优点:

1- 采集 更强大的功能,可以自定义采集的流程。 2- 导出格式和数据量没有限制。

缺点:

1- 过程有点复杂,新手上手难度较大。

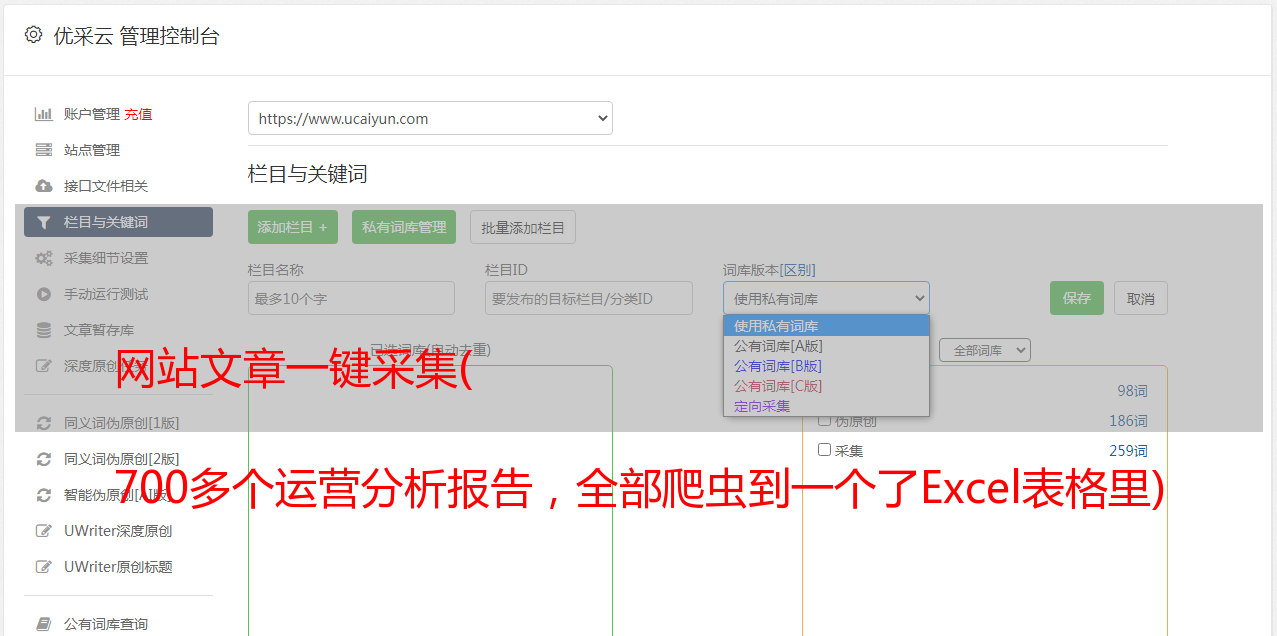

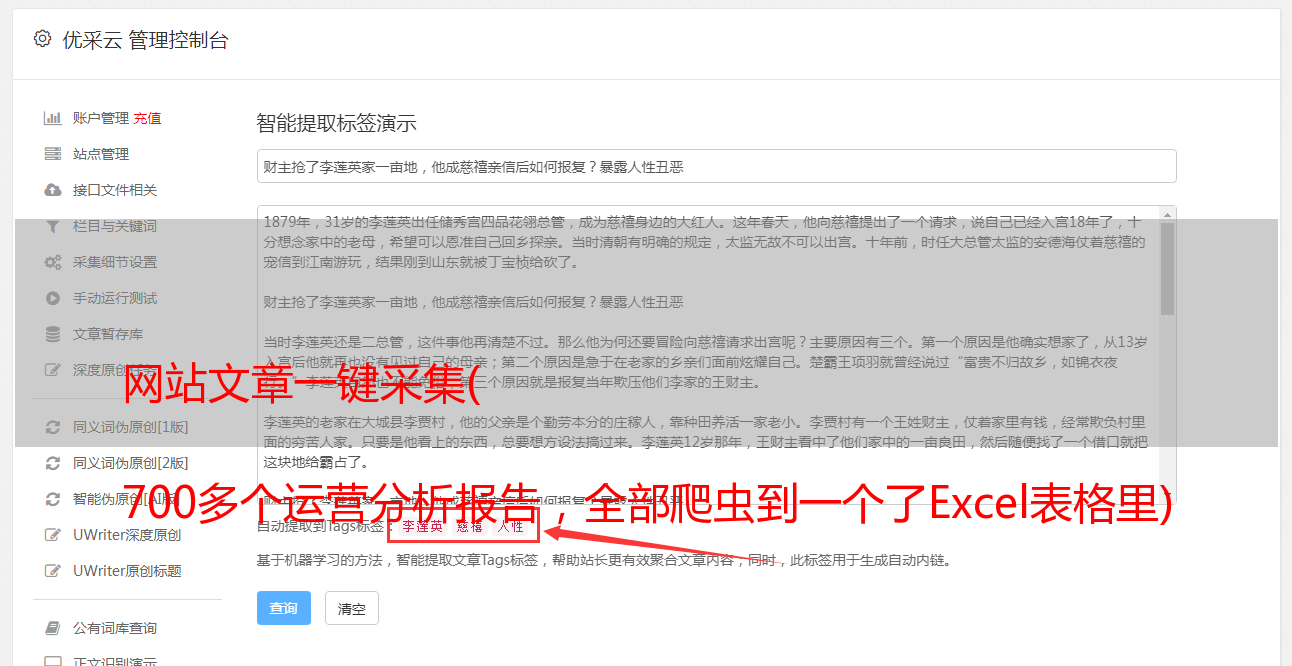

3- 优采云采集器(推荐)

智能识别数据,小白神器基于人工智能算法,只需要输入网址即可智能识别列表数据、表格数据和分页按钮,无需配置任何采集规则,一键< @采集 。自动识别列表、表格、链接、图片、价格、电子邮件等

这是我现在用的采集软件。可以说抵消了前两个采集器的优缺点,用户体验更好。

优点:

1- 自动识别页面信息,简单上手 2- 导出格式和数据量无限制

目前没有发现缺点。

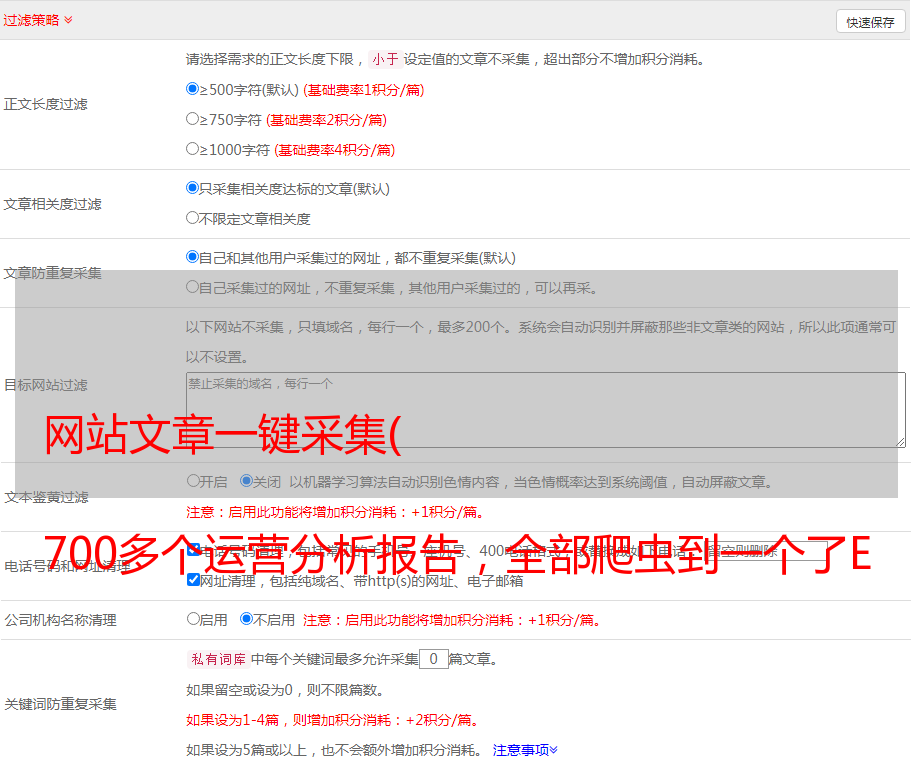

3-爬虫操作流程

注意,注意,接下来是动手部分。

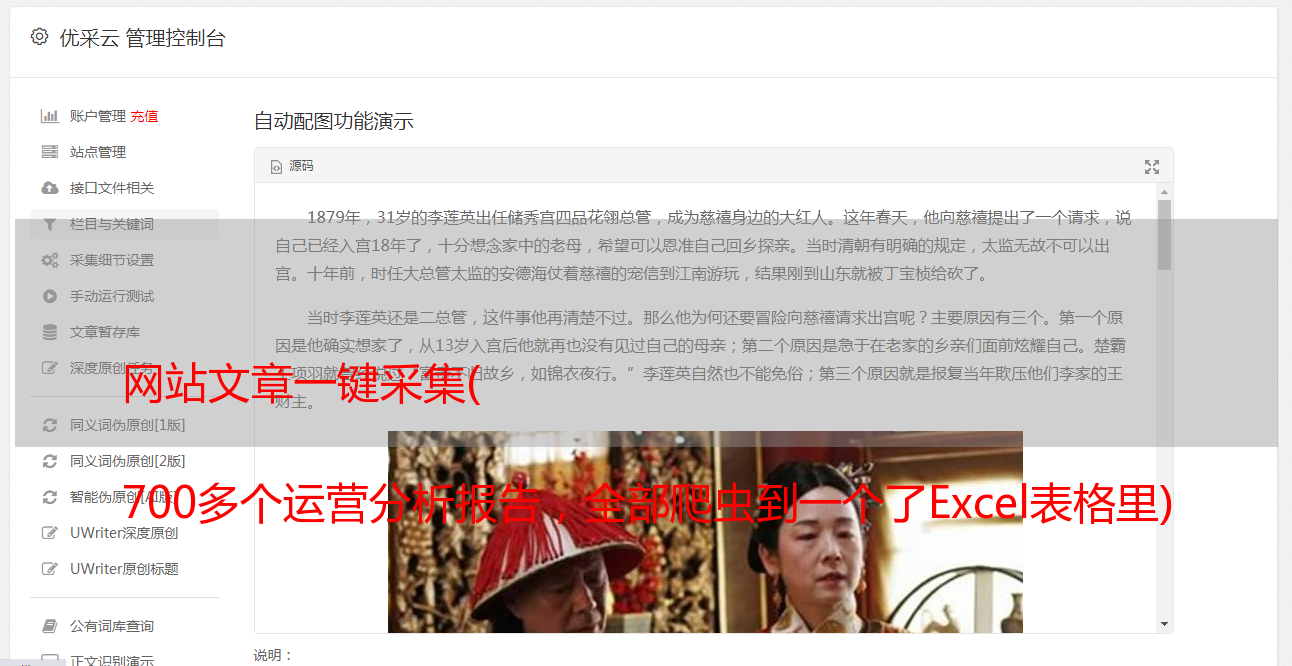

我们以“Curtain Selection文章”为例,用“优采云采集器”体验爬行的乐趣。

采集后的效果如下:

1- 复制采集

的链接

打开窗帘官网,点击“精选”,进入精选文章页面。

复制特色页面的网址:

2- 优采云采集数据

1-登录“优采云采集器”官网,下载安装采集器。

2-打开采集器后,在“智能模式”中点击“开始采集”,新建一个智能采集。

3- 粘贴到屏幕的选定网址中,点击立即创建

在这个过程中,采集器会自动识别页面上的列表和数据内容。整个过程由AI算法自动完成,等待识别完成。

页面分析识别正在进行中↑

页面识别完成↑

4- 点击“开始采集”->“开始”开始爬虫之旅。

3- 采集数据导出

在数据爬取过程中,您可以点击“停止”结束数据爬取。

或者等待数据抓取完成,在弹出的对话框中点击“导出数据”。

导出格式,选择 Excel,然后导出。

4- 使用 HYPERLINK 函数添加超链接

打开导出的表格,在I列添加HYPERLINK公式,添加超链接,一键打开对应的文章

公式如下:

=HYPERLINK(B2,"点击查看")

到此,您的第一个爬虫之旅已成功完成!

4- 总结

爬虫就像在 VBA 中记录宏,记录重复动作而不是手动重复操作。

我今天看到的只是简单的数据采集。还有很多关于爬虫的话题和非常深入的内容。例如:

1- 身份验证。需要登录才能抓取页面。

2- 浏览器检查。比如公众号文章只能获取微信的阅读数。

3- 参数验证(验证码)。该页面需要验证码。

4- 请求频率。例如页面访问时间不能小于10秒

5- 数据处理。需要抓取的数据需要从数字、英文等内容中提取出来。

我是拉小邓,会设计表格的Excel老师