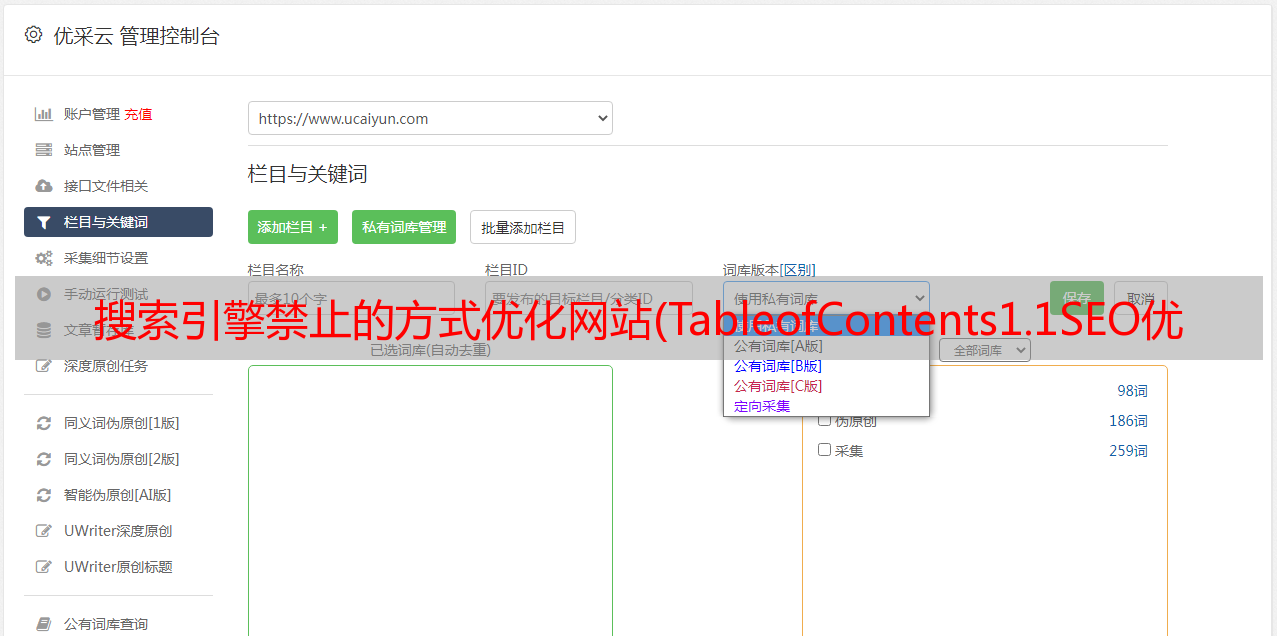

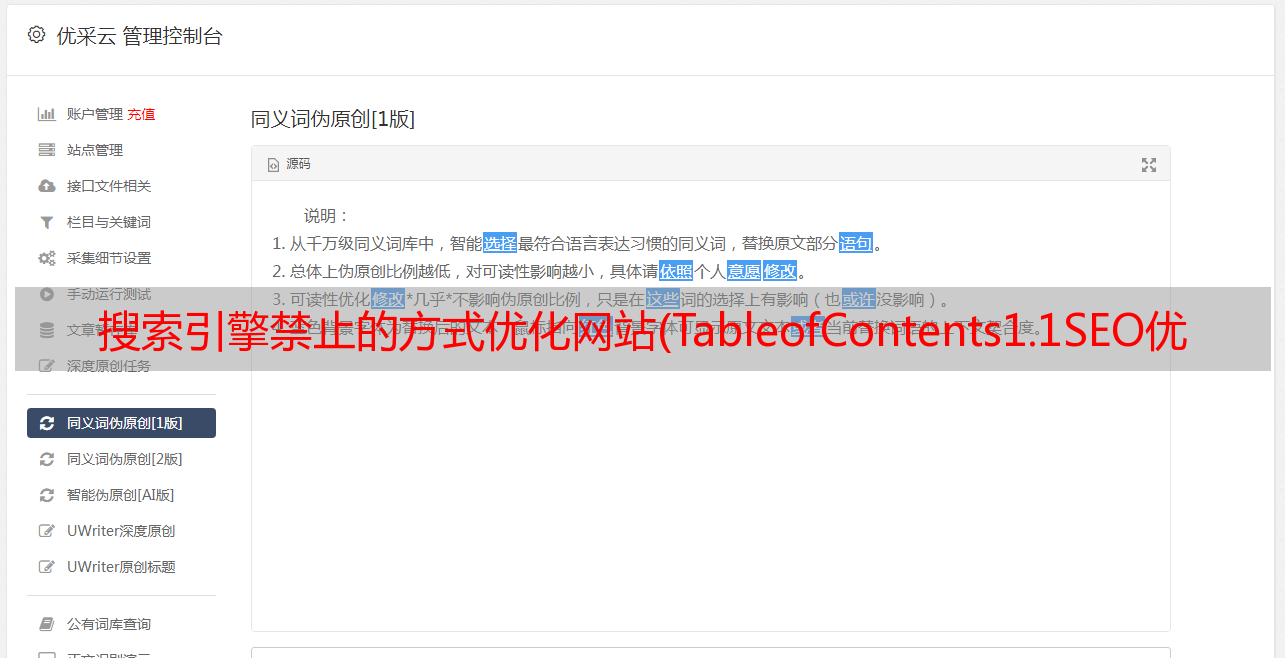

搜索引擎禁止的方式优化网站(TableofContents1.1SEO优化目的(搜索引擎优化)方法介绍)

优采云 发布时间: 2022-01-01 11:27搜索引擎禁止的方式优化网站(TableofContents1.1SEO优化目的(搜索引擎优化)方法介绍)

目前处于边录音边学习状态。记录网站建设过程中遇到的问题,供大家参考。最终效果可以在我的主页查看:

目录

1.1 SEO优化目的(搜索引擎优化)

方法:设置robots.txt,自定义是否可以抓取网页。

允许爬取的利弊:

优秀:通过做SEO,优化可以让网站排名靠前,所以只要搜索相关的关键词,就能找到自己的网站。

为搜索引擎提供简洁明了的索引环境

防止某些文件被搜索引擎索引,可以节省服务器带宽和网站访问速度

快速增加网站权重和访问量;

劣势:反向优势

1.2什么是robots.txt

robots.txt 是搜索引擎抓取网页时要查看的第一个文件。搜索机器人访问站点时,首先会检查根目录下是否存在robots.txt。有则判断爬取范围,无则按Link order爬取。

为什么需要使用robots.txt来告诉搜索机器人不要抓取我们的一些网页,比如:后台管理文件、程序脚本、附件、数据库文件、编码文件、样式表文件、模板文件、导航图片和背景图片等等。毕竟这些页面或文件是被搜索引擎收录,用户是看不到的。他们中的大多数需要密码才能访问或数据文件。在这种情况下,让搜索机器人再次爬行会浪费服务器资源,增加服务器压力。因此,我们可以使用robots.txt告诉机器人专注于我们的收录我们的文章页面,提升用户体验。

1.3 设置Robots.txt的注意事项

1、作为搜索引擎访问的第一个目录,robots文件过长也会影响蜘蛛的爬行速度。因此,对于搜索引擎被禁止的网页,可以适当使用noffollow标签,使其错误网站传递权重。

2、 机器人设置中 Disallow 中 / 和 // 的区别。例如:禁止; /a和Disallow的区别:/a/,很多站长都看到过这样的问题,为什么有的协议要加斜杠,有的不加斜杠?今天想说的是:如果不加斜杠,则所有以a开头的目录和页面都被屏蔽,后者的意思是屏蔽当前目录下的所有页面和子目录的爬取。

一般来说,我们更倾向于选择后者,因为定义越大越容易造成“误杀”。

3、 有一系列禁止和允许设置。搜索引擎会根据 Allow 和 Disallow 的第一个成功匹配来决定先访问哪个 URL 地址。

4、 不推荐使用Robots.txt文件来阻止删除的目录块。很多站长害怕404问题,经常删除一些目录,屏蔽掉,禁止搜索引擎抓取此类链接。事实上,这样真的好吗?即使你屏蔽了,如果之前的目录有问题,蜘蛛也不会从库中移除,也会影响网站。

济南文汇传媒根据公司建议,整理相应的主要错误页面,提交死链接,自定义404页面的处理,彻底解决问题,而不是回避问题。

5、 robots 设置中的“*”和“$”设置,其中“$”匹配行尾字符。 “*”匹配 0 个或多个任意字符。

1.4套机器人.txt

先跳转到根目录cd~

使用 find -name robots.txt 查找所有名为 robots.txt 的位置

使用 vi ./www/server/phpmyadmin/phpmyadmin_d6c29777ac46669a/robots.txt 进行设置

同时把robots.txt文件复制到你页面的根目录下,这样就可以直接输入域名+robots.txt看正文

2020.5.5 补充:也可以直接从下面的链接生成robots.txt放在域名的根目录下,不用上面的操作。

这里可以看到我的服务器是不允许大家爬的。由于我的网站目前是个人学习网站,所以我会改变这种情况让大家爬。同时也可以被百度谷歌抓取到我的网站,方便收录在数据库中。也可以根据自己的需要进行设置。

我把所有的Disallows都改成了Allow(注意:首字母必须大写,这里我允许所有爬虫爬取学习使用)

附加说明:如果设置为Disallow:,则允许爬取,一定要加上/

Disallow: /wp-*.php 表示禁止搜索引擎抓取 WordPress 网站 根目录下以 wp 开头的文件。

User-agent:定义搜索引擎,其中*代表所有,Baiduspider代表百度蜘蛛,Googlebot代表谷歌蜘蛛。

也就是说User-agent:*表示定义所有蜘蛛,User-agent:Baiduspider表示定义百度蜘蛛。

目前如果使用爬虫爬取,会显示未找到该站点,未找到原因:(更新:找到原因,可以参考)

如果想设置的更具体,可以参考下面的格式(下面的格式禁止了大部分爬虫,如果允许,可以改为Allow,或者去掉/)

用户代理:BaiduspiderDisallow:/用户代理:GooglebotDisallow:/用户代理:Googlebot-MobileDisallow:/用户代理:Googlebot-ImageDisallow:/用户代理:Mediapartners-GoogleDisallow:/用户代理:Adsbot- GoogleDisallow: /User-agent:Feedfetcher-GoogleDisallow: /User-agent: Yahoo! SlurpDisallow:/用户代理:雅虎! Slurp ChinaDisallow: /User-agent: Yahoo!-AdCrawlerDisallow: /User-agent: YoudaoBotDisallow: /User-agent: SosospiderDisallow: /User-agent: Sogou spiderDisallow: /User-agent: Sogou web spiderDisallow: /User-agent: MSNBotDisallow : /User-agent: ia_archiverDisallow: /User-agent: Tomato BotDisallow: /User-agent: *Disallow : /

robots.txt 的语法:

a、User-agent:应用以下规则的机器人,如Googlebot、百度蜘蛛等

b、Disallow:要屏蔽的网址,不允许robots访问。

c,允许:允许的 URL

d, "*": 通配符匹配 0 个或多个任意字符。

e, "$": 匹配行结束符。

f, "#": 注释描述性文本,不需要写。

g,Googlebot:Google 搜索机器人(也称为搜索蜘蛛)。

h,Baiduspider:百度搜索机器人(也叫搜索蜘蛛)。

i、目录和 URL 的措辞:都以正斜杠 (/) 开头。如:

1.设置Robots.txt的5个注意事项

在编写robots.txt文件时,必须使用正确的语法。 User-agent、Disallow、Allow、Sitemap这几个词的首字母大写,后面的字母小写,后面必须跟一个英文空格。

网站上线前记得写robots.txt文件,禁止蜘蛛访问网站。不知道怎么写的请在写之前先了解一下,以免给网站收录带来不必要的麻烦。

robots.txt 文件的生效时间在几天到一个月之间,这是站长无法控制的。但是站长可以在百度统计中查看网站robots.txt文件是否有效。

1.6检查是否为收录

1.7 手动提交网站

链接提交工具是网站主动推送数据搜索的工具,可以缩短爬虫发现网站链接的时间,网站时间敏感的内容推荐给使用链接提交工具推送实时数据搜索。该工具可以加快爬虫的爬行速度,不能解决网站内容是否收录问题

百度:%3A%2F%

2 其他增加曝光率的方法

创建原创 内容。如果你想从搜索引擎获得流量,你应该把所有的时间都集中在一件事情上,努力添加原创的内容。这是谷歌和公司最看重的。内容越多原创,更新越频繁,效果越好。

建立反向链接。如果您想提高搜索排名并获得自然流量,第二重要的事情就是建立反向链接。您需要有尽可能多的 网站 链接到您的 网站。链接的权威性和相关性越高,效果越好。例如,如果您有一个技术博客,从 TechCrunch 或其他权威技术博客获取链接将对 SEO 产生奇迹般的影响。

实施 关键词 研究。搜索引擎围绕 关键词 工作,了解人们使用 关键词 调整内容以匹配它的内容。比如关键词“搞笑图片”的搜索量是“搞笑图片”的15倍,所以在标题中使用“搞笑图片”更有帮助。使用 Google AdWords关键词 工具查询 关键词 的任何搜索量。

优化页面标题。网页标题是指网页的标题部分,位于HTML代码头部的标签之间,在访问网页时出现在浏览器顶部的标题栏中。这是一个非常重要的页面搜索引擎优化因素。需要确认的是网站每个页面都有一个唯一的页面标题,并且关键词应该出现在里面。 WordPress 用户可以安装 All in One SEO Pack 插件以自动实施。

创建一个 HTML网站 地图。 HTML 网站 地图是链接到所有其他页面的网页(最好也链接到所有其他页面)。 HTML 网站 地图帮助搜索引擎抓取和索引 网站 以提高搜索排名。

使用图片。大多数站长都忘记了谷歌有一个非常流行的“图片搜索”,这意味着在网页中使用图片也可以增加来自搜索引擎的流量。一定要使用相关的关键词来优化图片的名称,记得经常使用图片中的ALT和TITLE属性。在 网站sxc.hu.

上可以找到数以千计的无版权图片。

翻译网站的内容。根据网站的主题,将网站翻译成其他语言的网页可能会在搜索引擎中获得翻倍的流量。为了实现这一目标,还需要一个插件,使搜索引擎能够索引翻译的网页。 WordPres 用户可以使用此全局翻译器。

3 优化自己的服务器

目的:防止他人无法访问,或者百度谷歌爬虫无法抓取自己的网站。

我个人认为非企业用户没有必要设置反盗链,除非访问量巨大,服务器无法承受,或者被恶意攻击,导致其他人无法访问但是新创建的网站的访问量基本上是很少的,即使有盗链也不会有太大影响。

宝塔防盗链方法:

以下是其他视觉上可行的解决方案。由于我没有设置,所以我不列出我自己的过程。

相关说明可以跳转到3.1

Nginx 配置方法防盗

主要使用valid_referers命令来防止盗链,比如防止未经授权的网站盗链图片、文件等

因为HTTPReferer头信息可以被程序伪装生成,所以通过Referer信息的反盗链不是100%可靠,但可以限制大部分热链

指令“valid_referers”的语法:

valid_referers [none|blocked|server_names] ...

默认值:无

使用环境:服务器、位置

该命令将根据 Referer Header 的内容为变量 $invalid_referer 赋值 0 或 1。

如果 RefererHeader 标头与 valid_referers 指令设置的有效 Referer 不匹配,则变量 $invalid_referer

将设置为 1.

该指令的参数可以如下:

none:表示没有Referer值。

blocked:表示Referer值被防火墙伪装。

server_names:代表一个或多个主机名。从 Nginx0.5. 33 版本开始,server_names 中可以使用通配符“*”。

示例演示:

修改nginx.conf:

位置 ~ .*.(gif|jpg|jpeg|png|bmp|swf)$

其中,"gif|jpg|jpeg|png|bmp|swf"设置防盗文件类型,自行修改,每个后缀用"|"分隔符号!

valid_referers 没有被阻止 *.;

就是白名单,可以让文件链接的域名白名单自己修改成你的域名! *.这里指的是子域名,域名和域名之间用空格隔开!

重写^/;

这张图片是hotlink返回的图片,用来替换所有hotlink网站的图片。这张图应该放在没有防盗链的网站上。因为有防盗链功能,如果这张图片也放在防盗链网站上,就会显示为防盗链,无法显示。 网站 的链接图片将显示 X 符号。

这个设置几乎可以起到防蚂蟥的作用,如上所述,这还不是真正的防蚂蟥的完整实现!

我们看第三行:valid_referers中的“noneblocked”,我们把“noneblocked”删掉,改成如下配置:

这样如果在浏览器中直接输入图片地址,图片将不再显示,无法右键另存为。

第五行:

重写^/

这是为图片防盗链设置的防盗链返回图片。

如果文件还需要防盗链下载,放第五行:

重写^/

改为链接,可以是你主站的链接,例如将第五行改为:

重写 ^/ ;

这样,当有人输入文件下载地址时,由于防盗链下载的效果,他们会跳转到您设置的链接!

最后重启nginx生效!

4.学习中遇到的名词3.1 hacking

“盗链”的定义是:这个内容不在自己的服务器上,通过技术手段绕过了最后一个别人的广告有利的页面,直接在自己的页面上提供给最终用户广告和利润。内容。经常鲜为人知的网站盗取一些强大的网站的地址(比如一些音乐、图片、软件的下载地址),放到自己的网站中,这样一来,大网站的空间和流量被盗。

为什么会有盗链

一般浏览的一个重要现象是,一个完整的页面并不是一下子传给客户端的。如果请求的是一个有很多图片等信息的页面,那么第一个Http请求发回这个页面的文本,然后通过客户端的浏览器来执行这个文本的解释,发现还有Image ,那么客户端的浏览器会再发送一次Http请求。当请求处理完毕后,图片文件会被发送到客户端,然后浏览器会将图片放置在页面的正确位置,这就是一个完整的页面。发送多个 Http 请求后也许可以完整显示。基于这种机制,就会出现一个问题,就是盗链问题:如果网站中页面中没有提到的信息,比如图片信息,那么就可以把图片完全连接到另一个网站。这样,没有任何资源的网站利用其他网站的资源展示给观众,增加了他们的访问量,但大多数观众不会轻易找到。显然,对于使用了资源的网站是不公平的。一些不受欢迎的网站为了不增加成本而扩展自己的网站内容,经常盗取其他网站的链接。一方面损害了原网站的合法利益,另一方面增加了服务器的负担。

注:图片记录了存储地址,通过这个存储地址找到第一台服务器,所以不占用自己的资源,是既得利益者。

3.2 网站地图

Sitemap(英文:Sitemap)描述了一个网站的结构。它可以是任何形式的文档,用作网页设计的设计工具,也可以是将网站中的所有页面列出的网页,通常采用分层形式。这有助于访问者和搜索引擎爬虫找到 网站 中的页面。

网站地图的好处:

网站 地图有利于改善用户体验:它们为 网站 访问者提供路线,并帮助丢失的访问者找到他们想要查看的页面。对于 SEO 来说,网站地图的好处更多:

为搜索引擎爬虫提供可以浏览整个网站的链接;向搜索引擎爬虫提供指向动态页面或其他方法难以到达的页面的链接;如果访问者尝试访问 网站 如果该 URL 在域中不存在,则访问者将被重定向到“找不到文件”的错误页面,并且可以将 网站 映射用作页面的“准”内容。

3.3 爬取和反爬取策略

3.4PPC,PPC推广

PPC是英文Pay Per Click的缩写,其中文字表示按点击付费广告,也称竞价排名或关键词广告。按点击付费广告是大公司最常用的在线广告形式。这种方法价格昂贵,但效果也很好。如百度推广、搜狐、新浪首页横幅广告等。这种形式的广告收费如下:起始价格 + 点击次数 x 每次点击价格。越有名气的搜索引擎,起拍价就越高,高达几万甚至几十万。而每次点击的价格在0.30元左右。提供按点击付费的网站有很多,主要包括各大门户网站网站(如搜狐、新浪)、搜索引擎(谷歌和百度),以及其他较大的网站页面浏览量。

我们常说的PPC是指搜索引擎营销中的PPC推广。 PPC(Pay-Per-Click)搜索引擎营销也称为PFP(Pay-For-Performance:Pay-For-Performance),它基于一种在线广告定价模型,其中点击广告或电子邮件的用户数消息付费。 PPC广告服务的最大特点是客户只需为实际访问付费。也就是说,只有当客户的网站广告链接被实际点击时,才会产生成本。因此,保证了访问的高度针对性。

PPC广告服务的第二个特点是网站排名的可控性,即客户可以通过调整点击付费价格来控制自己在特定关键词的搜索结果中的网站排名。

同时,PPC 搜索引擎搜索结果的前 3 到 5 页经常被其搜索合作伙伴网站引用。例如,Overture广告服务前三个客户的网站也会同时出现在MSN、雅虎等知名网站的首页。

另外,与一些大型搜索引擎的付费收录服务和整版广告相比,PPC广告的成本相对较低。因此,这项服务可以说是一种既可以为网站带来目标访问量,又可以规避投资风险的有效方式。其缺点是:对于一些中小型企业来说,成本还是偏高,管理难度大。

参考:

如何正确设置和使用robots.txt文件

如何设置网站的robots.txt

Notes-Crawler-robots.txt

什么是 PPC,什么是 PPC 推广?

增加网站流量

的100种方法