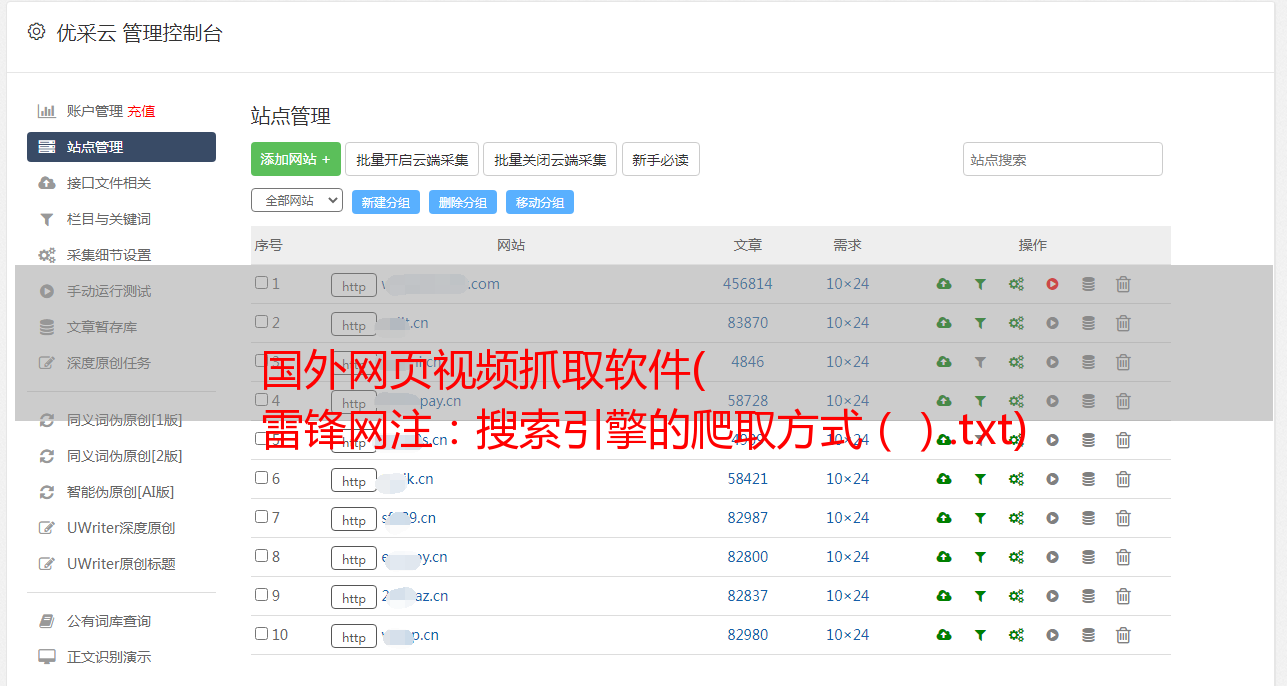

国外网页视频抓取软件( 雷锋网注:搜索引擎的爬取方式().txt)

优采云 发布时间: 2021-12-27 22:01国外网页视频抓取软件(

雷锋网注:搜索引擎的爬取方式().txt)

雷锋网消息。7月1日,谷歌在其博客上发布了一条重要消息。它宣布谷歌开源了存储robots.text解析器的C++库,以推动REP(Robots Exclusion Protocol,也称为爬虫协议,robots Protocol)成为互联网标准。

1994年,荷兰软件工程师Martijin Koster提出了REP的概念,它使用robots.txt文件来隐藏一些信息不被搜索引擎抓取。比如只抓取应该抓取的页面;阻止某些网站中的较大文件;屏蔽一些无效链接;对敏感信息保密等。

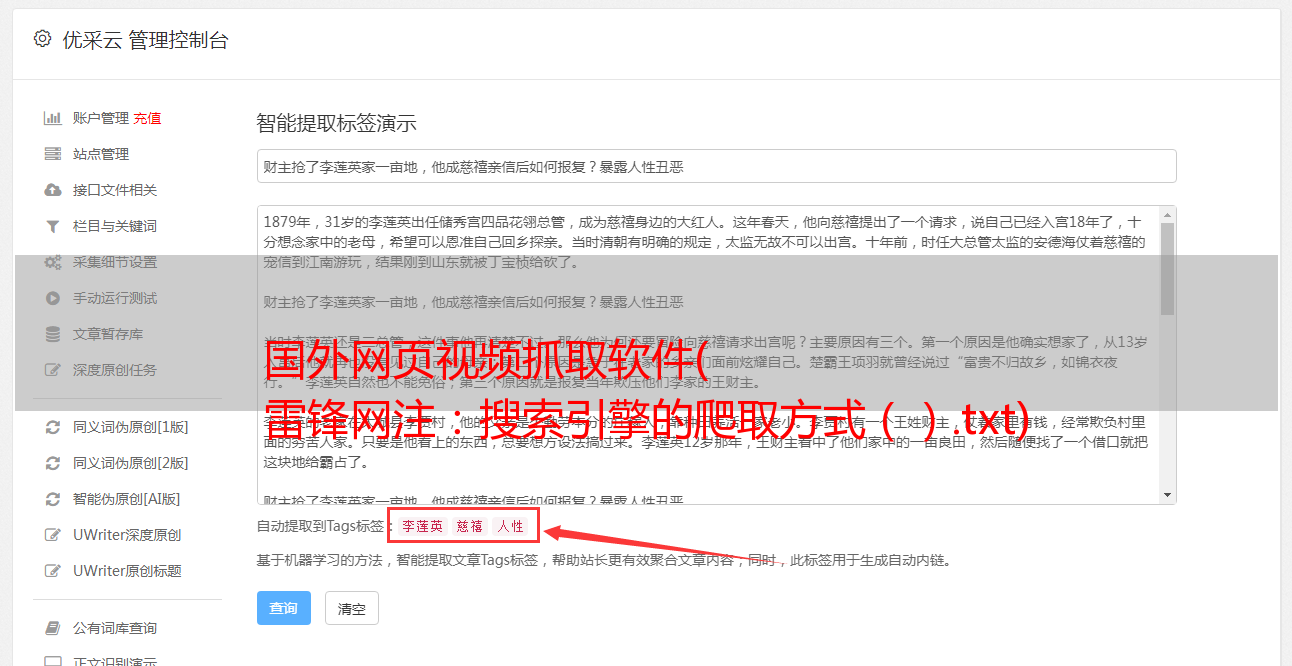

雷锋网注:搜索引擎的抓取方式(图片来自百度百科)

我们可以这样理解。该网站就像一个房间。robots.txt文件是主人挂在房间门上的“请勿打扰”提醒。它可以让人在一些存放贵重物品的房间停下来,但它毕竟不是一个看门人。人们无法阻止恶意的窃贼。

联合提交提案

二十五年过去了,业界已经完全认可 REP,但现在它更像是一种道德规范,而不是非官方的互联网标准。

然而,谷歌正在努力改变这种现状。谷歌在博客中说,

我们希望帮助网站所有者和开发者在互联网上创造惊人的体验,而不是担心如何控制爬虫。谷歌和该协议的发起者,以及其他网络管理员和搜索引擎,共同起草了一份关于如何在现代网络上应用 REP 的提案,并已提交给 IETF(雷锋网出版社:Internet Engineering Task Force,非- 盈利的互联网开放标准组织,负责自愿性互联网标准的开发和推广)。

Google 的提案反映了 Googlebot 和一些主要网络爬虫 20 多年的实际经验,以及大约 5 亿个依赖 REP 的网站应用 robots.txt 的实际经验,并在现代网络层面进行了扩展,定义了所有robots.txt 解析和匹配。之前未定义的场景:

开源 robots.txt 解析器

除了联合多方向IETF提交提案外,谷歌还做出了其他努力,开源了自己的robots.txt文件库,以创建标准化的语法来创建和解析文件并消除所有混淆。

谷歌在博客中说:

REP是网络最基本、最关键的组成部分之一,但它只是一种约定俗成的标准,难免让人感到沮丧;这给网络管理员和爬虫工具开发者带来了麻烦……推动REP成为行业标准非常重要,因为它符合每个人的利益。但是,对于解析robots.txt文件的开发者来说,这种标准化需要付出更大的努力。因此,我们开源了收录

robots.txt 解析器的 C++ 库。

据说这个 C++ 库已经存在了 20 年,其中收录

自 1990 年代以来编写的代码片段。在过去的20年里,该库经历了不断的发展,已经涵盖了许多编写robots.txt文件的实际案例,对于想要构建自己的解析器的开发者来说非常有帮助。

此外,谷歌还在开源软件包中加入了测试工具,帮助作者测试robots.txt的效果。

外在态度

谷歌开源robots.txt后,这个话题引起了广泛关注,甚至登上了Hacker News的榜首。

Constellation Research(雷锋网:专注于数字化转型和颠覆性技术的技术研究和咨询)分析师霍尔格·穆勒告诉SiliconANGLE,标准化对于互联网的正常运行至关重要。很高兴看到 Google 在 REP 中的基本工作。带头做事。

Holger Mueller 还补充道,

与任何开源倡议和标准化尝试一样,我们仍然需要等待这一举措最终是否会成功,以及我们可以从中学到什么。这是一个值得密切关注的领域。

在中国,网友们也高呼“谷人西”(雷锋网:“谷歌,人类的希望”)表达对事件的感谢。