[其他]最新开源的网站URL手动采集软件发布[search-url]

优采云 发布时间: 2020-08-04 09:02刚写一个Python的URL采集程序,可以采集最新的百度。立马给诸位大婶贡献下来!

已经在GITHUB开源,项目地址:

有帐号的,欢迎点击star赞一下

软件简介:

根据关键词,自动从搜索引擎采集相关网站的真实地址与标题,并且可以手动保存为文件,自动消除重复URL。同时,也可以自定义忽视多条域名。最新百度采集通过,测试时间2017-08-03

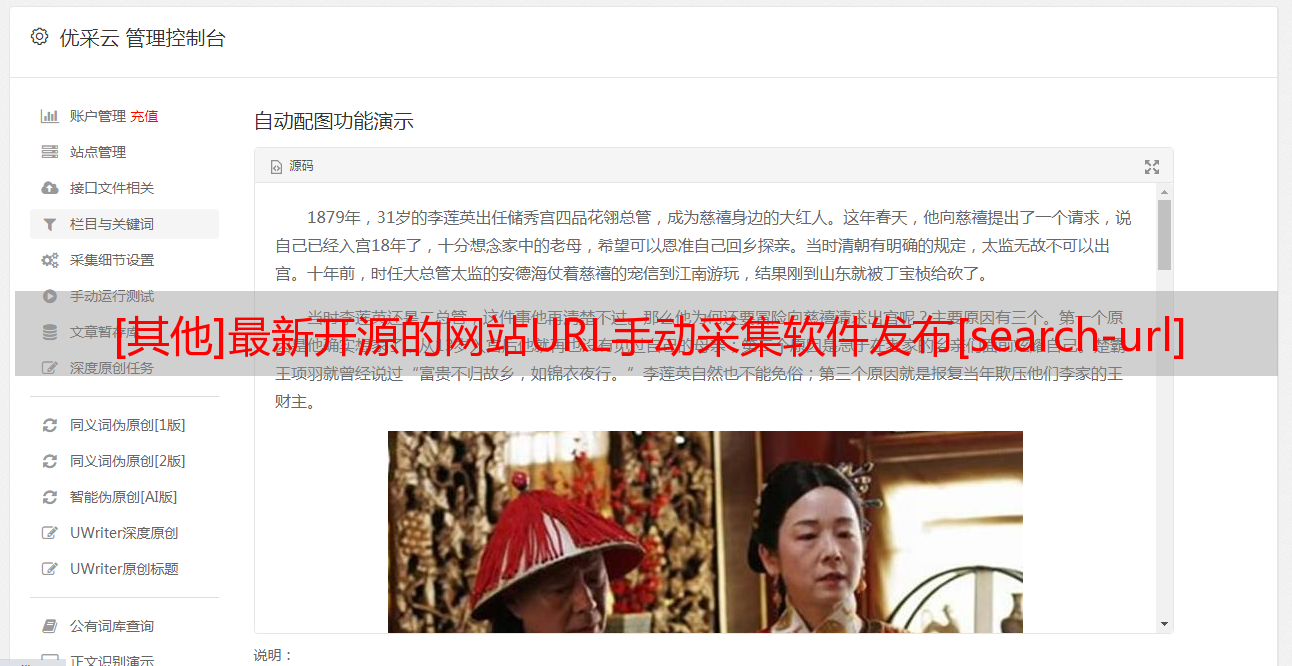

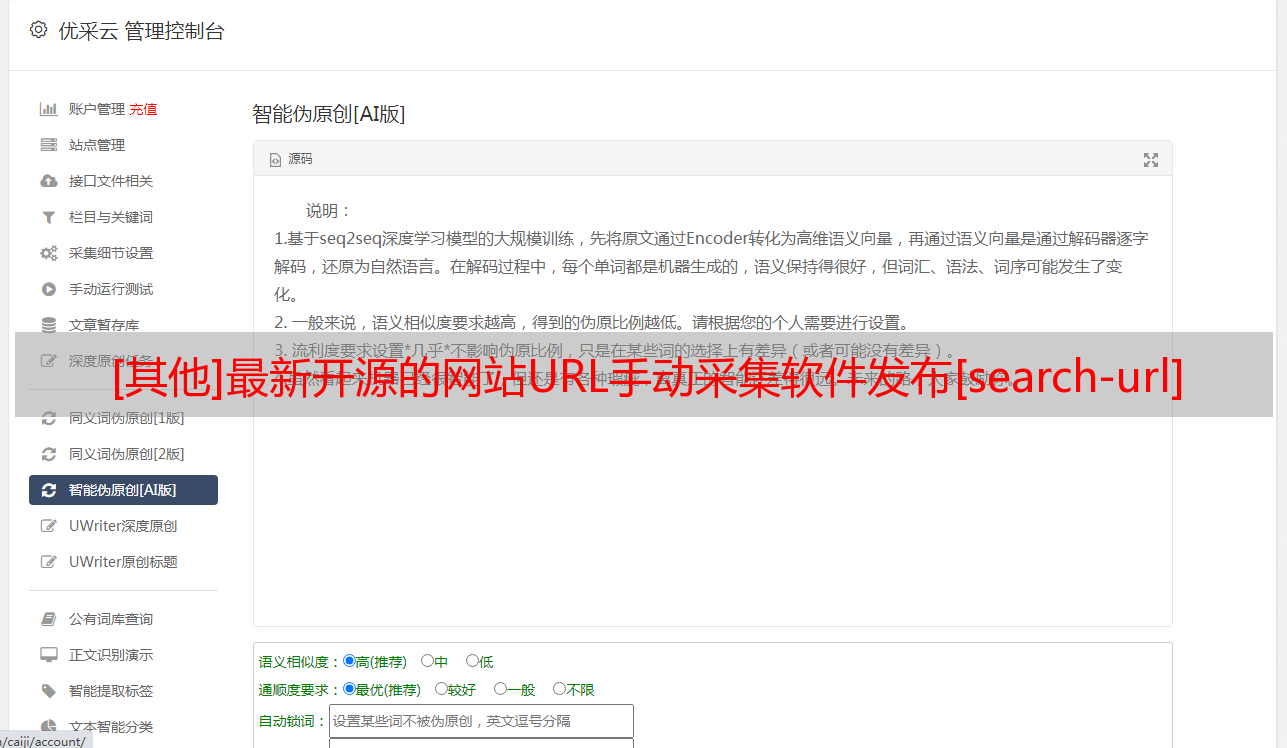

运行截图:

使用说明

程序主要运用于安全渗透测试项目,以及批量评估各种CMS系统0DAY漏洞的影响程度,同时也是批量采集自己获取感兴趣的网站的一个小程序~~

测试环境为 Python 2.7.x 如果须要python3版本的,可以自行更改,或者我的博客留言

目前只可以采集百度搜索引擎的结果。并且每页默认显示50条记录。可自定义输入要采集的页数。

如果要采集关键词为“hacker”的相关网站,采集百度结果的前3页,则输入如下:

please input keyword:hacker

Search Number of pages:3

程序特征

1:获取到的是百度搜索结果的真实URL地址

2:可以忽视不需要的常见网站,如忽视百度翻译,等等所有百度相关结果,给字段添加即可。程序早已默认忽视了好多条啦,如

filter_array1 = ['','','','','','','','','']

filter_array2 = ['','','']

filter_array3 = ['','','','','','','','','']

filter_array4 = ['','','','']

filter_array5 = ['','','','']

3:实时显示采集到的网页的【真实URL】以及【标题】。前面的【ID】对应的是当前页百度结果的第X条数据

4:自动保存结果到当前目录的txt文件,文件名为搜索的 关键词.txt 为了便捷导出到其他工具,txt文件上面只记录了采集的网址。如果须要同时记录标题,把代码中的注释删掉即可

5:自动消除重复记录

6:统计总采集条数(143 found),有效的条数(91 checked),被过滤的条数(52 filter),以及被过滤的重复的URL条数(9 delete)

7:开源,任何人都可以下载使用。由于本人能力有限,如果有好的建议以及更改,也希望能一起建立

8:跨平台,并且无捆绑侧门风险。以前网上有的百度URL采集软件大部分为WINDOWS下的可执行文件,并且现今百度更新后未能正常采集。

9:程序会不断更新

关于更新

由于时间匆忙网站自动采集发布,没有做优化。很多自定义参数也采用了默认值,下一个版本加上自定义参数

后免将相继添加Bing搜索引擎,goole引擎的采集功能,与百度的进行一个合并。如果需求提升网站自动采集发布,也降低多线程或则多进程扫描

如果百度更新造成采集不到内容,可以在我的博客留言联系我进行更改