搜索引擎禁止的方式优化网站(给出一个能有效禁止百度等搜索引擎收录的解决方案方法 )

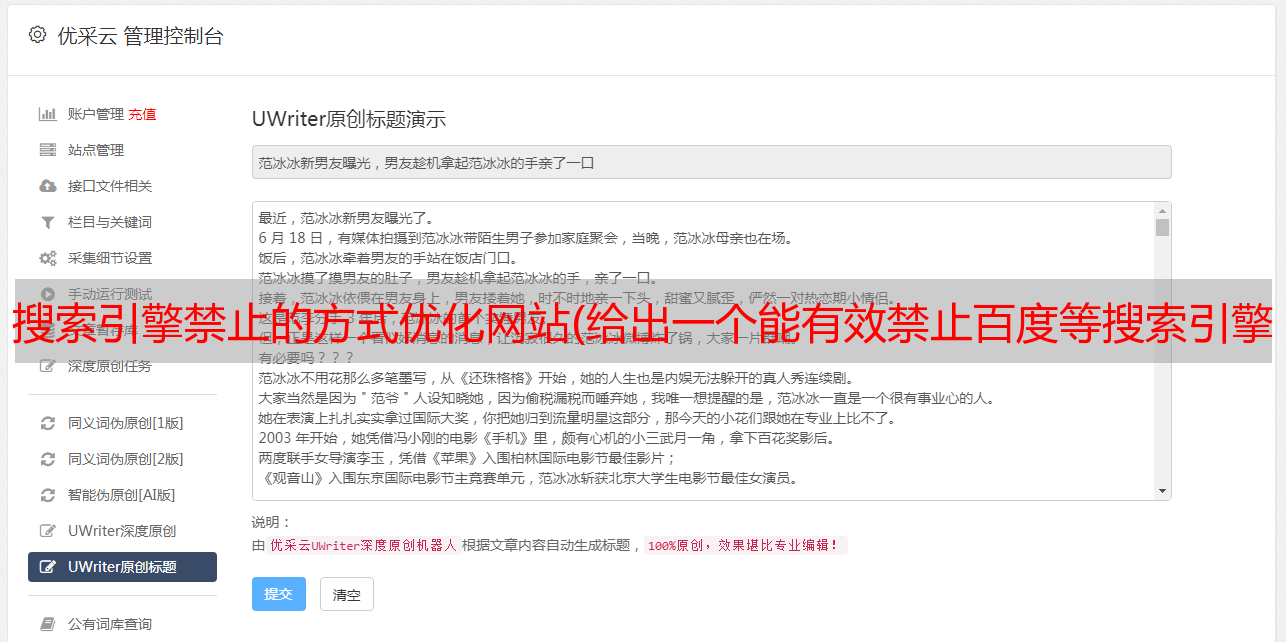

优采云 发布时间: 2021-12-26 12:03搜索引擎禁止的方式优化网站(给出一个能有效禁止百度等搜索引擎收录的解决方案方法

)

注意:虽然建站的目的大部分是为了优化搜索引擎排名,实现网络营销,但在特殊情况下,还是会有“不希望被搜索引擎收录”的需要,比如创建一个内容和主站由于某种原因几乎相同的副站,但由于内容高度相似,百度的关键词部分排名给了副站,影响了主站的排名。这时候就需要切断百度的收录。这里有一个可以有效禁止百度等搜索引擎收录的解决方案。

一、Robots.txt 只能禁止抓取,不能收录

很多人认为在robots.txt中禁止百度蜘蛛爬行就相当于禁止收录。这是一个严重的误解。

二、 通过Nginx判断user_agent禁止访问百度等搜索引擎,实现禁止收录

既然不能直接禁止爬行,那就干脆禁止访问百度蜘蛛等搜索引擎。这个想法是确定user_agent。如果是百度蜘蛛或者谷歌机器人等搜索引擎的user_agent,返回403或者404,这样百度等搜索引擎会认为这个网站打不开或者不存在,所以自然不会被收录。

其实之前我写过一篇类似的文章《Apache/Nginx/PHP 屏蔽UA爬虫的方法》,大家可以参考一下。

这里Nginx配置代码如下:

if ($http_user_agent ~* "qihoobot|Baiduspider|Googlebot|Googlebot-Mobile|Googlebot-Image|Mediapartners-Google|Adsbot-Google|Feedfetcher-Google|Yahoo! Slurp|Yahoo! Slurp China|YoudaoBot|Sosospider|Sogou spider|Sogou web spider|MSNBot|ia_archiver|Tomato Bot")

{

return 403;

}

我用curl模拟搜索引擎爬行,测试了上面代码的有效性,在很多项目实践中验证了这个方法的可行性,实现了完全禁止百度收录!

#模拟百度搜索引擎

curl --user-agent "Mozilla/5.0 (compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html)" http://**.**.com

#模拟谷歌

curl --user-agent "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)" http://**.**.com