chrome抓取网页插件( Python使用Chrome插件实现爬虫,文中通过示例代码介绍)

优采云 发布时间: 2021-12-26 11:25chrome抓取网页插件(

Python使用Chrome插件实现爬虫,文中通过示例代码介绍)

Python使用Chrome插件实现爬取流程图

更新时间:2020-06-09 12:07:13 作者:Johnthegreat

本文主要介绍Python使用Chrome插件实现爬虫。文章中介绍的示例代码非常详细。对大家的学习或工作有一定的参考学习价值。有需要的朋友可以参考

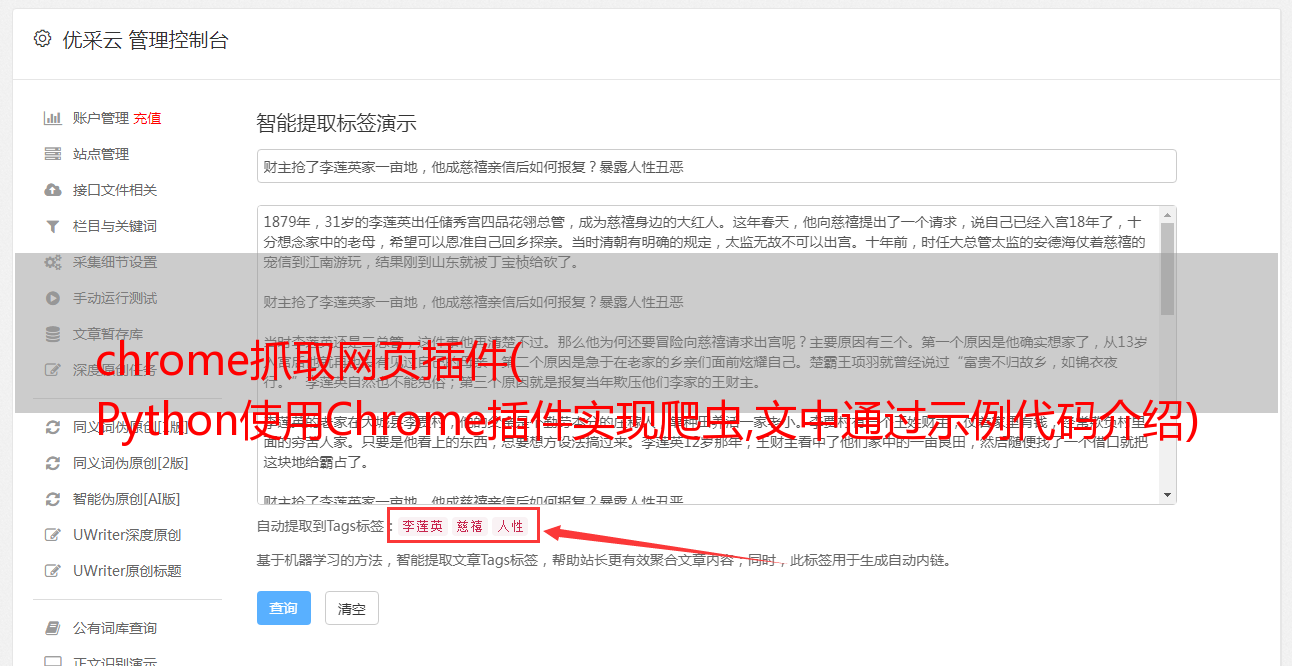

做电商的时候,消费者对产品的评论很重要,但是如果你不会写代码怎么办?这里有一个Chrome插件,不用写一行代码就可以做简单的数据爬取。下面显示了一些捕获的数据:

可以看到抓取到的地址、评论者、评论内容、时间、商品颜色都被抓取了。那么,需要哪些工具来抓取这些数据呢?就两个:

1. Chrome 浏览器;

2. 插件:Web Scraper

插件下载地址:

最后,如果你想自己抢,这里是这个抢的详细过程:

1. 首先复制以下代码。是的,您不需要编写代码。但是为了开始,仍然需要复制代码。以后可以自己定制选择,不用写代码。

{

"_id": "jdreview",

"startUrl": [

"https://item.jd.com/100000680365.html#comment"

],

"selectors": [

{

"id": "user",

"type": "SelectorText",

"selector": "div.user-info",

"parentSelectors": [

"main"

],

"multiple": false,

"regex": "",

"delay": 0

},

{

"id": "comments",

"type": "SelectorText",

"selector": "div.comment-column > p.comment-con",

"parentSelectors": [

"main"

],

"multiple": false,

"regex": "",

"delay": 0

},

{

"id": "time",

"type": "SelectorText",

"selector": "div.comment-message:nth-of-type(5) span:nth-of-type(4), div.order-info span:nth-of-type(4)",

"parentSelectors": [

"main"

],

"multiple": false,

"regex": "",

"delay": "0"

},

{

"id": "color",

"type": "SelectorText",

"selector": "div.order-info span:nth-of-type(1)",

"parentSelectors": [

"main"

],

"multiple": false,

"regex": "",

"delay": 0

},

{

"id": "main",

"type": "SelectorElementClick",

"selector": "div.comment-item",

"parentSelectors": [

"_root"

],

"multiple": true,

"delay": "10000",

"clickElementSelector": "div.com-table-footer a.ui-pager-next",

"clickType": "clickMore",

"discardInitialElements": false,

"clickElementUniquenessType": "uniqueHTMLText"

}

]

}

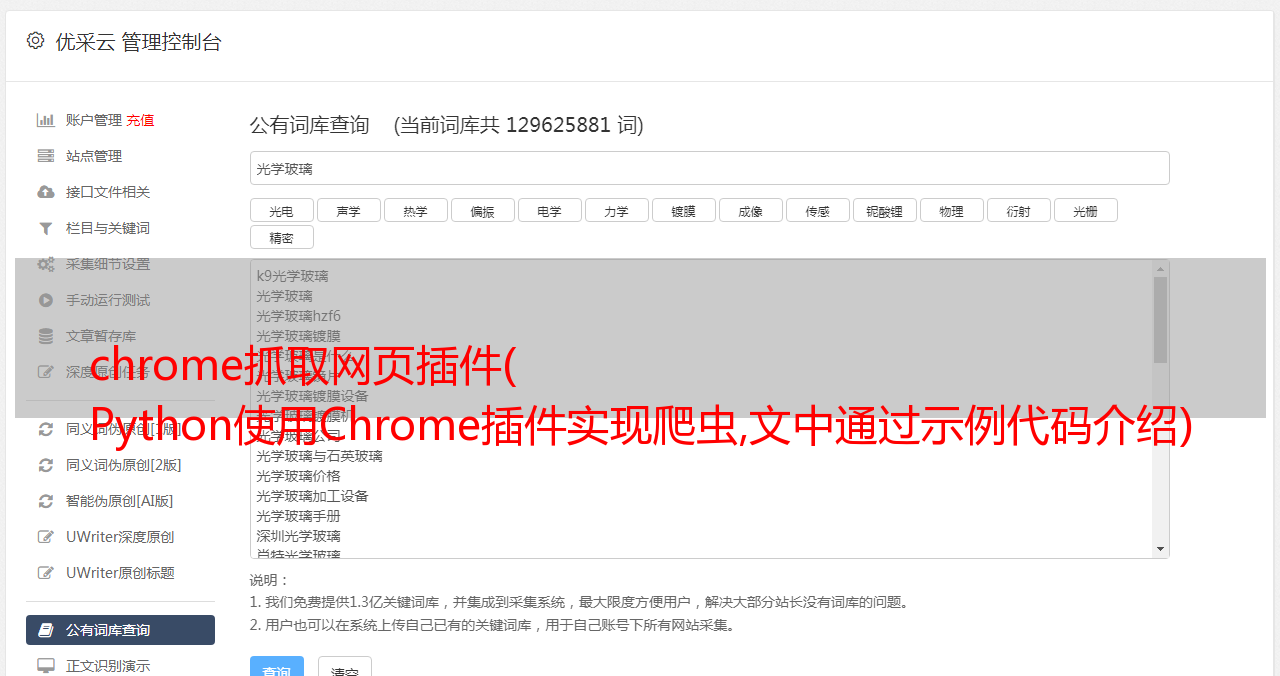

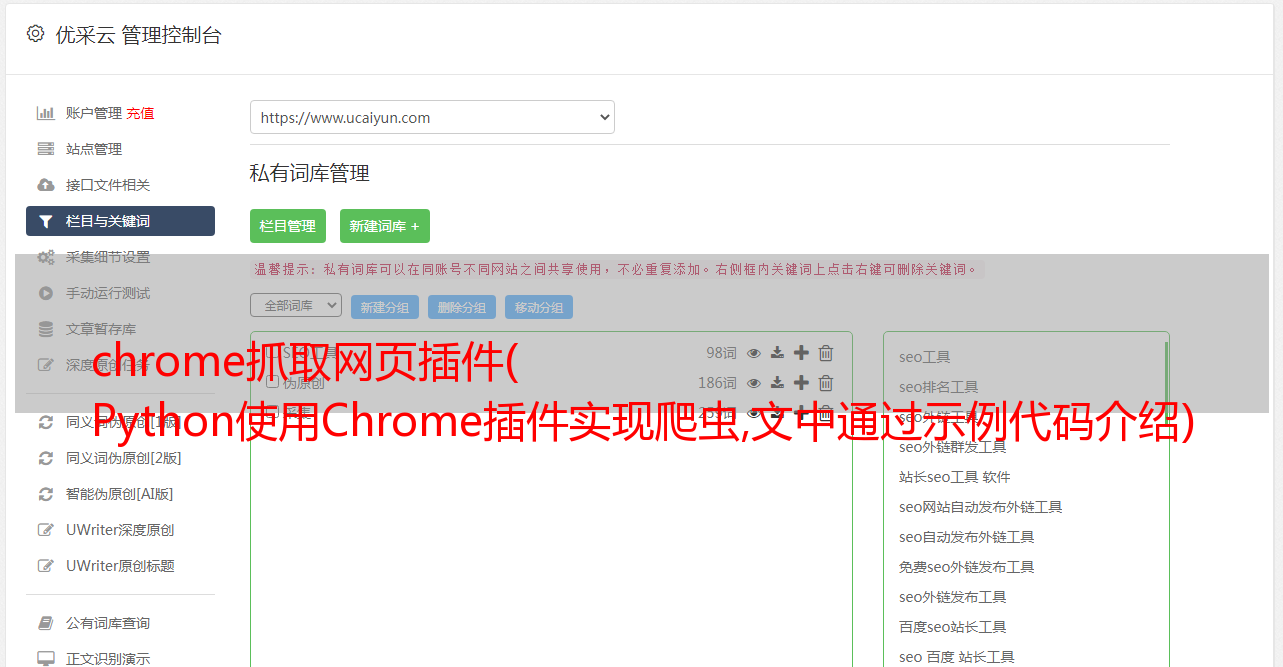

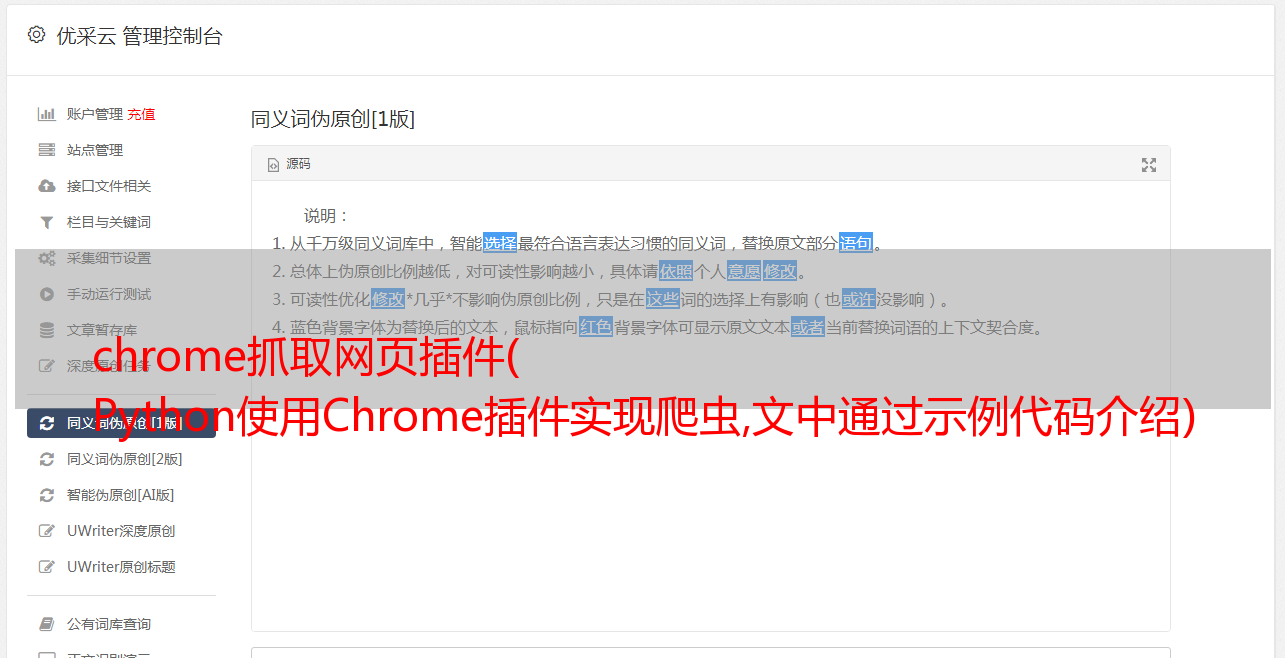

2. 然后打开chrome浏览器,在任意页面同时按下Ctrl+Shift+i,在弹出的窗口中找到Web Scraper,如下:

3. 如下

4. 如图,粘贴上面的代码:

5. 如图,如果需要自定义URL,注意替换。URL 后面的#comment 是评论的链接,不能删除:

6. 如图:

7. 如图:

8. 如图,点击Scrape后会自动运行打开需要抓取的页面。不要关闭窗口,安静地等待完成。完成后,右下角会提示完成。一般1000以内的评论不会有问题:

9. 最后点击下载到电脑,数据就保存了。

使用此工具的好处是:

1. 无需编程;

2. 京东的评论基本可以用这个脚本,修改对应的url即可;

3. 如果需要抓取的评论少于1000条,这个工具会很好,所有数据都会自动下载;

使用注意事项:

1. 一次捕获的数据会被记录下来,如果立即再次捕获将不会保存。建议关闭浏览器重新打开再试;

2. 抓取次数:1000以内没有问题,可能是京东直接根据IP屏蔽了更多的抓取;

如果你的英文水平不错,可以尝试阅读官方文档,进一步学习定制自己的爬虫。

官方教程:

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持脚本屋。