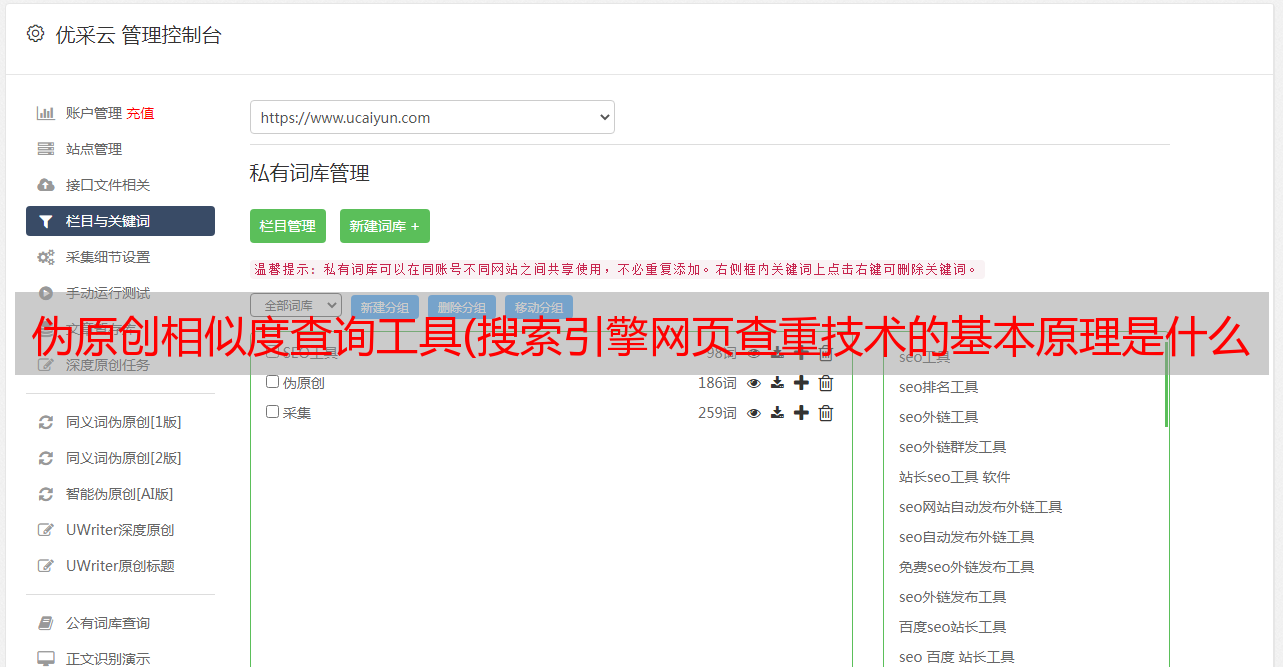

伪原创相似度查询工具(搜索引擎网页查重技术的基本原理是什么?怎么处理?)

优采云 发布时间: 2021-12-24 16:24伪原创相似度查询工具(搜索引擎网页查重技术的基本原理是什么?怎么处理?)

在搜索引擎的众多算法中,有一种网页重复检查技术。首先说一下这个“重”,其实很简单,就是重复内容。我们经常在网上看到文章具有相同的标题或内容,一些最新的新闻或关注度较高的文章会被很多新闻媒体转发网站。这其实对用户是有好处的,让用户尽可能多的看到这个文章或者新闻。但是搜索引擎有点郁闷,为什么呢?获取两篇或多篇内容相同的文章意味着搜索引擎将花费更多时间多次处理相同的文章 内容。在搜索引擎索引库中,可能会索引同一网页的两个副本。

那么如何处理以上问题呢?这就是网页重复检查技术的出现。搜索引擎将相同的内容和格式组合成四种相似的网页类型,分别是:1、两个网页的内容和格式完全相同;2、 两个网页的内容和格式是一样的,只是格式不同。;3、这两个网页有些重要的内容一样,格式也一样;4、这两个网页有一些重要的内容相同,但格式不同。

这是一个Shingle算法。简单来说,这个算法的意思是:一个长度为L的文档,每N个汉字取一个Shingle(瓦片的意思),这样一共截取了L-N+1个Shingle。比较两个文章截取的Shingle,检查同一个Shingle的个数,然后除以两个文档的Shingle总数,再减去相同的Shingle数。计算出的结果称为Jaccard系数,用于判断文章的相似度。当搜索引擎中的相似度达到0.2时,判断两篇文章文章相似。

判断文章的相似度后,还有一个去重操作,就是去除重复的内容。现在搜索引擎减重的方式是保留最先被搜索引擎蜘蛛抓取的内容。

从上面的搜索引擎算法中可以很容易地得出一些想法,这就是伪原创的想法。不详述,搜索引擎算法不断更新。如今,搜索引擎可以轻松检查更详细、重复的内容和低质量的内容。

如果你还在为如何划分Shingle而苦恼,请看下图。

提取特征图的Shingle算法