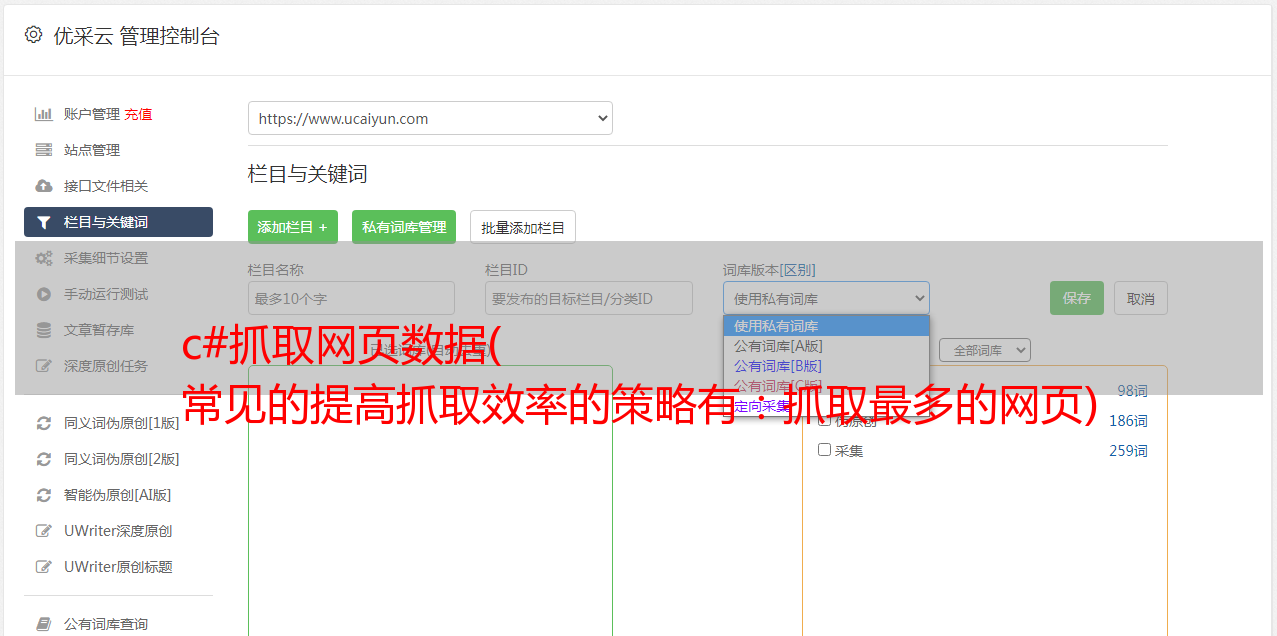

c#抓取网页数据( 常见的提高抓取效率的策略有:抓取最多的网页)

优采云 发布时间: 2021-12-22 02:24c#抓取网页数据(

常见的提高抓取效率的策略有:抓取最多的网页)

Spider是整个搜索引擎系统中非常重要的一部分,可以说是搜索引擎的基础。它不仅为搜索引擎提供了海量数据的搜索对象,更重要的是,它使搜索引擎从一个检索工具上升为一个信息集成平台。

爬行效率

爬行的效率与计算机硬件的性能、硬件的数量、网络的带宽有关。但是,为了提高爬取效率,不能一味地增加硬件,而是利用有限的硬件资源,在一定时间内抓取最多。网页。

提高爬取效率的常用策略有:

(1) 多线程并发爬取

(2) 单线程、非阻塞 i/o 获取

(3)分布式爬取,爬取工作分布到多台服务器来完成。对于google等搜索引擎,还包括地域分布,将爬取服务器集群分布到全球各个国家的骨干网。挑选。

爬行质量

蜘蛛设计的目标不是捕获互联网上的所有网页,而是捕获最重要和最新的网页。

如何抓取高质量的网页?哪些网页质量更高?这里要求设计师对互联网和用户的使用习惯和常识有一定的了解。

从整个互联网的角度来看,网站中各个网页之间的链接关系是一个非常重要的资源。因此,在抓取网页时应记录网页之间的链接关系进行链接分析,从而通过链接关系来评价网页的质量。

爬行的礼貌问题

礼貌爬取具体表现在:网站不爬取未爬取的网页,控制访问网站的频率。蜘蛛的爬行行为不应影响正常用户的访问。因此,蜘蛛必须:

(1)限制单位时间内爬取的网页数量为一个网站。

(2)限制可以同时爬取到同一个网站的线程/进程数。

(3)控制捕获相同网站的时间间隔。

(4)遵循robots、meta tag、sitemap.htm协议,不允许的目录不要访问。

(5)在抓取网页时发送的请求中,user-agent和form字段用于识别蜘蛛的身份,联系邮箱,以及spdier防范页面的url。

避免重复爬行

重复爬取的原因是:

(1)网上有很多网络

该页面被其他网页引用,使得同一个网页的URL出现在多个不同的网页中,这就需要蜘蛛具备URL去重功能。

(2)网页被其他网页转载,导致同一篇文章文章出现在不同url的页面中,这就需要蜘蛛具备内容去重功能,目前实现难度较大,目前有很多搜索引擎公司并没有很好地解决这个问题。

(3)网页的URL有多种表示,是dns和ip的对应关系造成的。

爬取数据的更新

更新爬取数据的问题是一个非常重要的问题。它决定了用户是否可以立即搜索到最新的新闻和最新的内容。但是由于互联网上的网页数量众多,一次爬取的周期很长。每次都重新爬一次更新,更新周期势必很长。

蜘蛛抓取的网页可能会被修改或删除。Spider会定期检查这些网页的更新状态,同时更新原创网页数据库、提取数据库和索引数据库。

6.内容提取

蜘蛛需要抓取的文件有很多种,比如html、xml网页、doc、ppt、xls、pdf等格式文档,以及图片、音频、视频等多媒体数据。对于这些不同类型的文件,蜘蛛必须提取文件中的纯文本内容。

对于doc、pdf等文件,专业厂商提供的软件生成的此类文件,厂商会提供相应的文本提取接口。

对于html和xml页面,除了title和body之外,还会有很多版权信息、广告链接、公众频道链接。这些链接与正文无关。在提取页面内容时,还需要过滤掉这些无用的链接。

以上就是代理IP服务器如何提高c#爬虫爬虫效率的相关介绍。Sun HTTP代理是专业的企业级优质代理IP供应平台,为大数据提供优质HTTP代理IP和Socks5代理IP采集提供服务。也可以联系客服免费试用!