c#抓取网页数据([DotnetSpider系列目录]为什么要造轮子同学们可以去各大招聘)

优采云 发布时间: 2021-12-07 23:28c#抓取网页数据([DotnetSpider系列目录]为什么要造轮子同学们可以去各大招聘)

【DotnetSpider系列目录】我们为什么要造轮子

同学们可以去各大招聘网站查看爬虫工程师的要求,大部分招聘JAVA、PYTHON,甚至NODEJS、C++;或者去开源中国查询C#爬虫项目,只有几个非常Simple或者几年没更新的项目。

与JAVA相比,纯性能方面,PYTHON并不处于劣势,而是在开发上具有优势(得益于世界上最强大的IDE)。爬虫性能瓶颈多在并发下载(网速)和IP池,为什么.NET没有强大的爬虫框架?老实说,我不知道。可能爬虫框架的核心比较简单,或者.NET的开发者没有其他语言的开发者勤奋,或者.NET的开源氛围没有其他语言的高。直到.NET即将发布开源版本的消息传出,我觉得是时候开发一个跨平台、跨语言的爬虫框架了。但一开始,我还挺紧张的。我觉得我还不够好,无法完全重新设计一个新框架。于是参考了JAVA的轻量级爬虫框架webmagic,加上自己的理解和改进。设计或文笔不好请指正海涵

框架设计

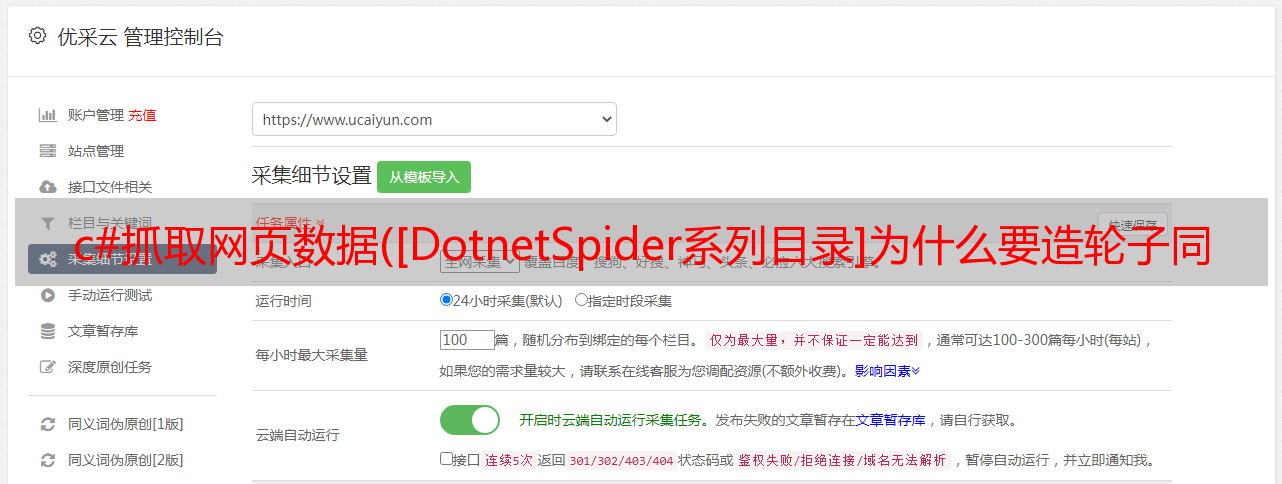

由于我指的是webmagic,所以整体架构没有大的变化。设计图如下(图片直接来自webmagic)

基本使用

基本使用只需要引用DotnetSpider2.Core(Nuget中获取)

DotnetSpider 需要 4 个模块来实现一个完整的爬虫:Scheduler、Downloader、PageProcessor 和 Pipeline。由于Downloader和Scheduler都有基本的实现,所以只需要实现PageProcessor和Pipeline就可以实现一个基本的爬虫。这种方式也是最自由的方式。

完整定制示例如下:

public static void Main(string[] args)

{

// Custmize processor and pipeline 完全自定义页面解析和数据管道

CustmizeProcessorAndPipeline();

Console.WriteLine("Press any key to continue...");

Console.Read();

}

public static void CustmizeProcessorAndPipeline()

{

// Config encoding, header, cookie, proxy etc... 定义采集的 Site 对象, 设置 Header、Cookie、代理等

var site = new Site { EncodingName = "UTF-8", RemoveOutboundLinks = true };

for (int i = 1; i < 5; ++i)

{

// Add start/feed urls. 添加初始采集链接

site.AddStartUrl($"http://list.youku.com/category/show/c_96_s_1_d_1_p_{i}.html");

}

Spider spider = Spider.Create(site,

// use memoery queue scheduler. 使用内存调度

new QueueDuplicateRemovedScheduler(),

// use custmize processor for youku 为优酷自定义的 Processor

new YoukuPageProcessor())

// use custmize pipeline for youku 为优酷自定义的 Pipeline

.AddPipeline(new YoukuPipeline());

spider.Downloader = new HttpClientDownloader();

spider.ThreadNum = 1;

spider.EmptySleepTime = 3000;

// Start crawler 启动爬虫

spider.Run();

}

public class YoukuPipeline : BasePipeline

{

private static long count = 0;

public override void Process(params ResultItems[] resultItems)

{

foreach (var resultItem in resultItems)

{

StringBuilder builder = new StringBuilder();

foreach (YoukuVideo entry in resultItem.Results["VideoResult"])

{

count++;

builder.Append($" [YoukuVideo {count}] {entry.Name}");

}

Console.WriteLine(builder);

}

// Other actions like save data to DB. 可以自由实现插入数据库或保存到文件

}

}

public class YoukuPageProcessor : BasePageProcessor

{

protected override void Handle(Page page)

{

// 利用 Selectable 查询并构造自己想要的数据对象

var totalVideoElements = page.Selectable.SelectList(Selectors.XPath("//div[@class='yk-pack pack-film']")).Nodes();

List results = new List();

foreach (var videoElement in totalVideoElements)

{

var video = new YoukuVideo();

video.Name = videoElement.Select(Selectors.XPath(".//img[@class='quic']/@alt")).GetValue();

results.Add(video);

}

// Save data object by key. 以自定义KEY存入page对象中供Pipeline调用

page.AddResultItem("VideoResult", results);

// Add target requests to scheduler. 解析需要采集的URL

//foreach (var url in page.Selectable.SelectList(Selectors.XPath("//ul[@class='yk-pages']")).Links().Nodes())

//{

// page.AddTargetRequest(new Request(url.GetValue(), null));

//}

}

}

public class YoukuVideo

{

public string Name { get; set; }

}

*敏*感*词*爬虫

配置爬虫需要额外参考DotnetSpider2.Extension(Nuget中获取)

在大多数情况下,只需要一个配置文件来实现一个 采集 任务。配置爬虫与基本用法相比,只需要几行代码就可以实现一个爬虫。但凡事有利有弊,配置爬取的自由度比较低。

使用配置文件爬虫的步骤如下:

定义数据实体类,通过添加Attribute来定义数据存储规则,通过页面数据的解析规则定义爬虫任务的定义,继承EntitySpider在Main方法中实例化定义的爬虫任务,并调用运行方法

完整代码如下,自己感受一下,后面的章节会详细介绍如何实现:

public class JdSkuSampleSpider : EntitySpider

{

public JdSkuSampleSpider() : base("JdSkuSample", new Site

{

//HttpProxyPool = new HttpProxyPool(new KuaidailiProxySupplier("快代理API"))

})

{

}

protected override void MyInit(params string[] arguments)

{

Identity = Identity ?? "JD SKU SAMPLE";

ThreadNum = 1;

// dowload html by http client

Downloader = new HttpClientDownloader();

// storage data to mysql, default is mysql entity pipeline, so you can comment this line. Don't miss sslmode.

AddPipeline(new MySqlEntityPipeline("Database='mysql';Data Source=localhost;User ID=root;Password=;Port=3306;SslMode=None;"));

AddStartUrl("http://list.jd.com/list.html?cat=9987,653,655&page=2&JL=6_0_0&ms=5#J_main", new Dictionary { { "name", "手机" }, { "cat3", "655" } });

AddEntityType();

}

[EntityTable("test", "jd_sku", EntityTable.Monday, Indexs = new[] { "Category" }, Uniques = new[] { "Category,Sku", "Sku" })]

[EntitySelector(Expression = "//li[@class='gl-item']/div[contains(@class,'j-sku-item')]")]

[TargetUrlsSelector(XPaths = new[] { "//span[@class=\"p-num\"]" }, Patterns = new[] { @"&page=[0-9]+&" })]

public class Product : SpiderEntity

{

[PropertyDefine(Expression = "./@data-sku", Length = 100)]

public string Sku { get; set; }

[PropertyDefine(Expression = "name", Type = SelectorType.Enviroment, Length = 100)]

public string Category { get; set; }

[PropertyDefine(Expression = "cat3", Type = SelectorType.Enviroment)]

public int CategoryId { get; set; }

[PropertyDefine(Expression = "./div[1]/a/@href")]

public string Url { get; set; }

[PropertyDefine(Expression = "./div[5]/strong/a")]

public long CommentsCount { get; set; }

[PropertyDefine(Expression = ".//div[@class='p-shop']/@data-shop_name", Length = 100)]

public string ShopName { get; set; }

[PropertyDefine(Expression = ".//div[@class='p-name']/a/em", Length = 100)]

public string Name { get; set; }

[PropertyDefine(Expression = "./@venderid", Length = 100)]

public string VenderId { get; set; }

[PropertyDefine(Expression = "./@jdzy_shop_id", Length = 100)]

public string JdzyShopId { get; set; }

[PropertyDefine(Expression = "Monday", Type = SelectorType.Enviroment)]

public DateTime RunId { get; set; }

}

}

public class Program

{

public static void Main(string[] args)

{

JdSkuSampleSpider spider = new JdSkuSampleSpider();

spider.Run();

}

}

代码地址

希望大家加星:)