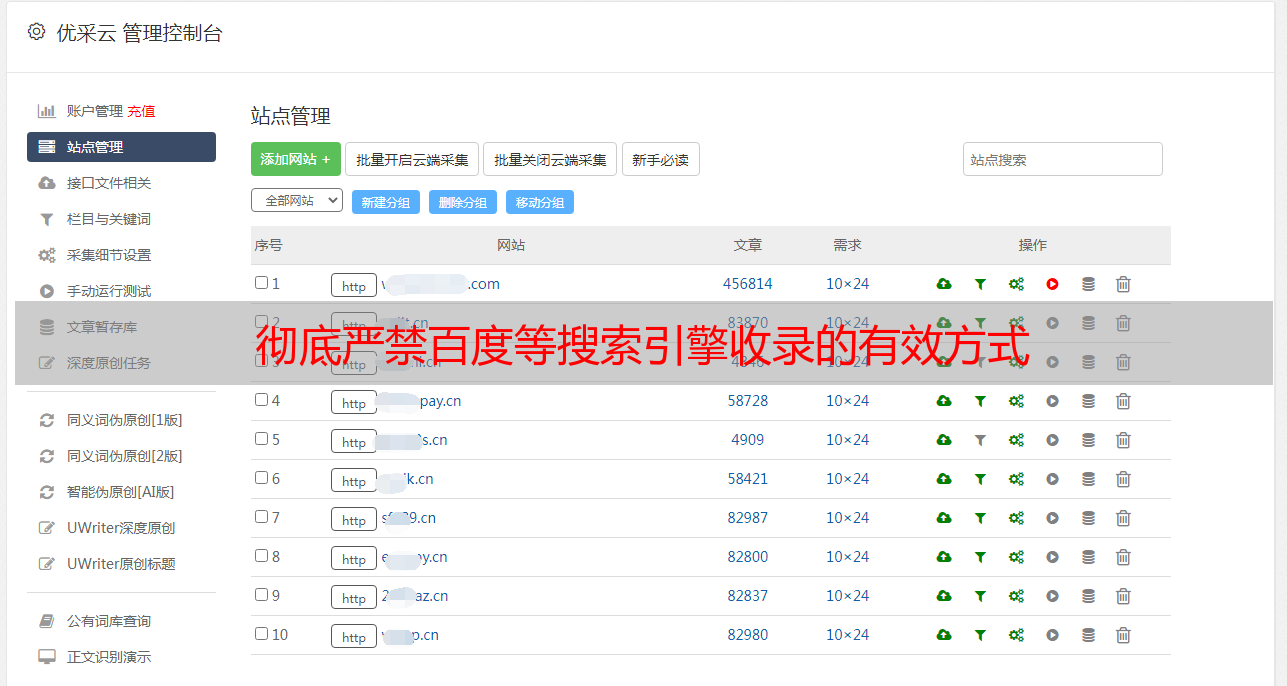

彻底严禁百度等搜索引擎收录的有效方式

优采云 发布时间: 2020-08-01 08:01

虽然建设网站的目的大部分是为了优化搜索引擎排名,实现互联网营销,但特殊情况下搜索引擎禁止的方式优化网站,仍会碰到“不希望搜索引擎收录”的需求,这里给出终极、有效的严禁百度等搜索引擎收录的解决方案。

一、Robots.txt只能严禁抓取,无法严禁收录

很多人觉得rohots.txt也已严禁百度收录,这是严重的误会,robots.txt文件可以告诉搜索引擎什么目录和文件可以抓取,哪些不可以。经过实践发觉,即使严禁搜索引擎抓取根目录,robots文件也并不能实现严禁百度等搜索引擎收录。如果一个网站的外链较多,基本上未能通过正常手段严禁百度收录,淘宝便是一个典型的案例(淘宝的robots.txt设置为严禁抓取根目录,但首页仍然被收录)。关于robots.txt的作用、文件格式、使用方式,可参考百度站长平台的说明。

二、通过Nginx判定user_agent严禁百度等搜索引擎访问,实现严禁收录

既然不能直接严禁抓取搜索引擎禁止的方式优化网站,那就干脆严禁百度蜘蛛等搜索引擎访问,思路是:判断user_agent,如果是百度蜘蛛、谷歌机器人等搜索引擎的user_agent,就返回403或则404,这样百度等搜索引擎都会觉得这个网站无法打开或则不存在,自然也就不会收录了。

Nginx的配置代码如下:

if ($http_user_agent ~* "qihoobot|Baiduspider|Googlebot|Googlebot-Mobile|Googlebot-Image|Mediapartners-Google|Adsbot-Google|Feedfetcher-Google|Yahoo! Slurp|Yahoo! Slurp China|YoudaoBot|Sosospider|Sogou spider|Sogou web spider|MSNBot|ia_archiver|Tomato Bot")

{

return 403;

}

通过curl模拟搜索引擎抓取,测试以上代码有效,并在多次项目实践中验证了此方式的可行性,实现了彻底严禁百度收录!