seo网站日志分析工具( 阿里云应用业务有问题,云平台监控运维大脑融合SRE方法)

优采云 发布时间: 2021-11-25 09:01seo网站日志分析工具(

阿里云应用业务有问题,云平台监控运维大脑融合SRE方法)

1. 后台目标

阿里云应用业务有问题。云平台监控可以发现问题,但无法定位问题的根源。运维大脑监控底层日志,快速定位问题原因,帮助现场运维同学解决问题。

运维大脑整合SRE方式,聚焦深度运维技术服务领域,助力客户和现场,提升租户视角运维监控能力,提升平台视角问题定位效率,强化二维容量绩效运营能力。集中TAM现场运维经验,以多元化、标准化、智能化的方式向客户输出运维能力和技术服务。

2. 开发设计

图 1:流程图

2.1 日志配置

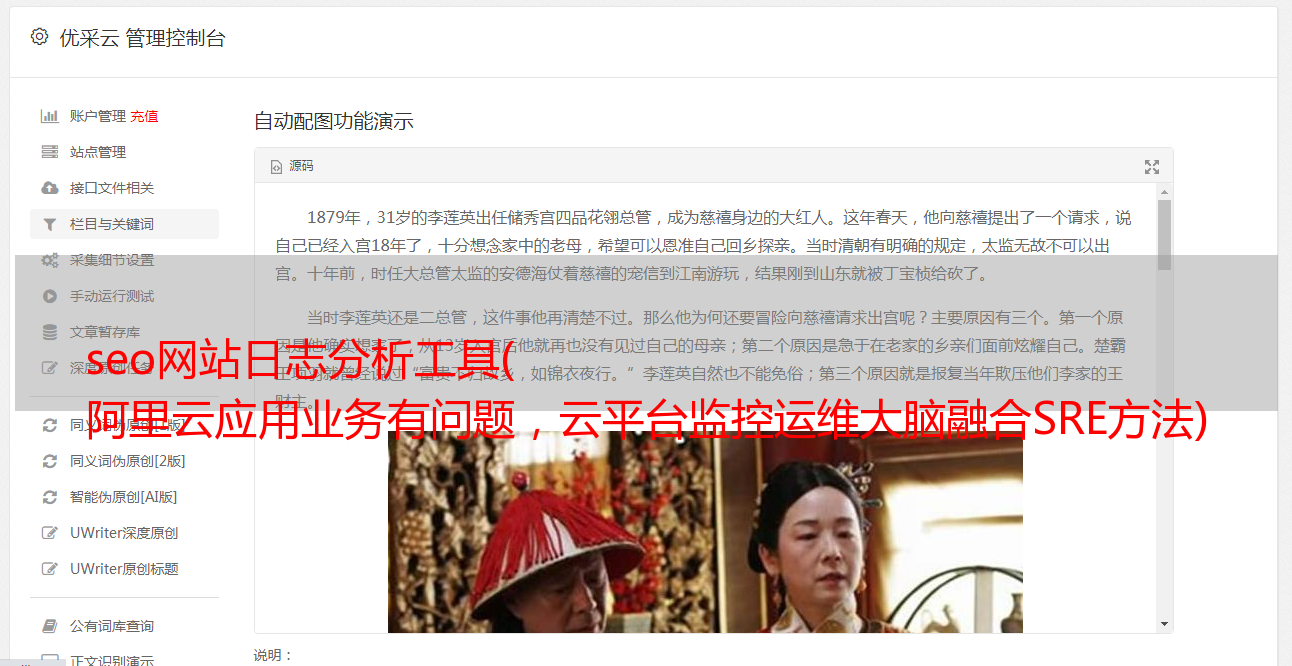

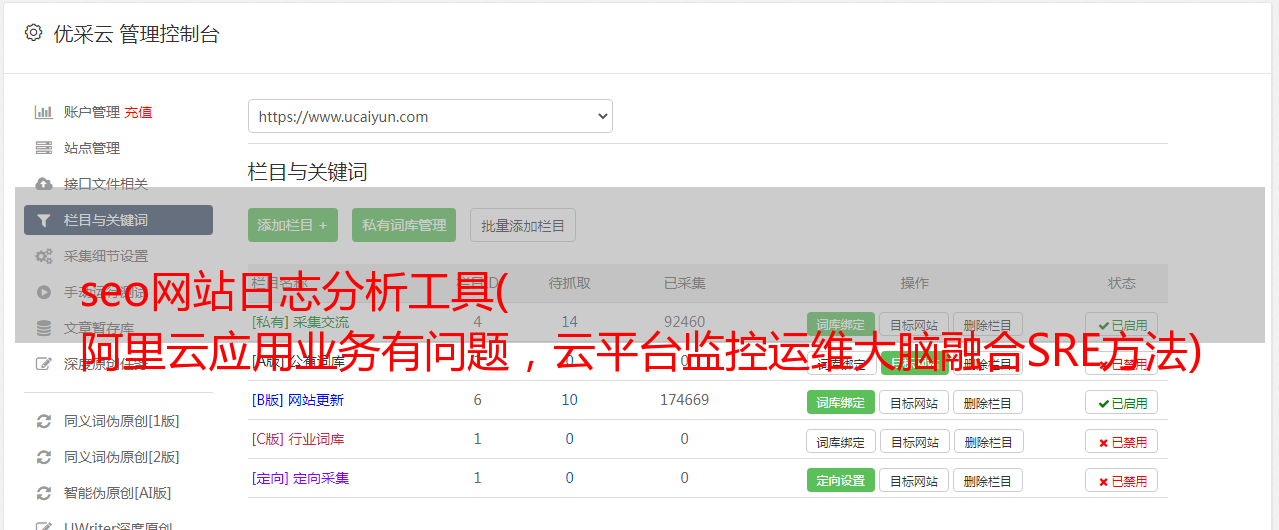

如图2所示,需要监控的日志可以通过运维大脑的前端页面进行配置,可以单独添加,也可以批量导入。配置信息包括产品、服务、服务角色、日志类型(DOCKER物理机VM)、日志路径、监控周期、算法(ML-TOP ML-CP ML-KEY)、状态(开启/关闭)。

图 2:日志配置

2.2 日志训练

前端配置日志信息存储在后端数据库中,后端程序根据产品、服务、服务角色等条件查询对应的主机名。

图 3:数据库

定时任务启动,根据获取到的主机名,通过PSSH命令将训练脚本发送到各台机器上。发布前,确定每台机器是否有训练脚本。如果脚本已经存在,请停止发出命令。

图 4:pssh

训练脚本开始工作:首先读取日志,通过常规规则进行英文分词(英文文本可以通过NLTK库进行分词,中文文本可以通过JIEBA分词。这里选择最简单的PYTHON内置——在RE模块中根据特殊符号(分词),统计总词数,计算每个词的词频。将词按词频排序为二进制形式的TOP模型文件,词频排序为CP模型文件,如图5所示。

警告:文件命名最好以服务角色+文件路径的形式命令,否则后续读取时可能会发生冲突。

图 5:文件命名

2.3 日志分析

定时任务启动,就像训练过程的初始化一样,首先判断每台机器是否有分析脚本,如果不存在则发出命令。

分析脚本开始工作:首先读取日志,不同于日志训练。分析脚本会根据前端配置的监控周期进行选择(例如监控周期为30分钟,分析脚本会选择当前时间到30分钟前的日志进行分析)。与训练脚本类似,读取日志后,进行文本切分,统计词数,统计词频。读取模型文件,根据不同算法计算出算法的权重值(算法将在文章第三部分单独介绍)。对算法权重值进行阈值判断。如果超过阈值,则从日志文件中判断并获取日志异常信息。分析完毕,

图 6:日志分析

2.4 模型优化

训练模型初始化的缺点是不能手动打标签(正常\异常),所以初始化的模型文件一定不能是完全正常的模型,需要不断优化。

定时任务启动:同流程。读取文件、分词等后,生成的模型文件与源模型文件进行比较。比较的方法和算法是一样的。阈值低于分析阈值。阈值降低后,词频词典按顺序合并排序后,分别写入源模型文件。至此,整个日志过程完成了闭环操作。

2.5 日志检查

日志检查是对其自身系统运行状态的监控,它围绕着整个闭环运行。日志训练、分析和模型优化由定时任务驱动。日志检查判断操作过程的每一步是否成功,分析操作异常的原因。相关数据存储在数据库中,显示在前端,如图7所示。显示。

图 7:日志检查

3. 算法逻辑

运维大脑开发的算法借鉴了贝叶斯和文本相似度两大算法,以传统的自然语言处理方法对文本进行分析。

3.1 两种常用的分词方法:口吃分词和nltk库分词

口吃分词适用于中文分词,分词原理是:

① 基于Trie树结构实现高效的词图扫描,生成一个句子中汉字所有可能的构词法组成的有向无环图(DAG)。

②使用动态规划寻找概率最大的路径,并根据词频找到最大的切分组合。

③对于未注册词,采用基于汉字形成能力的HMM模型,采用维特比算法。

nltk 库只能用于英语分词,除了词性标注和文本分析。

我个人认为英文分词可以用空格或者一些特殊符号来分割:re.split()。

3.2 TF-IDF

TF-IDF是Term Frequency-Inverse Document Frequency的缩写,即词频-逆文档频率,用于描述一个词在文档中的重要性,即该词是否可以用来表示文档的主要内容。

3.3 文本相似度

潜在语义索引 (LSI) 分析文本的基本主题。LSI是一种概率主题模型,另一种常见的是LDA。核心思想是:每个文本有多个不同概率分布的主题;每个主题收录所有已知词,但这些词在主题中的概率分布不同。LSI 使用奇异值分解的方法来计算文本中每个主题的概率分布。严格的数学证明需要阅读相关论文。假设有5个主题,那么通过LSI模型,可以将文本向量降为5维,每个分量代表对应主题的权重。