搜索引擎平台的抓取规则:百度、360、搜狗等

优采云 发布时间: 2021-03-28 18:03

搜索引擎平台的抓取规则:百度、360、搜狗等

搜索引擎平台的获取规则:

比较百度,36 0、搜狗和其他搜索引擎的爬网规则!

蜘蛛爬网规则:深度优先和宽度优先

深度优先:

深度优先策略是沿一条路线走到黑路,而当无路可走时,然后回去并走另一条路。

深度优先

宽度优先:

广度优先策略意味着,当蜘蛛在页面上找到多个链接时,它不会变成黑色并跟随链接继续进行爬网,而是先对这些页面进行爬网,然后对这些页面进行爬网。从中提取链接。

搜索引擎会根据某些策略主动抓取网页,处理内容,并将网页返回给搜索引擎服务器;

宽度第一

提取链接,处理检索到的网页的内容,消除噪音,提取页面的主题文本内容等;

网页文本内容的中文分词,停用词的删除等;

对网页内容进行分段后,判断网页内容是否与已索引的网页重复,删除重复的页面,对其余网页进行分类和索引,然后等待用户检索。

网站层次结构:

一个是我们经常称呼的扁平结构,另一个是我们通常看到的树形结构,但是我们通常看到的通常是一个树形结构,它便于管理,但对于网站而言,它通常在三个级别内。主页是第一层,列页面和类别页面是第一层,信息详细信息页面和产品详细信息页面是第一层。 网站必须简化代码,不要马虎,以便蜘蛛可以快速抓取。

网站层次结构

高质量的外链入口:

每天定期发布一些高质量的内容,例如更新新闻:保证每周至少更新两篇文章,并且可以在星期二和星期五的上午10点进行更新,因为这是互联网的时代相对活跃,新闻量不一定很好。最好建立更多的外部链接,因为建立高质量的外部链接和访问渠道对网站既有益又无害。前提是网站在线一段时间后,如果是新电台,则无法采用此方法。

高质量的外链

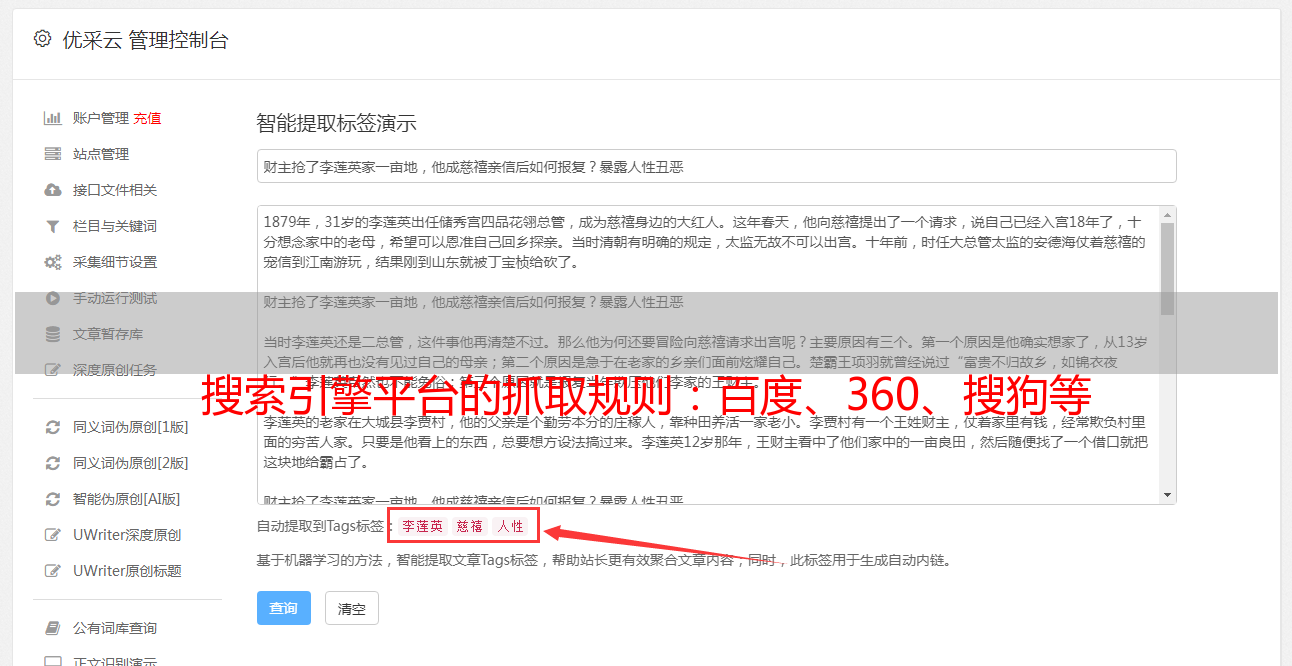

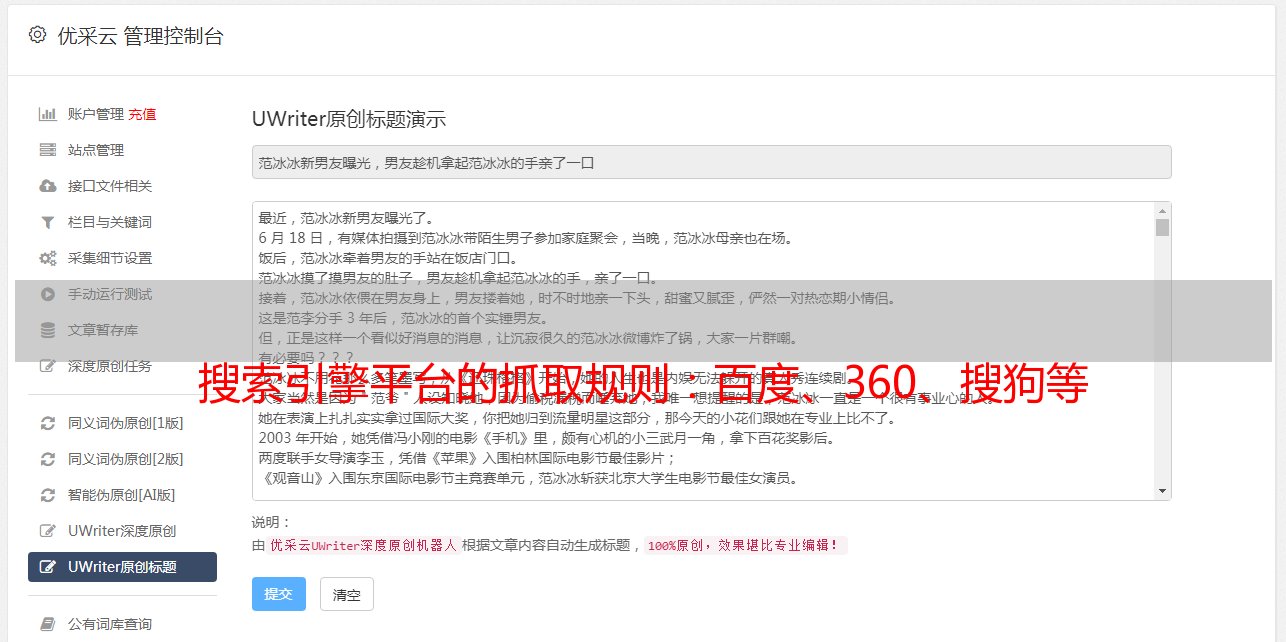

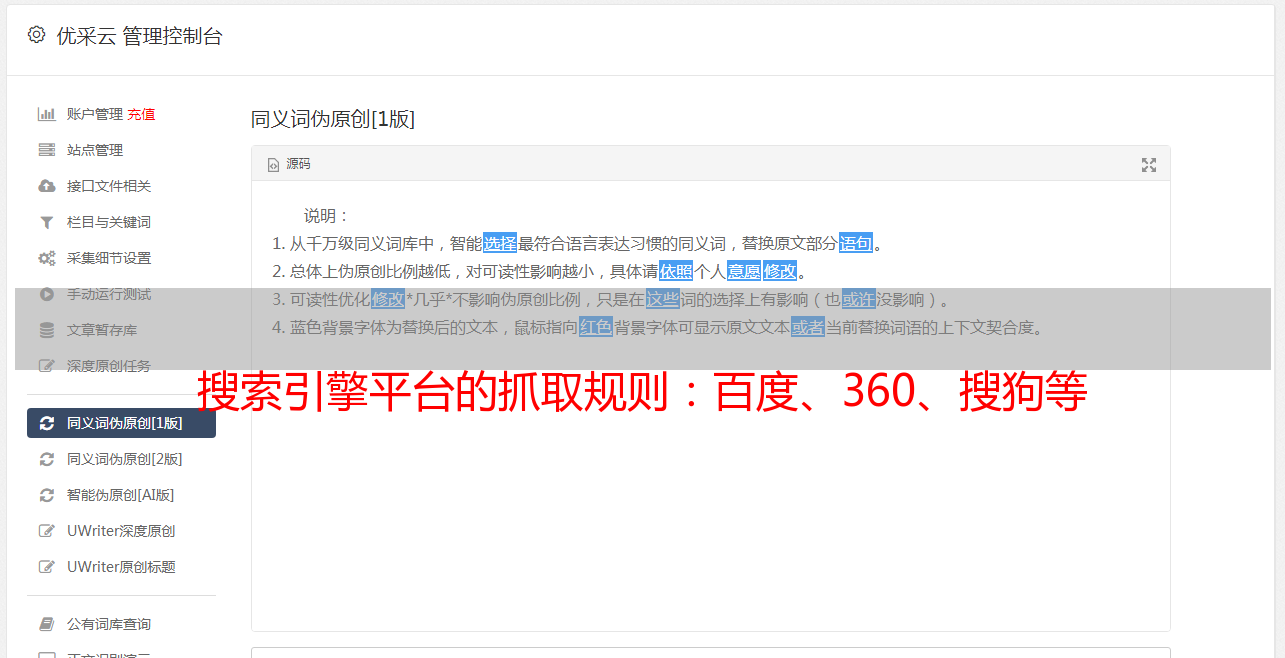

内容页面原创:

我们整天都在说内容页面的质量越高,网站越好,但是我们不知道这是网站优化的关键,因为只有高质量的内容[ 文章可以吸引搜索引擎蜘蛛爬行。和收录。同时,当客户来浏览我们的网站时,它还可以降低跳出率。

原创内容

分析和采集规则:

从搜索引擎抓取的角度分析网站的采集规则。优化网站时,网站的排名有时会在首页内容更新后下降。当以某种方式返回快照时,将恢复排名。通过仔细分析百度网站管理员平台的关键词和流量,可以发现网站主页的内容保持不变的情况下,一定数量的关键词具有一定的点击次数。内容更新后,点击次数减少了。当快照返回时,排名再次上升。因此,推测百度在爬网和采集内容时会考虑用户体验。 网站点击次数从侧面反映了用户体验。

换句话说,搜索引擎将捕获并存储许多网页快照。如果旧页面快照在用户中更受欢迎,则不一定要包括新页面快照,因为搜索引擎始终必须考虑用户体验。

分析和采集数据

百度和36 0、搜狗搜寻规则之间的区别:

搜索引擎的爬网规则大致相同。只有两个条件是直接影响不同搜索引擎的网站页收录的因素。一个是排名规则(算法),另一个是外部链平台的类型;

例如,今天发布的内容可以在百度上排名,但在360上甚至不会。百度和360搜索引擎都有相应的算法。百度上发布的内容在百度算法的可接受范围内,因此可以排名收录,但是360的算法不允许您的内容为收录,因此发生了这种情况。因此,我们必须相应地了解算法。在外链站点上构建外链可以满足搜索引擎蜘蛛发现收录的需求和超链接权重计算的需求。

蜘蛛爬行

摘要:Internet上每天有成千上万个新网页,并且大型网站生成的新页面多于小型网站。搜索引擎倾向于从大网站获取更多页面,因为大网站倾向于收录更多高质量页面。搜索引擎更喜欢先爬网和采集大型网页。这只是一种提醒SEO的网站管理员让更多内容出现在网站上的方法,丰富的网页将引导搜索引擎频繁捕获和采集,这是SEO的长期规划思想。