网页文章自动采集(非广告!推荐一款免费论文爬虫工具,优采云爬虫,但无法下载)

优采云 发布时间: 2021-11-12 11:08网页文章自动采集(非广告!推荐一款免费论文爬虫工具,优采云爬虫,但无法下载)

不是广告!推荐一个免费的论文爬虫工具,优采云爬虫,但是论文无法下载。

前几天,课题组写的申请表申请基金需要包括推荐人。为了保证质量,需要在SCI期刊中检索相关文献。看到导师的要求,有点懵,不知道从何下手!因为我用了很多论文搜索网站(如nature、HowNet、PUBMED、WEB OF SCIENCE、艾斯维尔等),从未见过有专门对一区文献进行排序和排序的数据库中科院可以纳入其中。搜索相关文献。

为了保证效率,当晚打电话给朋友,帮我在WEB OF SCIENCE和Nature网站搜索相关期刊。方法很笨:

开放科学直通网站,

第一步当然是输入关键词,比如(human),点击搜索。

第二步是确定搜索范围。比如时间,文件类型(2018-2020,文件类型)

第三步就是看题目翻译,然后查出相关期刊是否属于一个区,还要看摘要,都是英文的。如果符合要求,请进行备份。

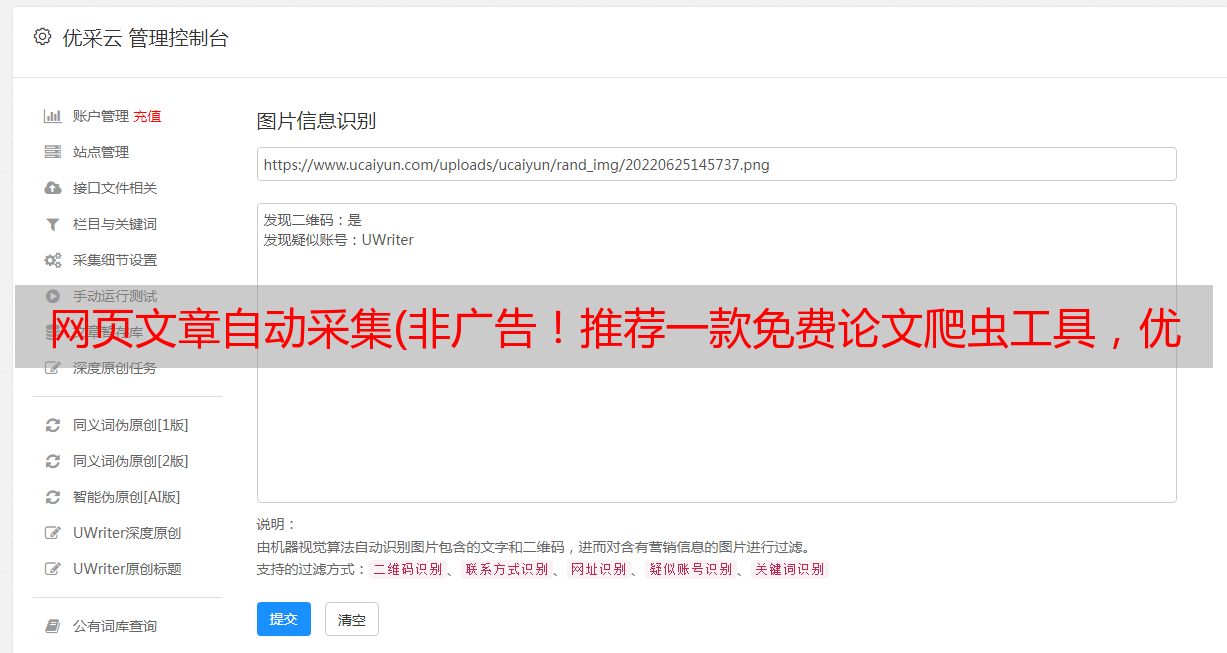

如图所示:

关于期刊是不是区,web of science 好像可以直接看

不知道为什么,我的第一个想法是使用爬虫工具。不过我是电脑新手,根本不会写脚本,更不会编程。百度里也有很多免费的爬虫工具,但是搜索结果要隔天提交,没时间琢磨这个工具怎么用。我和朋友一直工作到凌晨,来回找了几份文件也没找到。果然,能力不够就得加班~

交完作业后,我在想如何快速又经济地解决这个问题:如何只在期刊的一个区域检索我需要的文件?在知乎上没有找到相关答案,很多都是用Python写的,不适合电脑新手。当然,脚本是非常有效的。我觉得写脚本爬虫是一种非常精准的方法,不会受到爬虫专业软件功能有限的限制。我也应该在未来研究它。

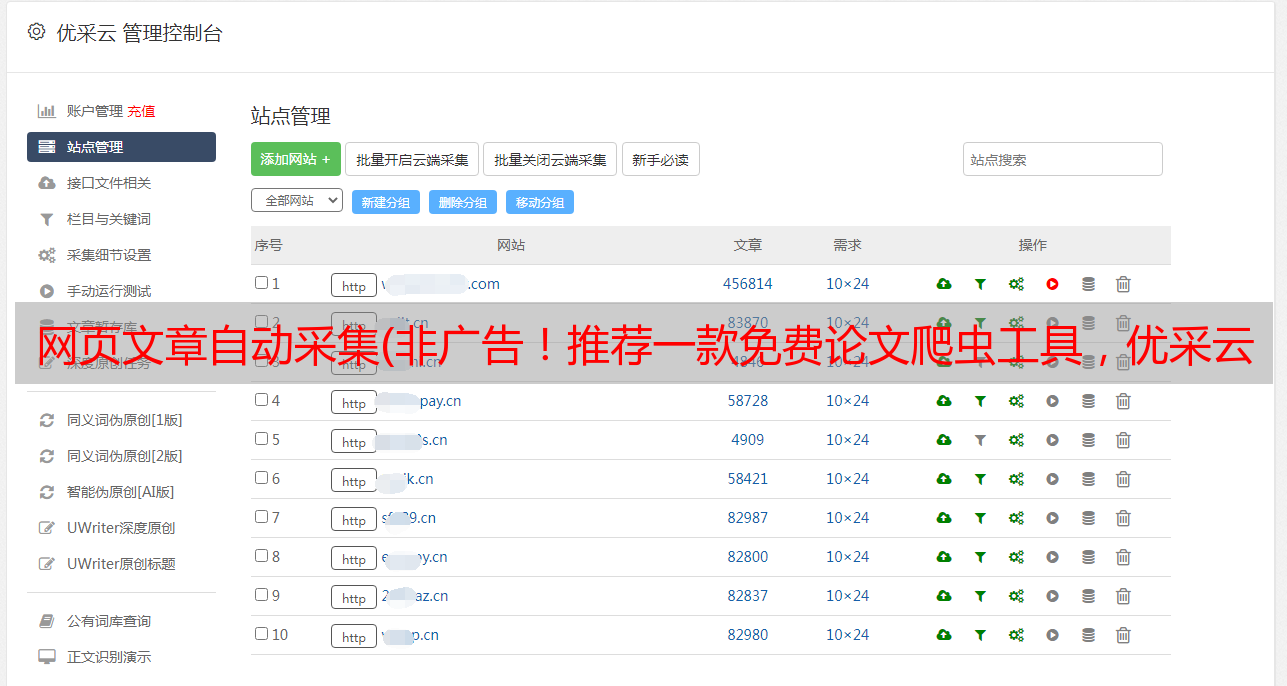

我在百度上发现了很多爬虫工具,比如优采云、优采云等。当时我随机选了一个,优采云。进去之后发现用学生邮箱注册有一年免费使用专业版的特权,然后就选了哈哈,就是任性。我声明我绝对不是广告。如有侵权,我会更改或删除。

解决思路:使用爬虫工具将检索到的文献的全名、时间、全名导出到Excel,然后找到第一区所有文献的汇总表(目前我只有2018版本,自然通讯分为两个区哈哈),将所有检索到的文献的期刊一一匹配,这样就可以在结果中得到第一区甚至第二区的所有文献。

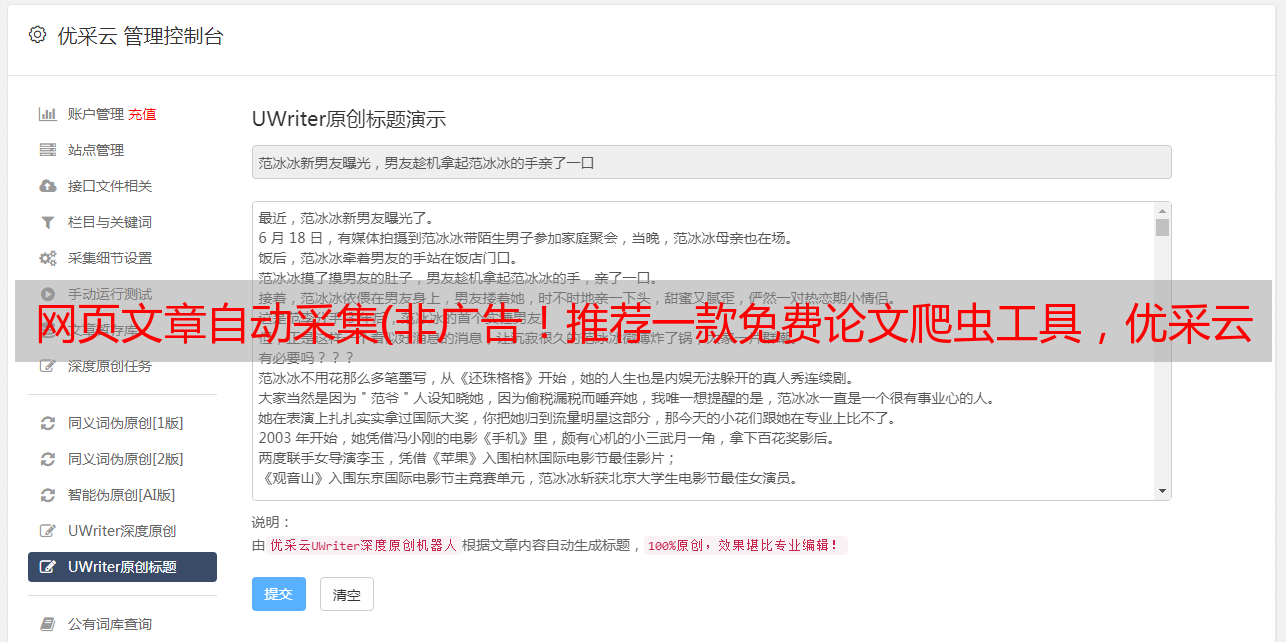

如图所示:

这是我得到的最终结果,如果你觉得有用,你可以继续阅读我的回答

话不多说,来看看这个工具怎么用吧。

目前这个工具功能有限(期刊第一区的定位功能还是鸡肋,需要用Excel过滤),无法下载PDF格式的论文。我只需要文件名,出版时间,期刊名称,期刊链接,摘要(我没有看到任何可以肆无忌惮地批量下载的网站)。因此,我不需要登录学院VPN或图书馆,直接进入,打开网页的速度得到了极大的保证。学校在异地使用VPN卡!

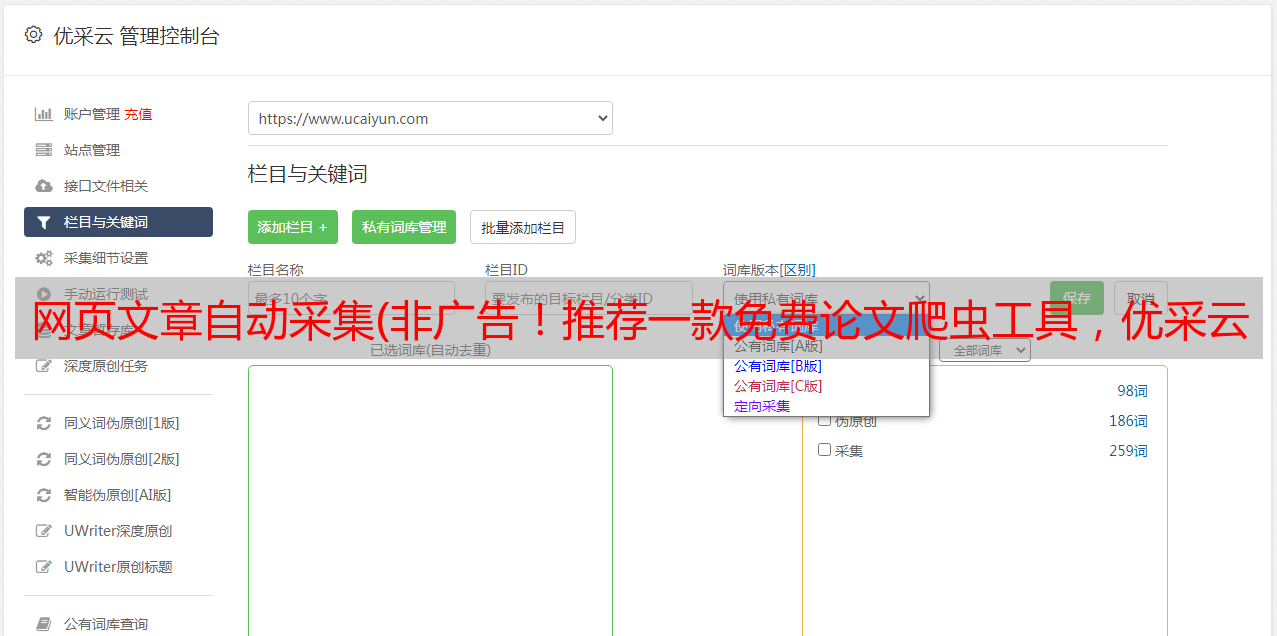

先注册一个账号(学生邮箱,最后的邮箱可以有一年的免费使用权),在优采云官方网站下载优采云爬虫工具,打开并登录.

安装后桌面图标应该是这样的

------------------------------

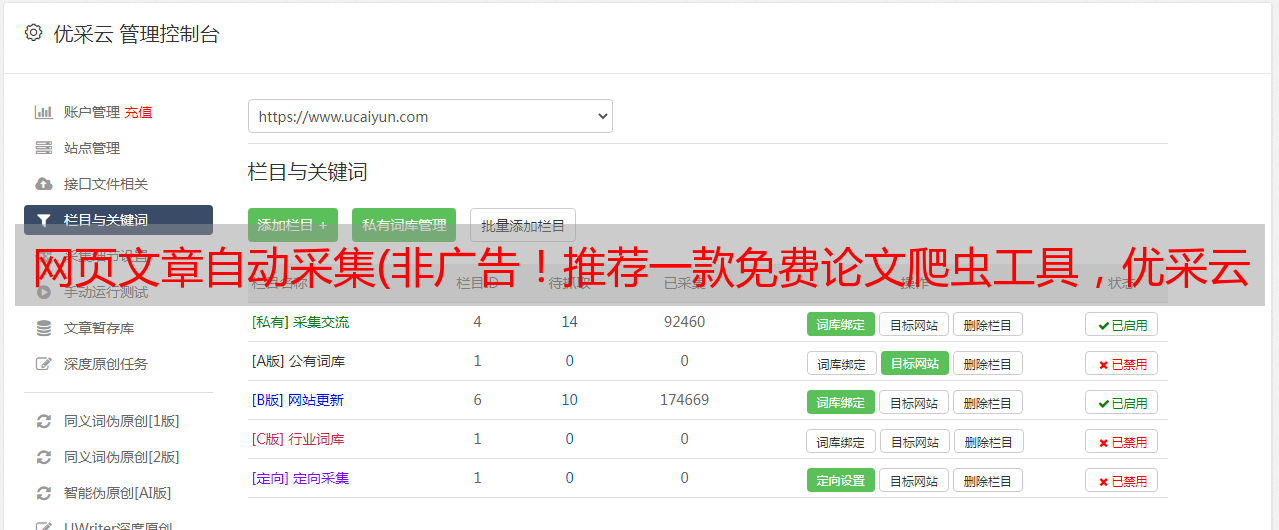

点击新建-->自定义任务

------------------------------

在打开的自定义任务的地址栏中输入艾斯维尔官方网站

单击保存设置。

------------------------------

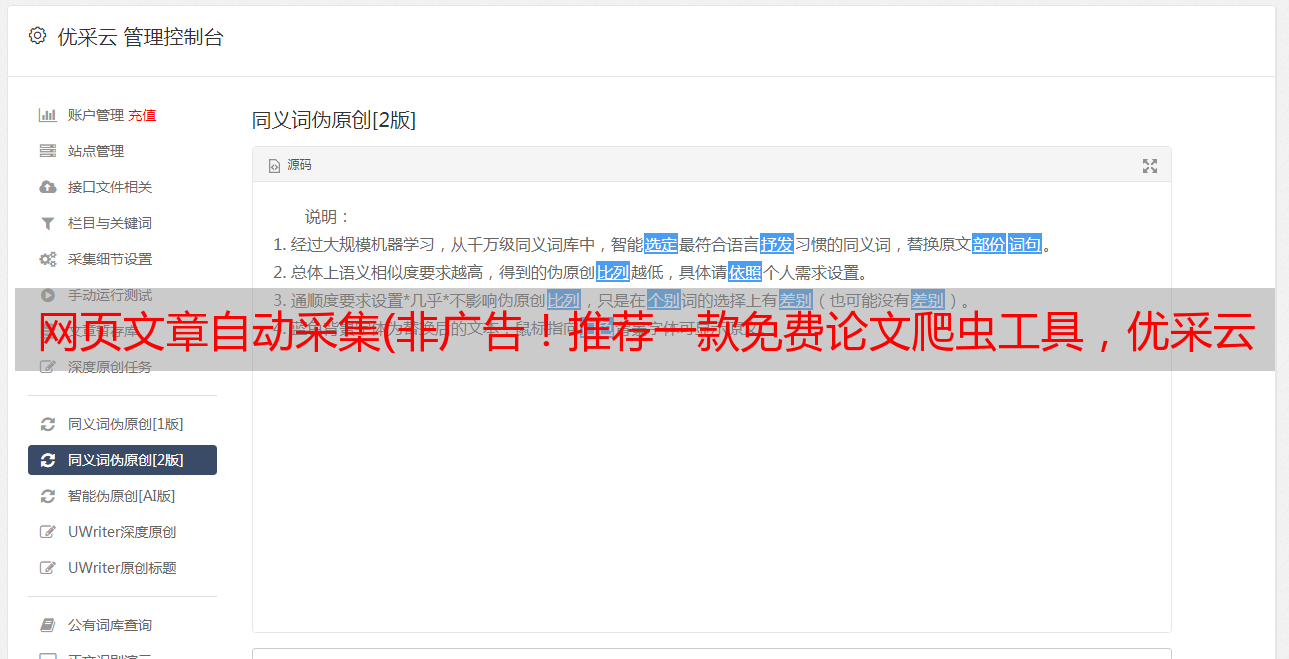

点击关键词,出现操作提示,点击输入文字。

------------------------------

然后弹出操作提示对话框,输入要检索的关键词,点击确定

------------------------------

点击上面的确定后,我们应该点击搜索。

然后点击搜索按钮,会继续出现“操作提示”。因为搜索图标是一个按钮,所以我们应该点击 BUTTON 标签。如下所示。

点击BUTTON后,操作提示更改,点击“点击此按钮”。

实际上很容易理解如何完成这些任务。如果我们不使用爬虫工具,我们还需要在爱思唯尔网站中输入关键词,点击开始搜索这些操作,工具就是记录你的一系列操作,然后就会自动执行。

按钮设置好点击后,软件内置浏览器真正点击搜索按钮,在流程图中生成点击元素的步骤。目前,我们的几个操作步骤已经被流程图记录下来了。流程图可能在我们第一次使用的时候就被我们搞乱了,需要我们去适应。

------------------------------

进入搜索页面后,Aiswell会弹出登陆页面,我们点击×周围的空白处,出现操作提示“点击此按钮”关闭网页。此时,流程图应如下所示:

------------------------------

继续下一步,选择时间,日志类型,每一步都会在流程图中生成一个步骤,如下图所示。前面说过,这个工具的功能之一就是记录你进入Aiswell搜索的每一步,然后像机器人一样执行。

------------------------------

聚苯乙烯

省力的方法:设置好这些参数(设置文档时间段和文档类型)后,就可以直接复制设置的URL创建项目了。之所以如上介绍,是为了让其功能介绍更全面一些,方便大家自定义自己的需求。如下所示:

根据自己的需要设置好所有参数,然后复制上面的网址,不需要进入软件设置

细心的人还会发现,进入Aiswell时弹出的登录页面会在页面打开几秒后弹出。我们可以设置在执行关闭登录页面按钮之前等待 5 秒。可以在流程图的click元素中设置,大家自己找吧。

------------------------------

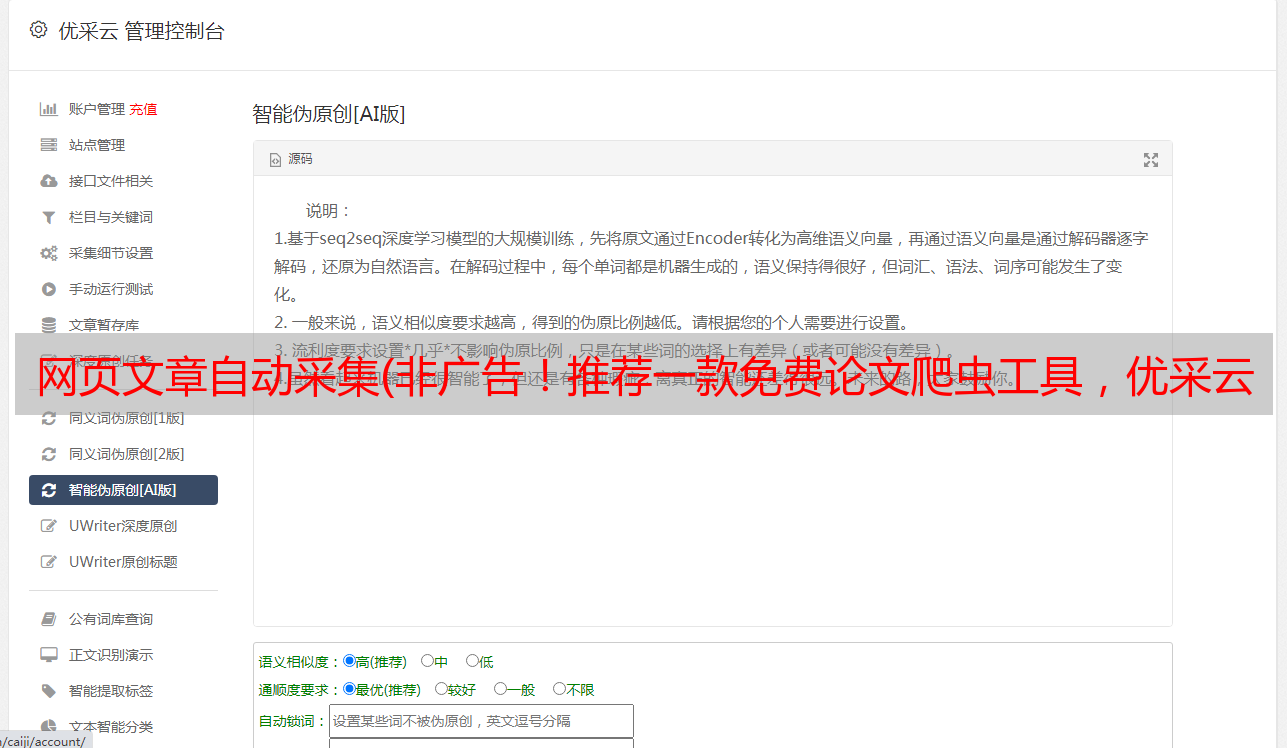

这样,我们的准备工作就完成了。流程图如下图,然后我们点击“自动识别网页”

这一步非常重要。如果您不了解 HTML,请尝试选择这一步。这一步可以识别出网页中可以提取的文字,甚至是超链接,都可以导出。点击下图自动识别后,我们需要等待进度条加载到100%。在此期间不要做任何事情。

------------------------------

识别是这样的:

哈哈,看看能不能提取的文字都被识别了?优采云自动识别功能还可以帮我们自动设置翻页,翻页次数也可以设置。

------------------------------

然后点击“生成采集设置”

生成下图:

--------------------

然后我们点击“保存并启动采集”获取采集的数据,完成采集后将数据输出到Excel。使用vlookup函数进行比较,就可以得到我们想要的文献了。拉。

如果我们不想采集论文的作者,我们可以点击提取的列表数据旁边的齿轮状按钮进入采集字段设置。

--------------------

如图,找到作者,然后点击垃圾桶按钮图标离开作者栏~

然后点击软件“采集”按钮启动采集。软件支持自动翻页。一般来说,自动翻10页文档进行检索就足够了。之后,停止测试并导出数据。页面上的文档采集已到达。

====================================

对于一些网站,通过软件的自动识别功能,只能识别作者,不能识别标题。我能做什么?我们只采集作者字段有什么用!!

告诉大家一个办法。

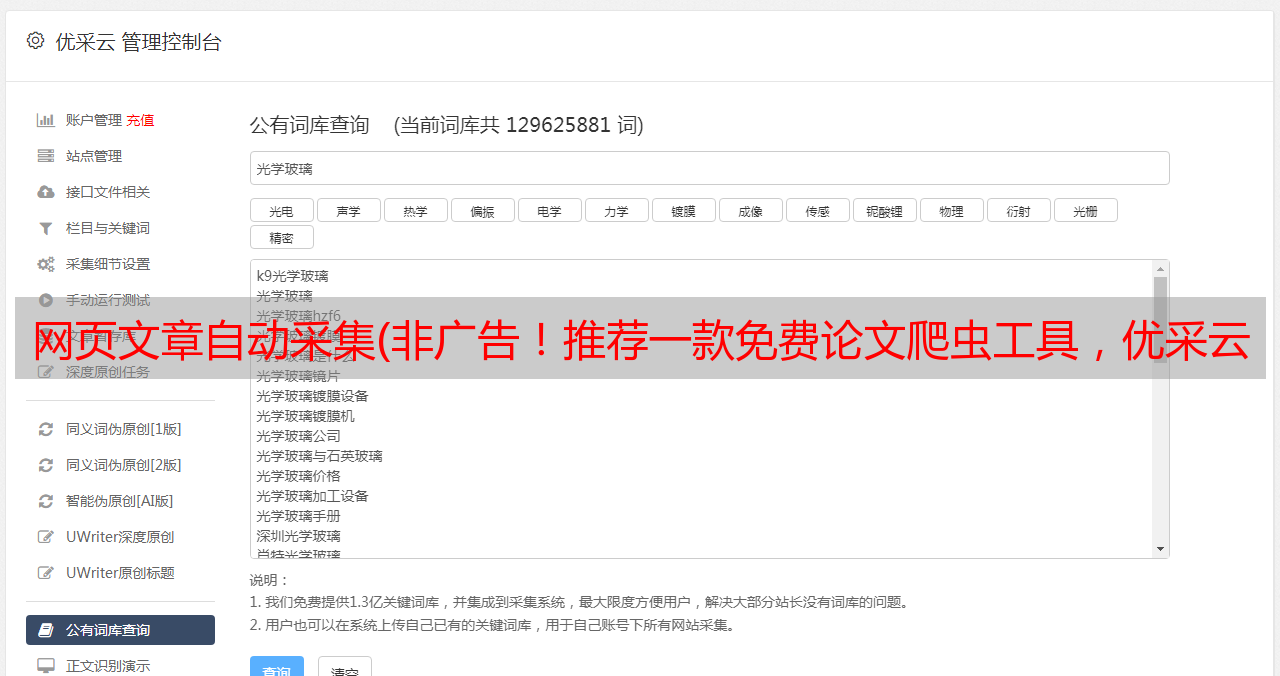

在网页中,每段文字和每张图片都有自己的位置。事实上,我们看到的网页,包括知乎、百度等,都是在这些位置填充不同的文字和不同的图片,变得丰富多彩,但这些文字和图片必须严格限制在它的座位上。例如知网:

在浏览器中按F12进入开发者模式。在弹出的收录大量代码的对话框中,点击鼠标形状的按钮“选择页面元素”“拆解”CNKI,找到文字和图片对应的座位。

将鼠标移到文档的标题上,会自动显示一个代码:“td|355.233*52”,那么我们就可以知道文档的标题放在了“td”的位置.

显示 td 后,单击鼠标左键。这时候开发者对话框中的代码会自动跳转到“td”这里。

好吧,我们找到了标题所在的座位号。这是代码:

此时,我们返回到识别错误的软件界面。一般来说,循环列表是错误的,所以这里我们要点击“循环列表”来设置正确标题的座位号。

点击设置图标后,进入圆形列表设置界面。

红框是我们需要填写的“座位号”。

每个网站都有不同的座位号,但在优采云软件中,它有固定的格式:

//类型名称[@型="参考名称"]

(我不是专业的,我只是给它起个名字方便理解)

比如上面知网的标题座位号是:

//a[@class="fz14"]

只需在上面填写正确的座位号并输入即可。

好的,记得点击保存!软件可以找到正确的循环列表。

你可以自己试试。Aswell 的循环列表应该这样设置:

开发者模式鼠标位置应在上方区域形成蓝色阴影,点击获取座位号。

记住,点击后,座位号会自动标记为蓝色,其他代码我们不想看。

按照我刚才填写的方法,座位号应该是这样的。

我保留了几个网站的“座位号”:

Aceville 的循环列表:

//li[@class="ResultItem col-xs-24 push-m"]

ncbi 的循环列表:

//文章[@class="labs-full-docsum"]

Microsoft Academic 的循环列表:

//div[@class="primary_paper"]

期刊:

//A[@class="title au-target"]