php抓取网页源码(本站提供绿色版的无语网站链接抓取器(提取网页全部超链接) )

优采云 发布时间: 2021-11-07 04:13php抓取网页源码(本站提供绿色版的无语网站链接抓取器(提取网页全部超链接)

)

本站提供无言网站链接抓取器绿色版,【网站链接抓取器下载】无言网站链接抓取器(从网页中提取所有超链接)软件免费下载。

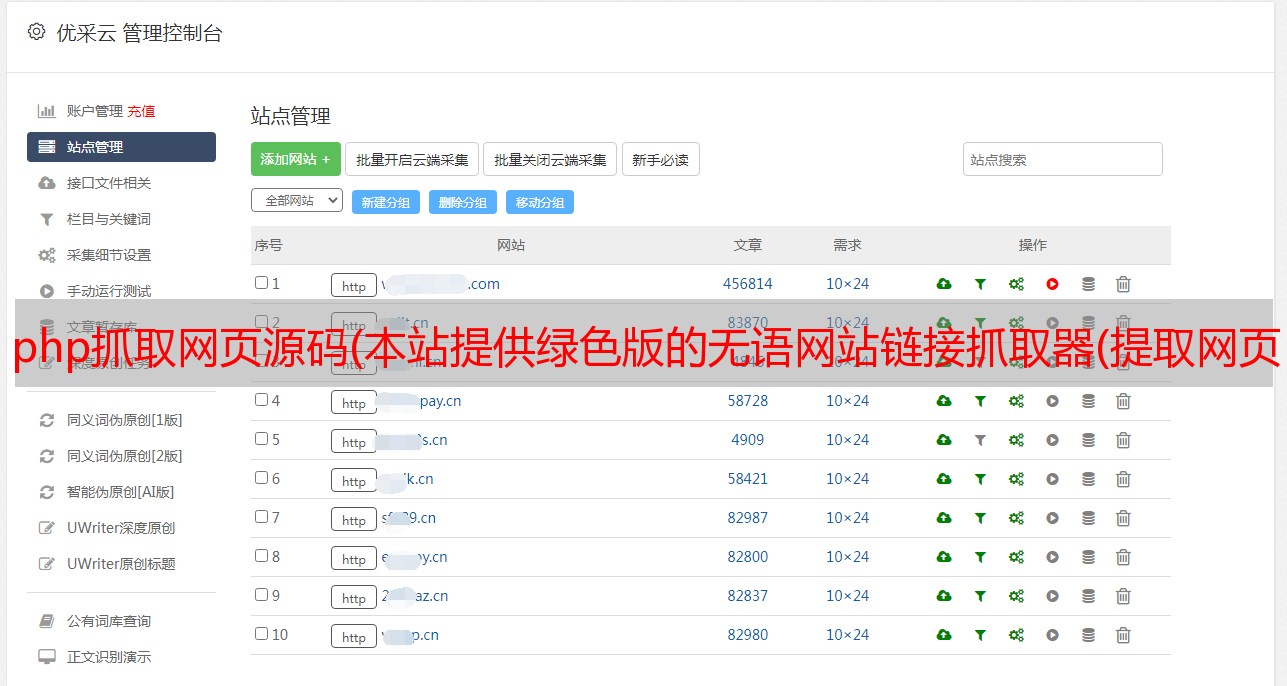

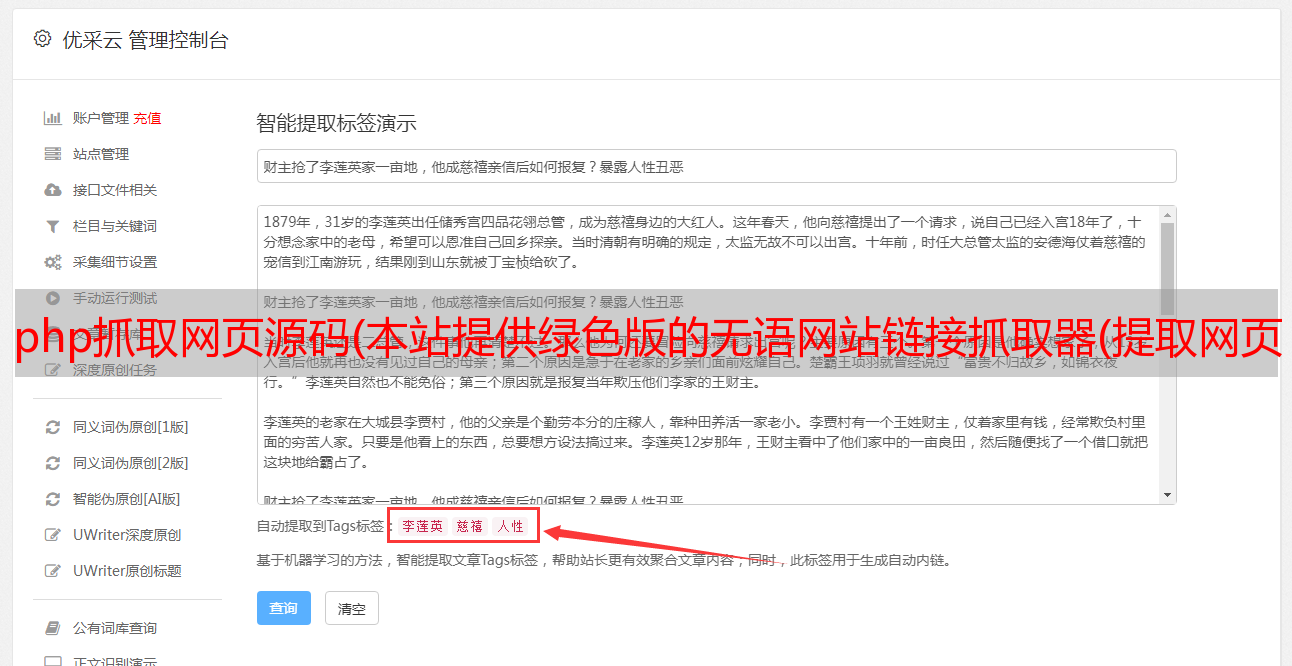

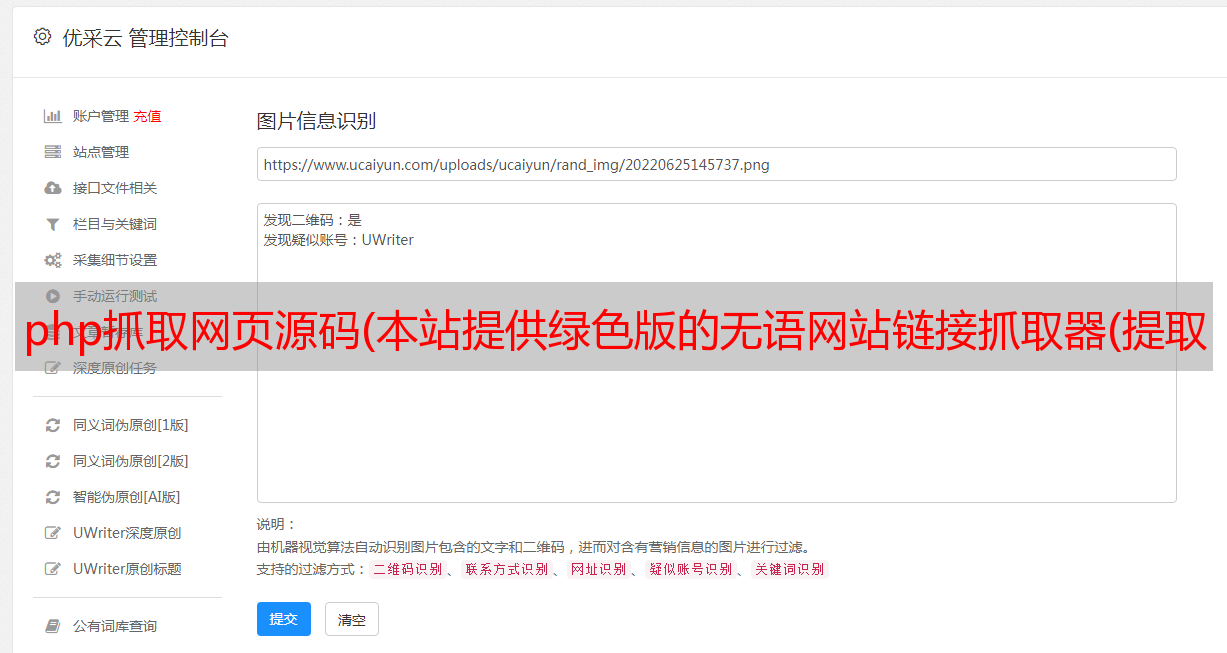

【软件截图】

【基本介绍】

网站链接抓取器是一个全站链接抓取器,可以抓取指定的网站全站页面地址并保存为文件程序,可以用来制作网站 maps 、向搜索引擎提交 URL 并检查错误、收录 等工作

网站链接抓取器有什么用?

一、制作网站地图

使用软件保存的TXT。直接上传到网站的根目录,成为一个简单的TXT网站图。

制作完网站的地图后,可以过来提交添加收录。

二、手动提交网址

可以自己提交软件爬取的链接,增加蜘蛛的爬取频率,从而增加收录的数量。可与本站“百度网址批量提交工具”配合使用。

三、检查错误

所谓的错误是指某些后端链接。不想让用户知道。但是因为程序中某处有网页链接,所以我没有提醒自己注意。这时候就可以用软件抓取网站的整个链接了。然后检查是否有任何敏感链接。

四、检查收录

您可以查看百度对本站的索引。然后用软件抓取网站的所有链接。看看数量上的差异是不是比较大。如果间隙过大,注意空间是否不稳定或画质太低或曝光率太低

网站链接抓取器用户指南

1、打开软件,输入需要爬取的网站首页地址

2、 安排和设置线程数。(线程越少,速度越慢,CPU消耗和网速越低,越不容易错过链接。线程越多,速度越快,CPU消耗和网速越高,越慢)错过爬行的概率。)

3、选择获取链接后保存的位置。(注意:如果选择的TXT名称是abc.txt,软件会保存为abc_*.txt)

4、选择每个TXT中保存的记录数。(以第三个例子为例,如果这里设置为5000,当abc_1.txt中保存的链接数达到5000时,后面的链接会自动保存在abc_2.txt中,以此类推.)

5、现在开始