seo网站日志分析工具(原始访问日志能分析出哪些问题?-八维教育)

优采云 发布时间: 2021-11-05 04:22seo网站日志分析工具(原始访问日志能分析出哪些问题?-八维教育)

如需帮忙改代码,或需要WordPress二次开发、PHP网站搭建等需求,请联系我购买付费服务:

文章内容

如果您的博客或 网站 建立在付费 Linux 主机上,如果您是该博客或 网站 的管理员,如果您甚至不知道原创访问日志是什么,或者在全部。我只能说你是一个不称职的网站管理员。一旦网站出错,你肯定会束手无策!

相信大家都在自己的网站上安装了网站统计代码,比如谷歌分析、量子统计、百度统计、cnzz、51.la等,这些工具都可以算网站的流量,即访问者在网站上可以看到的所有页面的访问次数,但是这些统计工具不能统计你主机上资源的原创访问信息,比如谁下载了某个图片。

大多数收费的 Linux 主机都提供原创访问日志。网站服务器会自动记录每个访问者访问的一些信息并保存在原创访问日志文件中。如果你的主机没有提供日志功能。建议到期后更换主机。日志记录了网站上所有资源的访问信息,包括网页打开过程中加载的图片、CSS、JS、FLASH、HTML、MP3等资源。同时,它记录了谁访问和使用了这些资源。访问了什么,访问的结果是什么等等,可以说原创访问日志记录了主机的所有资源使用情况。

如果您的网站被攻击、非法盗链、不良请求等,通过分析原创访问日志,大概可以分析出线索。例如:我今年年初上传了一个mp3到我的主机上,可惜是百度mp3。收录,引来了大量的热链接,导致我的主机流量急剧增加。虽然这对我来说不是什么大问题,但我感到很沮丧!通过分析日志,找到了问题的根源,删除了mp3,主机流量也掉了。

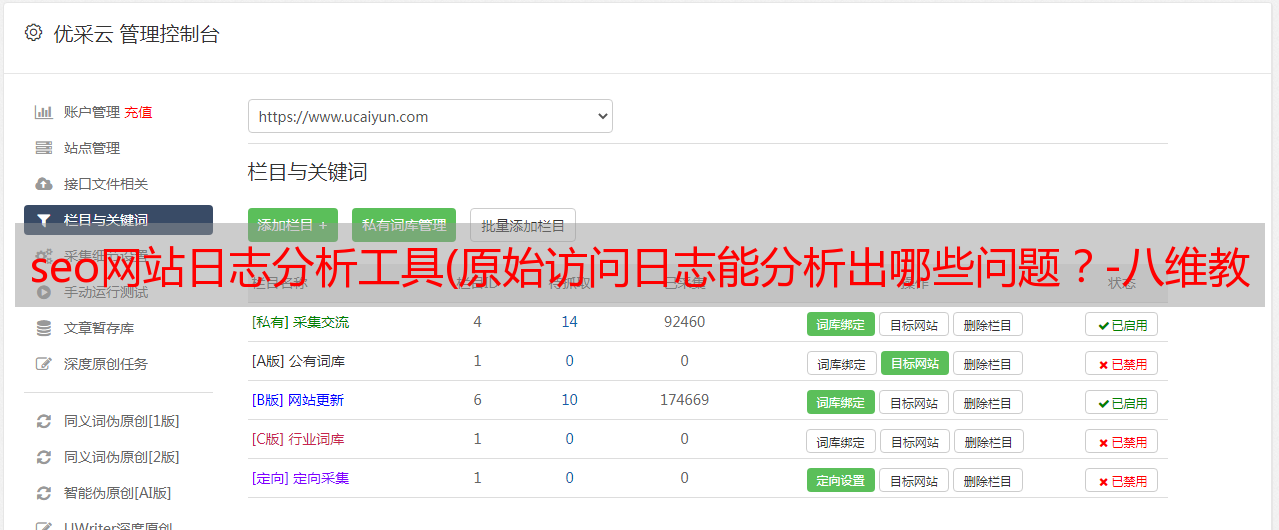

不同主机使用的面板不同,所以查看原创访问日志的方法也不同,但是Apache服务器的日志记录格式是一样的。具体查看原创访问日志的方法请咨询相关主机客服。下面是cPanel面板。您可以点击红框中的(Original Access Log)按钮下载原创访问日志,然后选择您的网站域名,用文本编辑器打开查看:

Apache服务器原创访问日志的每一行都是一条类似如下的记录:

64.10.90.61--[04/Mar/2001:11:47:26 -0600] "GET /intro.htm HTTP/1.1 "200 13947 "" "Mozilla/4.0 (兼容;MSIE 5.0;Windows 98;DigExt)"

我们来谈谈这行记录的含义:

64.10.90.61

这是访客(或机器人)的IP

[04/Mar/2001:11:47:26 -0600]

这是访问者访问资源的时间(Date),-0600是该时间对应的时区,与格林威治标准时间相差-6小时

GET /intro.htm HTTP/1.1

请求信息,包括请求方法、请求的资源和使用的协议。该句的意思是根据HTTP/1.1协议在GET方法中获取webpage/intro.htm,intro.htm是网站@上的某个网页,如果是/,则表示您正在访问主页。也可能是 POST、PUT 等。

200 13947

200为请求返回的状态码(Http Code),不同的状态码含义不同,具体请阅读HTTP状态码;13947是本次请求消耗的流量(Size in Bytes),单位是字节

对于访问者来源(Referer)。这一段告诉我们访问者是从哪里来到这个页面的。可能是你的网站其他页面,也可能是搜索引擎的搜索页面等等,通过这些来源信息,你可以找到黑客的网页。

Mozilla/4.0(兼容;MSIE 5.0;Windows 98;DigExt)

访问者使用的浏览器类型(Agent),其中记录了用户使用的操作系统、浏览器型号等

看完上面的描述,你也大概知道每行记录到底记录了什么。你可以开始独立分析你的网站原创访问日志,但是如果让你直接看这些乱七八糟的日志,相信你会很抓狂,也不愿意去做。cPanle面板中的“最新访问者”提供了查看格式化日志的方式,看起来更舒服:

上图中Host:218.17.120.205为访问者IP。可以看出,访问者在当前时间段内发起了3次请求,对应原创访问日志3行记录,红色部分为访问者请求的资源(即访问者流量的网页,等),其他部分参照以上说明。“最近访问者”只能显示最近300个IP的访问信息。这里我写了一个原创访问日志的格式化工具。可以将原创访问日志格式化为上图所示的格式,方便阅读。工具地址:

上面描述了如何查看原创访问日志,现在我们来谈谈如何分析日志的内容:

1、关注经常访问的资源

如果在日志中发现某个资源(网页、图片、mp3等)被人频繁访问,那么你应该注意该资源的使用位置!如果这些请求的来源(Referer)不是你的网站或者是空的,状态码(Http Code)是200,说明你的资源很可能被盗。你可以通过 Referer 查到被盗链接器的 URL,这可能是你的 网站 流量暴增的原因。您应该注意防止盗链。请看下面的图片。我的 网站 上的文件 japan.mp3 经常被访问。下面的图片只是日志的一部分。此人极其阴险。由于我早就删除了该文件,所以为时已晚。我在一小时内向 japan.mp3 提出了不下一百个请求。看到自己设置了反盗链,就伪造了源Referer和Agent,不停的改IP。不幸的是,它做了一切。没用,根本没有这个文件,请求状态码Http Code是403或者404

2、注意网站上不存在的资源请求

比如下图中的4个请求信息。/admin/editor/db/kmoxewebeditor.mdb等几个资源不是本站的资源,所以Http Code要么是403要么是404,但从名字分析来看,可能是一个保存数据库信息的文件。如果这些信息被别人拿走了,那么攻击你的网站就会轻松很多。发起这些请求的目的无非是扫描你的网站漏洞。通过漫无目的地扫描下载这些已知漏洞文件,你可能会发现你的网站! 通过观察,我们可以发现这些请求中使用的Agents几乎都是非常规的浏览器类型,比如Mozilla/4.0、Mozilla/5.0或者libwww-perl/等。我提供的日志格式化工具已经集成了针对这些请求的告警功能。我们可以通过禁止这些代理的访问来达到防止扫描的目的。下面将介绍具体的方法。

常见的扫描攻击还包括传递恶意参数等:

//header.php?repertoire=../../../../../../../../../../../../../../ ../proc/self/environ

/?_SERVERDOCUMENT_ROOT=

3、 观察搜索引擎蜘蛛的访问

通过观察日志中的信息,您可以看到您的网站被蜘蛛访问的频率,然后您可以看到您的网站是否受到搜索引擎的青睐,这些都是SEO关注的问题,对吧?. 日志格式化工具集成了搜索引擎蜘蛛的提示功能。常见搜索引擎蜘蛛使用的Agent列表如下:

谷歌蜘蛛

Mozilla/5.0(兼容;Googlebot/2.1;+)

百度蜘蛛

百度蜘蛛+(+)

雅虎!蜘蛛

Mozilla/5.0(兼容;Yahoo! Slurp/3.0;)

雅虎!中国蜘蛛

Mozilla/5.0(兼容;Yahoo! Slurp 中国;)

微软必应蜘蛛

msnbot/2.0b (+)

Google Adsense 蜘蛛

媒体合作伙伴-谷歌

有道蜘蛛

Mozilla/5.0 (兼容;有道机器人/1.0;;)

搜搜搜搜博客蜘蛛

Sosoblogspider+(+)

搜狗蜘蛛

搜狗网蜘蛛/4.0(+#07)

爬行器

Mozilla/5.0 (Twiceler-0.9 )'

谷歌图片搜索蜘蛛

Googlebot-Image/1.0

*敏*感*词*Yandex搜索引擎蜘蛛

Yandex/1.01.001(兼容;Win16;I)

亚历克萨蜘蛛

ia_archiver (+;)

Feedsky蜘蛛

Mozilla 5.0(兼容;Feedsky 爬虫 /1.0;)

韩国雪人蜘蛛

Yeti/1.0(NHN 公司;)

4、观察访客行为

通过查看格式化日志,可以查看和跟踪某个IP在一定时间内的一系列访问行为。单个IP访问记录越多,PV越高,用户粘性越好;IP访问记录是xixi,你应该考虑如何让你的网站内容更有吸引力。通过分析访问者的行为,可以为您的网站建设提供有力的参考。哪些内容好,哪些内容不好?确定网站的发展方向;通过分析访问者的行为,可以看出他们都是你做了什么,可以猜测访问者的意图,及时发现恶意用户。

以上只是我个人总结的一些小技巧,大家可以简单分析一下你的日志内容,毕竟我个人的知识还比较短,无法进行全面的日志分析。在cPanel主机控制面板中,还提供了两个日志分析工具awstats和webalizer。它们都是根据原创访问日志进行分析的。他们强大而富有。你可以试一试。不明白的可以咨询房东客服。

对敌对策

上面说了如何分析你的日志,我们来谈谈如何防御千里之外的敌人。这里我们以Linux主机上.htaccess的写法为例,说明如何防止恶意请求。

1、阻止IP

如果你不想某个IP访问你的网站,你可以屏蔽它。拦截方式有两种:一是在cPanel面板中有一个Security-IP Deny Manager,点击填写要拦截的IP即可;其次,在.htaccess中添加如下语句来屏蔽这两个IP 12 3.165.54.14、123.165. 54.15, and 123. 165.55 这个IP段有很多相似之处:

deny from 123.165.54.14

deny from 123.165.54.15

deny from 123.165.55

2、阻止某种浏览器类型(代理)

通常情况下,如果你使用robots扫描或恶意下载你的网站资源,它们使用的代理类型几乎相同,比如上面提到的Mozilla/4.0、。Mozilla/5.0 或 libwww-perl/ 等。您可以阻止代理以防止攻击。在 .htaccess 中添加以下规则(不一定每个主机都支持):

SetEnvIfNoCase User-Agent ".*Firefox/3\.6\.3.*" bad_agent

Order Allow,Deny

Allow from all

Deny from env=bad_agent

以上规则在Agent中屏蔽了Firefox/3.6.3的来源,这意味着包括以下示例的Agent将无法访问您的网站:

代理:Mozilla/5.0 (Windows; U; Windows NT 5.1; zh-CN; rv:1.9.2.3)壁虎/20100401 火狐/3.6.3

以上只是一个例子。您的网站不能使用,否则使用火狐3.6.3的用户将无法访问您的网站。访问的结果是 Http Code 都是403,他们看到的都是403页面,也就是禁止访问该页面。下面就教大家如何写屏蔽规则。上面语句SetEnvIfNoCase User-Agent ".*Firefox/3\.6\.3.*" bad_agent 指定了要阻止的规则,核心语句".*Firefox /3\.6\.3.*" 用于匹配收录Firefox/3.6.3的源,见正则表达式的写法,这里有几个正则示例,你可以申请:

正则表达式

影响

".*Firefox/3\.6\.3.*"

火狐匹配代理/3.6.3

"^libwww-perl"

匹配以 libwww-perl 开头的代理

"^Mozilla/4\.0$"

匹配Mozilla/4.0的agent,即Referer正好等于Mozilla/4.0

“^$”

匹配Agent为空的情况,这种情况必须禁止

“Mozilla/5\.0$”

匹配以 Mozilla/5.0 结尾的代理

从上表中,你几乎知道了一般性。在正则表达式中,都是点。写成\.; ^ 用于匹配开头,$ 用于匹配结尾;.*用于匹配任意长度的字符(包括长度为0),下面是一个完整的例子,你可以应用它,相信你也可以自己写规则:

## Block Bad Bots by user-Agent

SetEnvIfNoCase User-Agent "^libwww-perl" bad_agent

SetEnvIfNoCase User-Agent "^Mozilla/4\.0$" bad_agent

SetEnvIfNoCase User-Agent "^Mozilla/5\.0$" bad_agent

SetEnvIfNoCase User-Agent "^$" bad_agent

Order Allow,Deny

Allow from all

Deny from env=bad_agent

3、阻止一个来源(Referer)

如果某个网站经常黑你网站,不听劝说,那么你可以通过禁止其Referer来达到反盗链的目的。这里有一个例子禁止这个网站对于你的网站的热链接,常规写法和上面一样。在 .htaccess 中添加以下规则:

SetEnvIf Referer "^http://www\.google\.com" bad_referer

Order Allow,Deny

Allow from all

Deny from env=bad_referer

4、防蚂蟥

通过判断来源(Referer),可以使用下面的代码来实现一个简单的反水蛭链。下面列出的网址允许访问你的网站后缀为jpg|gif|png|css|js|bmp|mp3|wma|swf的文件,其他所有网站都禁止访问这些文件。常规写法与上述相同。您可以稍微更改域名并将其应用于您的 网站。在 .htaccess 中添加以下规则:

SetEnvIf Referer "^http://www\.ludou\.org/" local_referer

SetEnvIf Referer "^http://cache\.baidu\.com/" local_referer

# 将以下语句中的 # 去除,即可允许Referer为空的请求,一般设置允许为好

# SetEnvIf Referer "^$" local_referer

Order Deny,Allow

Deny from all

Allow from env=local_referer

5、文件重命名

即使你网站上的资源被盗,通过重命名文件也可以达到防盗的目的。毕竟小偷不知道你改了文件名,也不会整天监视你。文档。

总结

无论如何,有防守的地方就有进攻,攻防永远是一对敌人。这样的跷跷板永远不会结束。以上介绍的方法只能达到简单预防的目的。如果有人想攻击你的网站,那什么都做不了。我们只能根据对手的招式来避开。没想到,这种能力还需要站长们慢慢学习和积累。毕竟,成为网站 没那么简单。

- 超过 -

本文采用“CC BY-NC-SA 4.0”创意分享协议。转载请注明以下信息:

原创来源:露兜树博客