自动识别采集内容(授人写作任务都还没有完成,免费使用,开放源代码!)

优采云 发布时间: 2021-10-29 08:03自动识别采集内容(授人写作任务都还没有完成,免费使用,开放源代码!)

很多朋友会问:几十万的租房、二手房、工资,甚至天气数据从何而来?事实上,这些数据将在十分钟内采集可用!

一般来说,我会回答我使用特殊工具,我可以快速抓取它,而无需编程。后面肯定会问,这个工具在哪里下载?

最近比较忙,很多写作任务没有完成。授人以渔不如授人以渔。我决定将这个软件开源到 GitHub。

免费使用,开源!估计从此以后,很多爬虫工程师都会丢掉工作。. . 因为我的目标是让普通人都能用上!

这个文章介绍了爬虫的一般原理,文末会有程序地址。

◆◆◆

什么是爬虫

什么是爬虫

互联网是一个大网络,采集 数据的小程序可以形象地称为爬虫或蜘蛛。

爬虫的原理很简单。当我们访问一个网页时,我们会点击翻页按钮和超链接,浏览器会帮我们请求所有的资源和图片。所以,你可以设计一个可以在浏览器上模拟人为操作的程序,让网站误认为爬虫是正常访问者,它会乖乖的发回需要的数据。

爬虫有两种,一种是搜索引擎爬虫,像百度一样什么都抓(黑色)。另一个是开发,只精准抓取需要的内容:比如我只需要二手房信息,不想旁边有广告和新闻。

爬行动物这个名字不好听,所以我给这个软件取名Hawk,指的是'Eagle',它可以准确快速地捕捉猎物。基本上不需要编程,通过图形化的拖拽操作可以快速设计爬虫,有点像Photoshop。它可以在20分钟内为大众点评写一个爬虫(简化版只需要3分钟),然后让它运行。

以下是使用Hawk拍摄二手房的视频。建议在wifi环境下观看:

◆◆◆

自动将网页导出到 Excel

那么,当页面如此之大时,爬虫如何知道我想要什么?

当然,人们很容易看到上图中的红框是二手房信息,但机器并不知道。

网页是一棵结构化的树,重要信息所在的节点往往是繁茂的。打个不恰当的类比,当一个家族的后代形成树状家谱时,谁最强?当然:

所有人都会觉得这个家族太强大了!

当我们对整个树结构进行评分时,我们自然可以找到最强大的节点,这就是我们想要的表。找到最好的爹地后,虽然儿子长得都差不多:高大帅气,两条胳膊两条腿,这些都是共同的特征,没有多少资料。我们关心的是特征。大儿子锥子的脸和其他人不一样,那张脸是重要的信息;三儿子最有钱——钱也是我们关心的。因此,通过比较儿子的不同属性,我们可以知道哪些信息是重要的。

回到网页采集的例子,通过一组有趣的算法,给定一个网页的地址,软件会自动将其转换为Excel!(不懂?不懂就别关注这些细节!)

◆◆◆

破解翻页限制

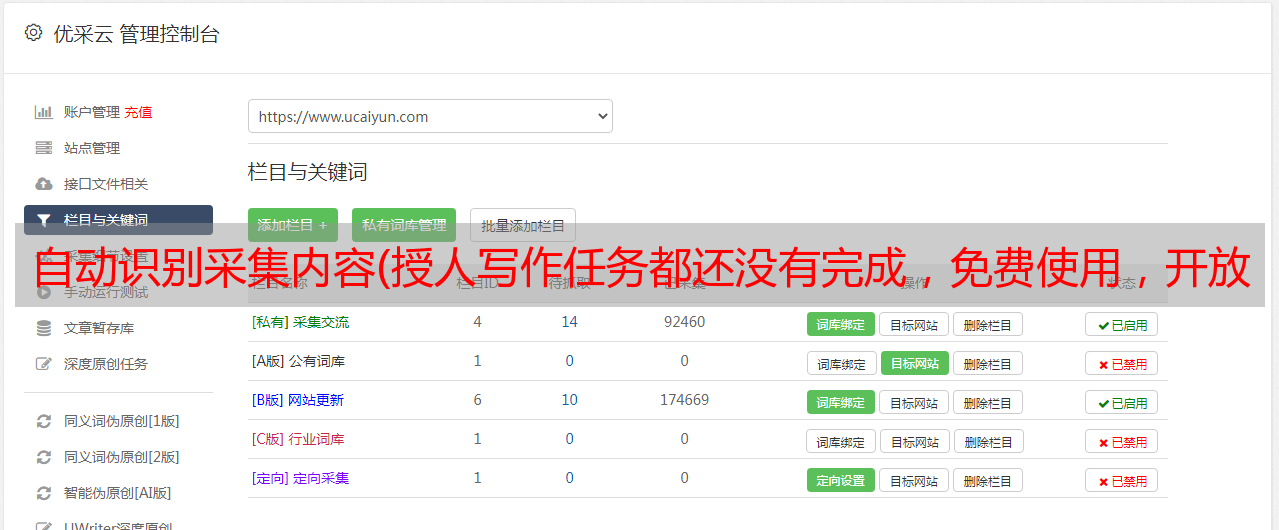

获取一页的数据,还不够,我们要获取所有页面的数据!很简单,我们让程序依次请求第1页、第2页……数据采集

有那么简单吗?网站你的宝贵资料怎么就这么轻易就被拿走了?所以只能翻到第50页或第100页。链家是这样的:

这也不打扰我们。每页有30条数据,100页最多可以呈现3000条数据。北京16个区县有2万个社区,但每个区的社区数量不到3000个。我们可以分别获取每个区的社区列表。每个社区最多有300多套二手房在售,可以让联家所有的二手房都可以买到。

然后我们启动抓取器,Hawk会为每个子线程分配任务(可以理解为机器人):为我抓取这个社区所有的二手房!然后你会看到一个壮观的场景:一群小机器人协同工作,从网站中移动数据,有没有超级牛迅雷?同时执行 100 个任务!!我从厕所回来的时候会抓住它!!!

◆◆◆

清理:识别和转换内容

获得的数据如下所示:

但是你会看到,里面会有一些奇怪的字符应该被删除。xx 平方米应该是所有提取的数字。而售价,有的213万元,有的373万元,这些都很难对付。

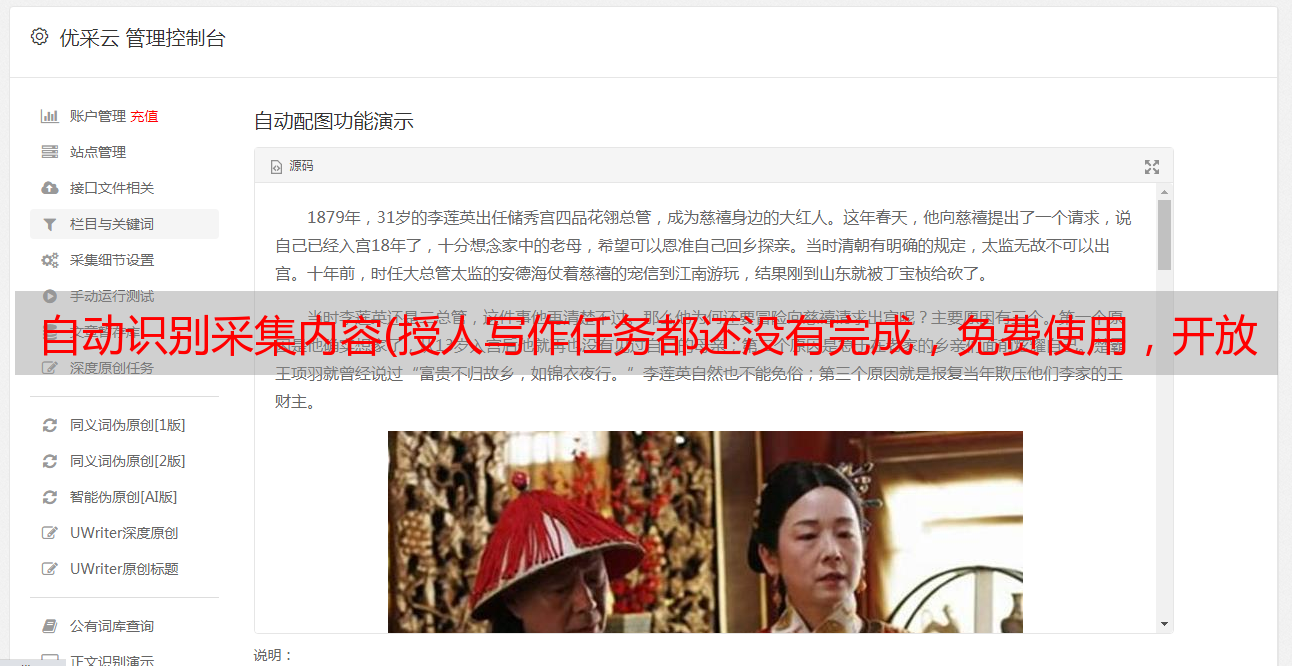

不过没关系!Hawk 可以自动识别所有数据:

哈哈,那你就可以轻松的用这些数据进行分析了,纯净无污染!

◆◆◆

破解需要登录网站

这里的意思当然不是破解用户名和密码,还不够强。网站的部分数据需要登录才能访问。这不打扰我们。

当您打开 Hawk 内置的嗅探功能时,Hawk 就像一个录音机,会记录您对目标 网站 的访问。之后,它会重播它以实现自动登录。

您是否担心 Hawk 会保存您的用户名和密码?如何自动登录而不保存?但是 Hawk 是开源的,所有代码都经过审查并且是安全的。您的私人信息只会存在于您自己的硬盘中。

(我们是这样自动登录到大众点评的)

◆◆◆

我也可以抓取数据吗

理论上是这样。但路高一尺,魔力高。不同的网站无限不同,对抗爬虫的技巧也很多。而且这些错误对细节非常敏感。只要你犯了一个错误,接下来的步骤可能不会继续。

怎么做?沙漠先生保存并分享了之前的操作,您只需加载这些文件即可快速获取数据。

如果你有网站的其他采集需求,可以去找身边的程序员请他们帮忙采集数据,或者让他们试试Hawk,看看谁的效率更高。

如果你是文科生女生,我建议你看看东野圭吾和村上春树。直接使用这么复杂的软件会让人抓狂的。那么我应该打电话给谁来帮助捕获数据?呵呵……

◆◆◆

我在哪里可以获得软件和教程?

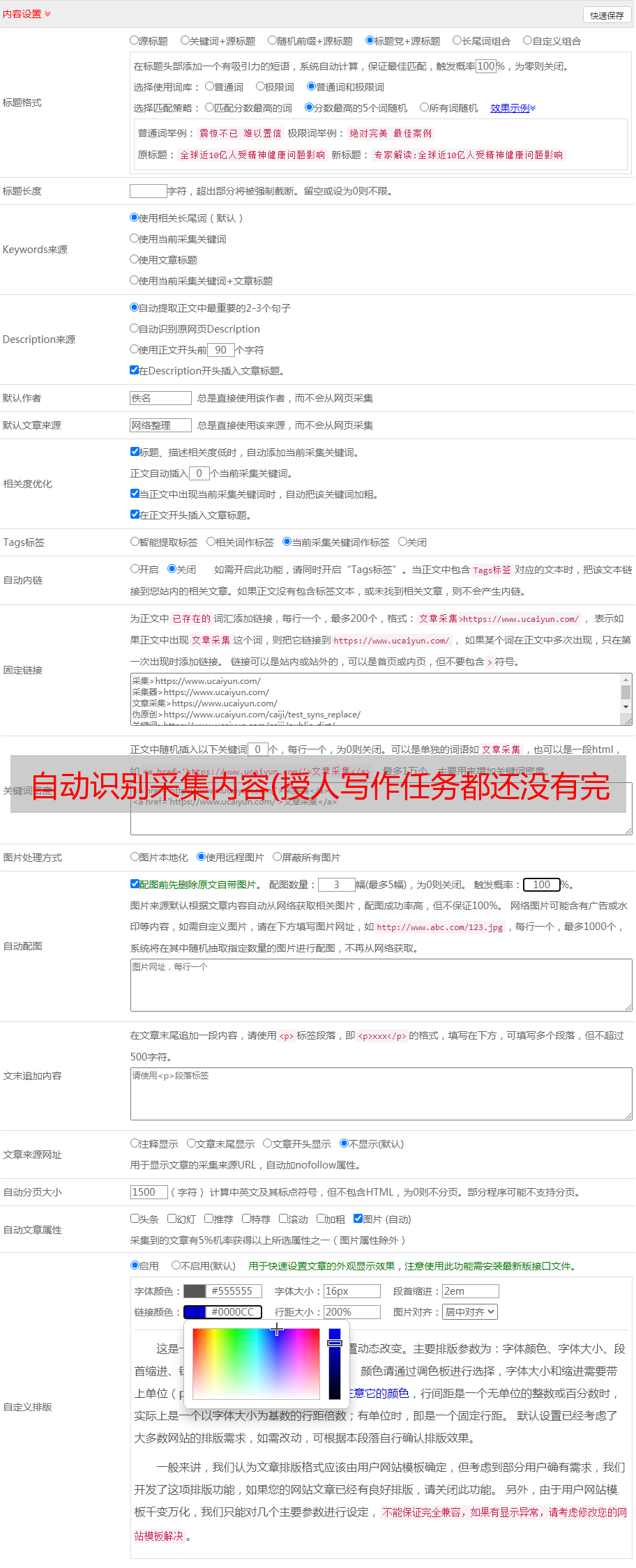

Hawk:用C#/WPF编写的Advanced Crawler&ETL工具软件介绍

HAWK是一个数据采集和清理工具,按照GPL协议开源,可以灵活有效地从网页、数据库、文件中采集,并通过可视化拖拽,快速生成和过滤,转换等操作。其功能最适合的领域是爬虫和数据清洗。

Hawk的意思是“鹰”,可以有效准确地杀死猎物。

HAWK采用C#编写,前端界面采用WPF开发,支持插件扩展。通过图形化操作,可以快速建立解决方案。

GitHub地址:

它的 Python 等效实现是 etlpy:

作者专门开发的项目文件已经发布在GitHub上:

使用时,点击文件加载项目即可加载。

如果不想编译,可执行文件在:

密码:4iy0

编译路径为:

Hawk.Core\Hawk.Core.sln