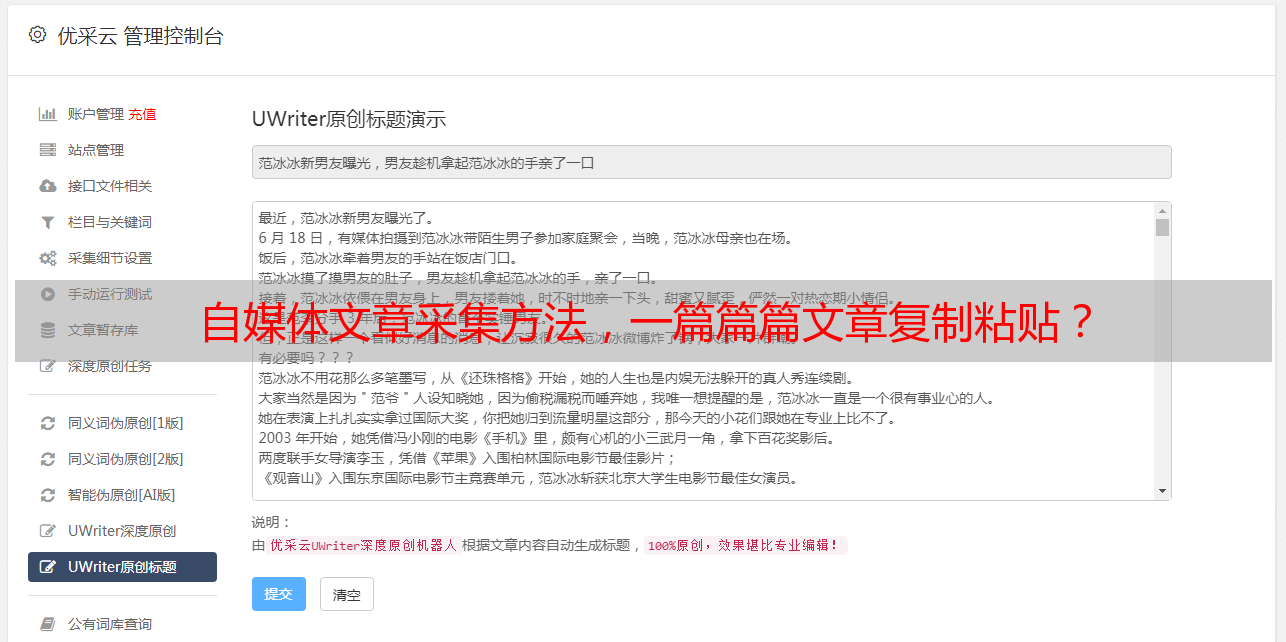

自媒体文章采集方法,一篇篇篇文章复制粘贴?

优采云 发布时间: 2021-01-22 12:29自媒体文章采集方法,一篇篇篇文章复制粘贴?

自媒体文章采集方法

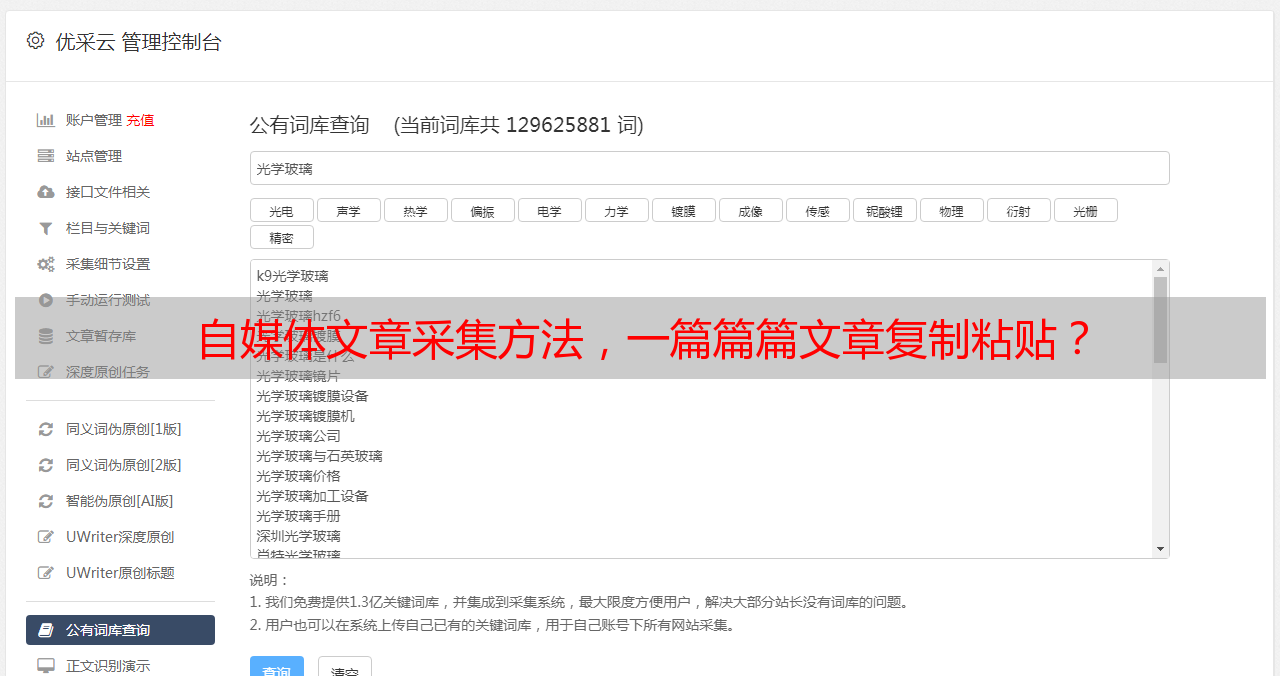

随着移动互联网的发展,获取信息或发布信息变得非常方便。近年来,自媒体也成为一个热门话题,其中有些自媒体发布了许多高质量的文章,如果我们想获得更多机会,可以使用更多的渠道查看这个成千上万的世界这些自媒体文章采集下来,如果我们使用最快最有效的方法呢?要在今天的头条新闻中保存新闻以及在搜狗微信上保存文章文字,该怎么办?复制并粘贴一篇文章?选择通用的网页数据采集器将使工作更加容易。

优采云是常规网页数据采集器,可以是Internet上的采集公共数据。用户可以设置从哪个网站爬网数据,要爬网的数据,要爬网的数据范围,何时爬网的数据,如何保存已爬网的数据等。

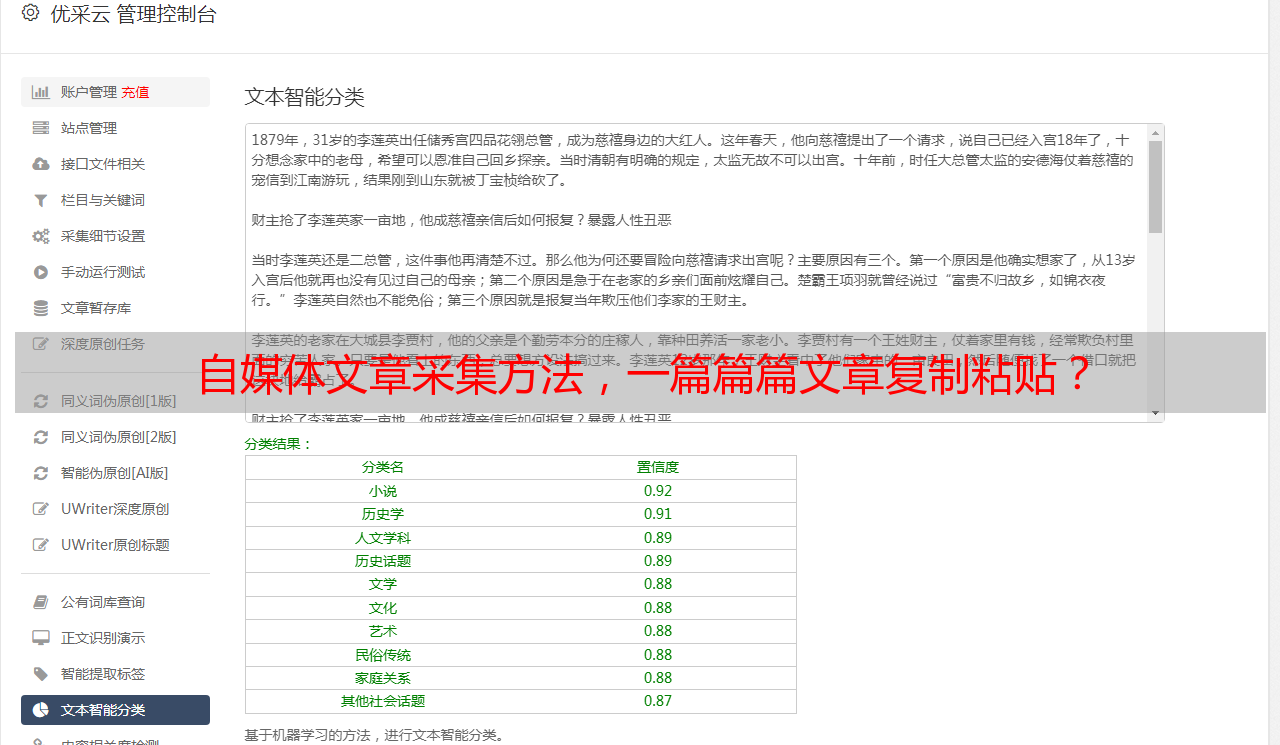

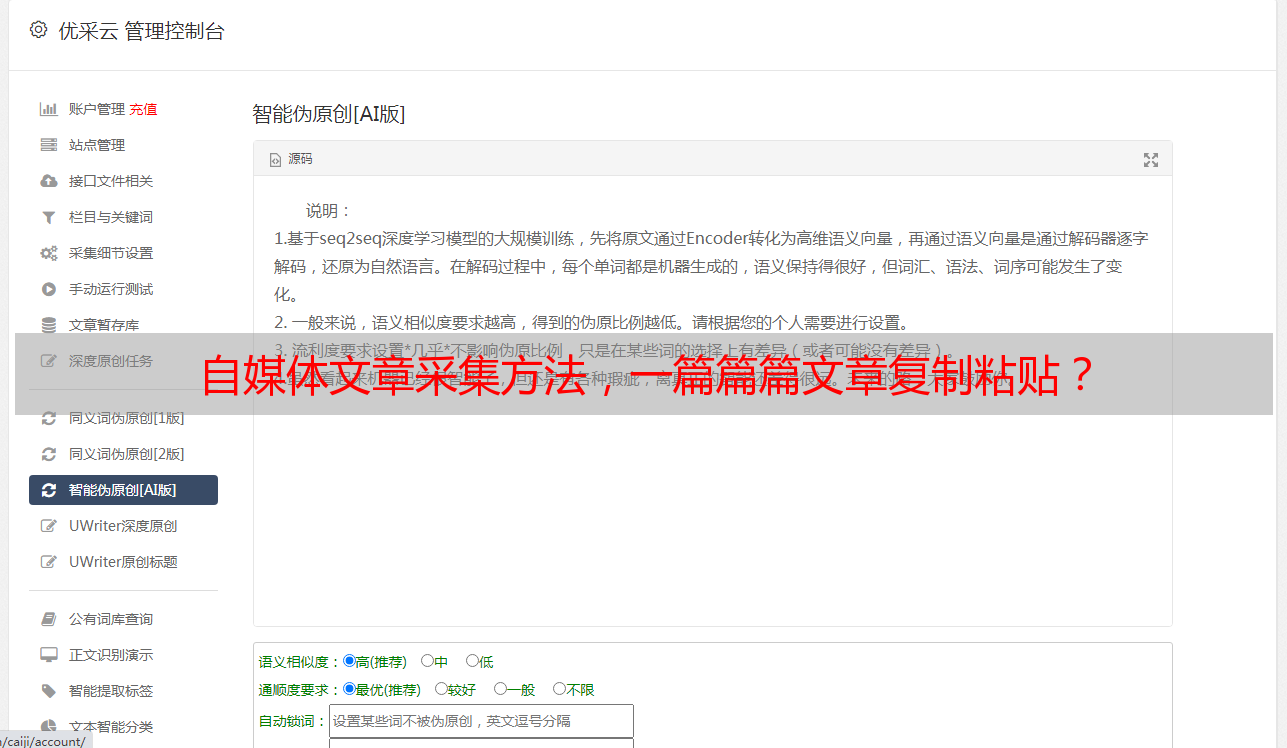

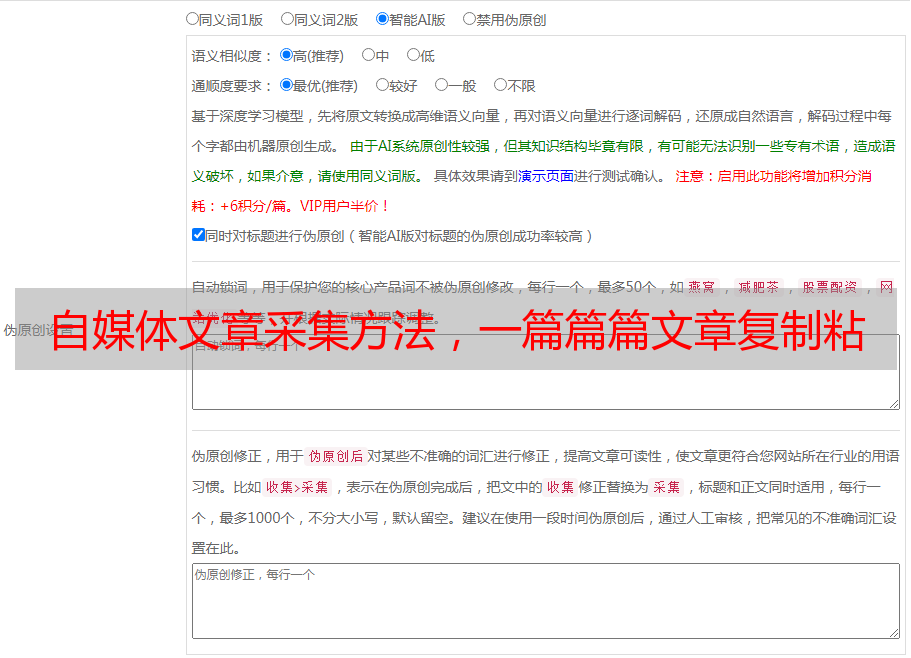

回到主题,本文将以搜狗微信的文章文本采集为例,说明如何使用优采云 采集网页文章文本。 文章主要文字采集有两个主要类别:一、采集 文章正文中没有图片的文字;主文本和图片URL中的二、采集 文章文本。

示例网站:

使用功能点:

Xpath

审判条件

分页列表信息采集

一、采集 文章正文中的文字,没有图片

具体步骤:

第1步:创建采集任务

1)进入主界面,然后选择“自定义模式”

自媒体文章采集第1步

2)复制采集的URL并将其粘贴到网站输入框中,单击“保存URL”

自媒体文章采集第2步

第2步:创建翻页循环

1)在页面的右上角,打开“过程”以显示两个部分:“过程设计器”和“自定义当前操作”。打开网页后,默认情况下会显示“热” 文章。向下滚动页面,找到并单击“加载更多内容”按钮,在操作提示框中选择“更多操作”

自媒体文章采集第3步

2)选择“循环单击单个元素”以创建翻页循环

自媒体文章采集第4步

由于该网页涉及Ajax技术,因此我们需要设置一些高级选项。选择“单击元素”步骤,打开“高级选项”,选中“ Ajax加载数据”,将时间设置为“ 2秒”

自媒体文章采集第5步

注意:AJAX是一种延迟加载和异步更新的脚本技术。通过在后台与服务器进行少量数据交换,可以在不重新加载整个网页的情况下更新网页的特定部分。请查看详细信息

AJAX点击和翻页教程:

通过观察网页,我们发现单击5次“加载更多内容”后,页面加载到底部,总共显示了100篇文章文章。因此,我们将整个“循环旋转”步骤设置为执行5次。选择“循环翻页”步骤以打开

“高级选项”,打开“满足以下条件时退出循环”,将循环次数设置为“ 5次”,然后单击“确定”

自媒体文章采集第6步

第3步:创建列表循环并提取数据

1)移动鼠标并选择页面上的第一个链接文章。系统会自动识别相似的链接,在操作提示框中选择“全选”

自媒体文章采集第7步

2)选择“单击循环中的每个链接”

自媒体文章采集第8步

3)系统将自动进入文章详细信息页面。单击需要采集的字段(此处单击文章的标题),在操作提示框中,选择“ 采集该元素的文本”。 文章发布时间,文章来源字段,与采集相同的方法

自媒体文章采集第9步

4)接下来将开始采集 文章文本。点击文章文本的第一段,系统将自动识别页面中的相同元素,选择“全选”

自媒体文章采集第10步

5)可以看到所有文本段落均已选中并变为绿色。选择“ 采集以下元素文字”

自媒体文章采集第11步

注意:在字段表中,您可以自定义字段的修改

自媒体文章采集第12步

6)完成上述操作后,文本将全部采集向下(默认情况下,文本的每个段落都是一个单元格)。一般来说,我们希望采集的文本合并到同一单元格中。单击“自定义数据字段”按钮,选择“自定义数据合并方法”,选中“多次提取并将同一字段合并到一行,即,追加到同一字段,例如文本页面合并”,然后点击“确定”

自媒体文章采集第13步

“自定义数据字段”按钮

自媒体文章采集第14步

选择“自定义数据合并方法”

自媒体文章采集第15步

如图所示进行检查

第4步:修改Xpath

1)选择整个“循环步骤”并打开“高级选项”,您可以看到优采云默认情况下会生成固定元素列表,并找到前20条文章的链接文章

自媒体文章采集第16步

2)在Firefox中打开网页至采集,并查看源代码。我们通过此Xpath发现了这一点:

// DIV [@ class ='main-left'] / DIV [3] / UL / LI / DIV [2] / H3 [1] / A,页面上需要的所有100篇文章文章已定位

自媒体文章采集第17步

3)将修改后的Xpath复制并粘贴到优采云中显示的位置,然后单击“确定”

自媒体文章采集第18步

第5步:修改流程图结构

我们继续观察到,单击5次“加载更多内容”后,此页面将加载所有100篇文章文章。因此,我们配置规则的想法是首先建立一个翻页周期,加载全部100 文章,然后创建一个周期列表以提取数据

1)选择整个“循环”步骤并将其拖出“循环翻转”步骤。如果您不这样做,将会有很多重复的数据。