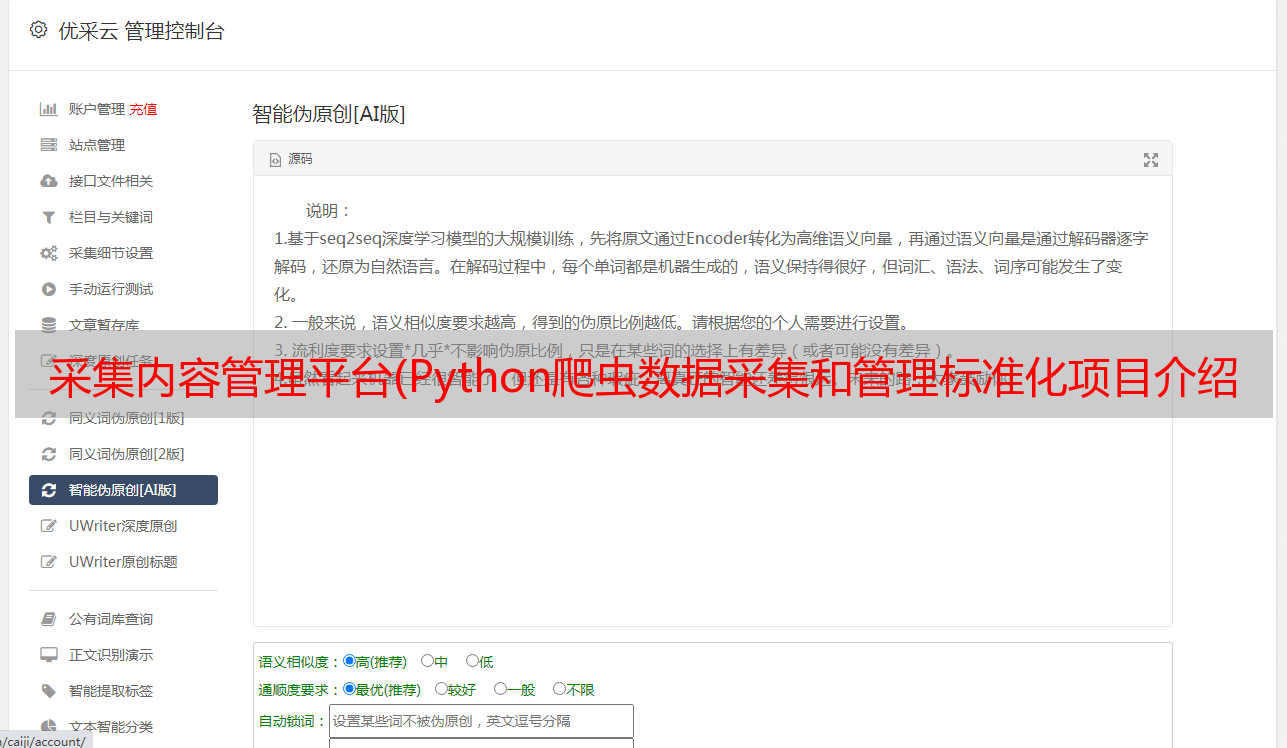

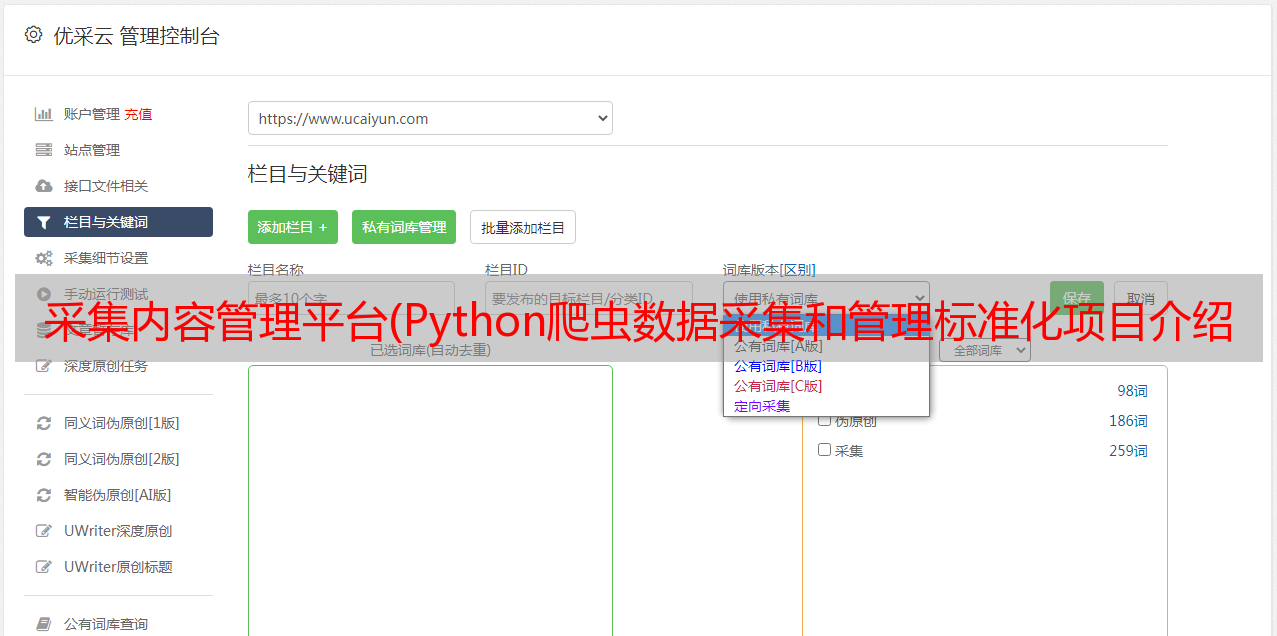

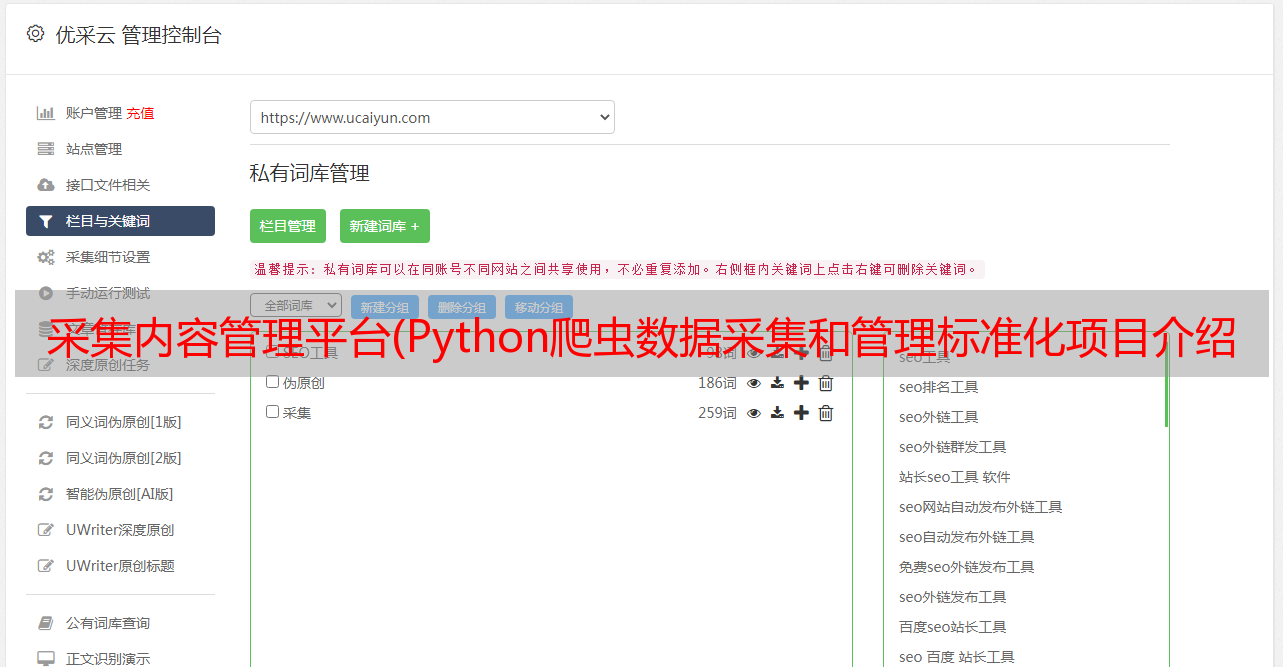

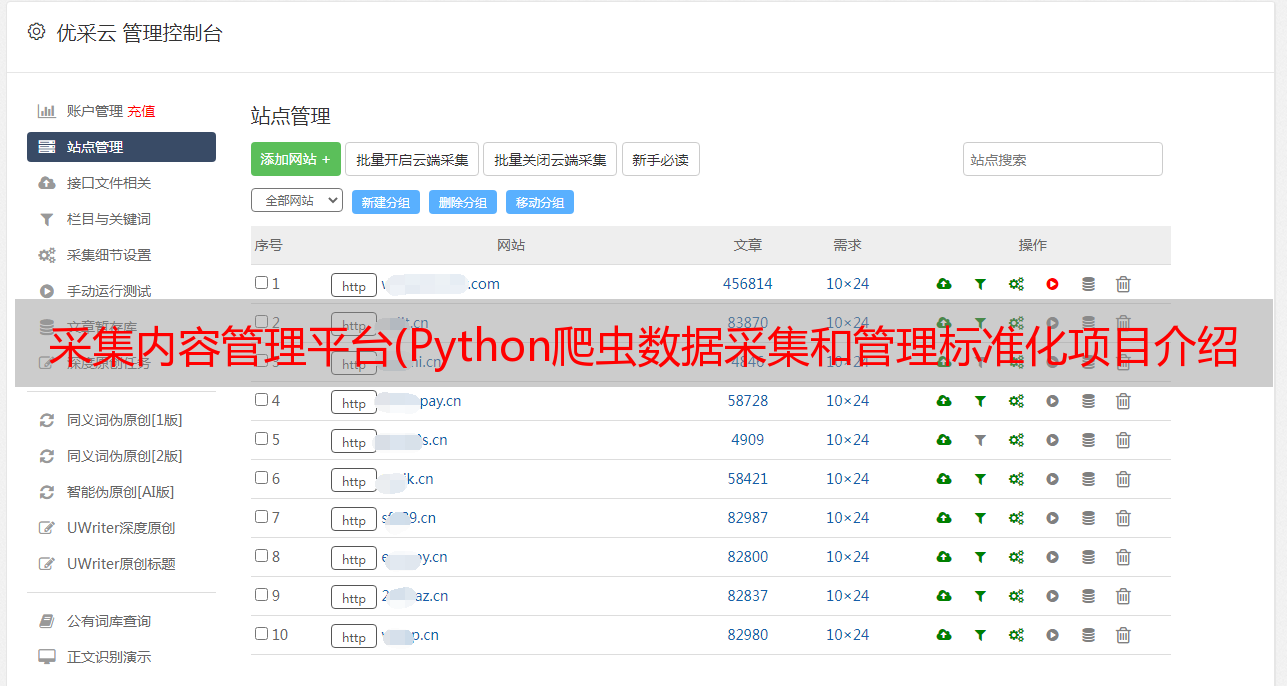

采集内容管理平台(Python爬虫数据采集和管理标准化项目介绍与管理项目)

优采云 发布时间: 2021-10-20 07:18采集内容管理平台(Python爬虫数据采集和管理标准化项目介绍与管理项目)

介绍

本文介绍了基于我多年的行业经验,在巨头的肩膀上开发的数据采集应用,也就是我们通常所说的爬虫系统。

由于系统不是单独的爬虫脚本,所以是整套自动化采集的内容。我尝试了很多方法来搭建这个系统,这里分享一个最简单、易实现、效果最好的内容。现在各大日常数据相关公司基本都采用这种数据采集技术,简单、快捷、实用。下面简单介绍一下基于Python Django的产品设计和应用。

业务流程

遇到问题

各种使用中的问题可以百度或者我的专栏。如果没有这样的事情,你可以留言或在我。这里只介绍业务流程和功能使用。

我的项目

1.整理数据采集文档

在Excel表格网站中整理抓取的目标,用数据透视图这样整理。

如果用笨方式而不是穷举方式来采集,这一步是不可避免的。

因为抓到的数据有不同的用途,所以前期最好多做一些基础的工作,不然后期清理数据会很麻烦。比如文章的分类和来源,方便后期维护和管理。

具体脚本编写方法参考专栏中的Scrapy目标网站抓取示例。

或者看这里【Python爬虫数据采集及管理标准化项目】项目介绍和内容目录索引。

在记录的形式中,组织成这样,Spider下的py文件对应脚本名。

2.Scrapy 框架爬虫脚本是根据模板编写的。采集 编写脚本并制作成标准化脚本,方便维护和编写。

根据模板,所有捕获数据的页面都可以根据该模板进行应用。然后在本地调试,保证数据可以写入Mongodb。

3.Gerapy框架实现爬虫管理

部署主机。如果有多台机器,可以单独部署同一个脚本,也可以在不同的机器上部署不同的脚本,看个人喜好。这里的项目就是上面Scrapy写的可执行脚本。

然后根据项目打包部署。

部署完成后,在编写好的Spider下设置爬虫脚本。这里部署脚本可以设置各种参数,例如每次执行的间隔和开始时间。

您可以查询每个脚本的执行状态。

部署后,数据可以完全自动化采集。

最后进入mongodb查看采集的数据。

然后每个爬虫脚本重复循环。